LR的推导

LR逻辑回归是一种监督学习分类算法,其实现了给定数据集到0,1的一种映射。

给定数据集D={(x1,y1),(x2,y2),...,(xm,ym)},其中(xi,yi)表示第i个样本,其中,xi=(xi1,xi2,...,xin),即每个数据有n个特征,类别y={0,1},要求训练数据,将数据分成两类0或1。

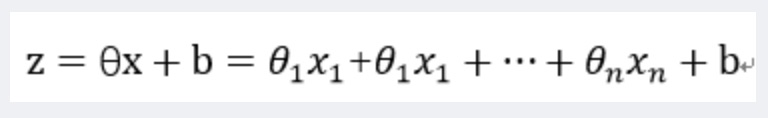

假定xi的n个特征为线性关系,即:

这里为了表示简洁,在数据样本xi添加一个特征x0=1,将b作为一维特征。则有:

以上实现了用样本xi的n个特征来表示样本的表达式,现在需要寻找一个映射使得z可以转换为0或者1。

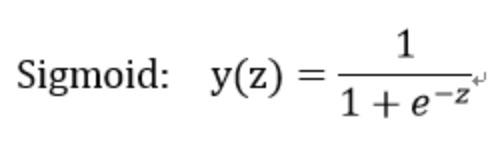

可以使用阶跃函数,但是阶跃函数性质不好,不可导求解过于复杂,这里选用Sigmoid函数:

当输入一个Z时,y输出一个0--1之间的数,假定y>0.5则最终结果判为1,y<0.5最终结果为0。当y=0.8时,最终结果为1,y=0.8也表征了此时输出为1的概率,令:

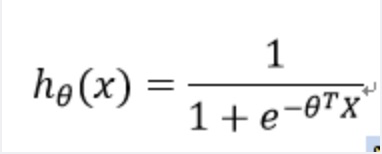

将样本特征线性表示,然后输入到Sigmoid函数,输出结果在0--1之间,并且输出结果表征了分类结果为1的概率,即有:

因此,可求得预测值为y的概率表达式为:

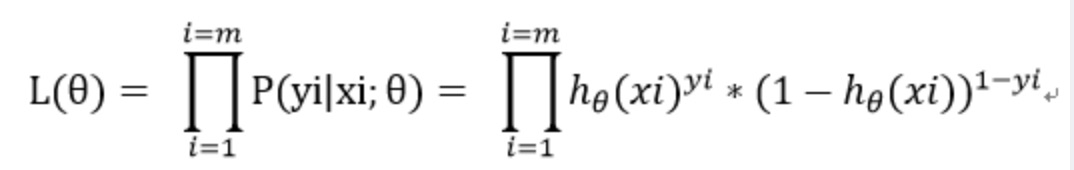

假设样本独立且同分布,最大似然估计:

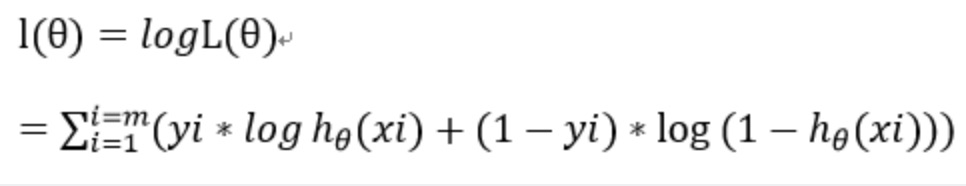

进而求最大对数似然估计:

那么,LR的损失函数是什么:

损失函数表征预测值与真实值之间的差异程度,P(Y|X)为样本为Y的概率,数值越大说明预测值与真实值越接近即损失函数应该越小,当P(Y|X)越大的,-logP(Y|X)越小,刚好符合损失函数的定义。

在此损失函数可以取为最大似然估计函数的相反数,其次除以m这一因子并不改变最终求导极值结果,通过除以m可以得到平均损失值,避免样本数量对于损失值的影响。

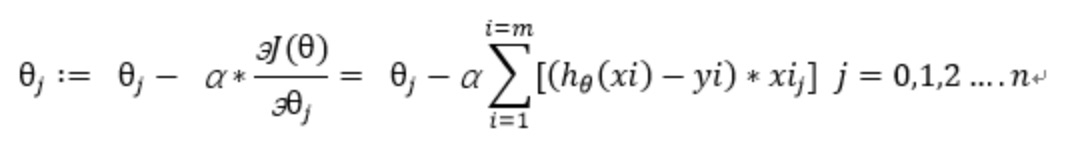

这里采用随机梯度下降,损失函数求偏导:

迭代公式:

损失函数:表征模型预测值与真实值的不一致程度。记为函数L(Y,f(X))

结构风险函数 = 经验风险项 + 正则项 其中损失函数为经验风险项的重要组成部分

前半部分为经验风险项,后半部分为正则项。