数据压缩之数据去重简介

什么是Data deduplication

数据去重,简单地说就是重复数据删除。从某种意义上说也是一种数据压缩技术。

-

数据去重的优势

节约磁盘空间:对于村出在同一个磁盘上的同一个文件或者是不同的文件之间的重复数据删除可以大大减少磁盘的使用量。

节约网络带宽:去重之后的数据在网络上传输可以大大降低网络资源的占用。很多网络同步工具都采用源端数据去重后再上传数据以节约网络带宽。

提升写磁盘性能:数据在磁盘和内存之间的传输是存储系统的瓶颈,如果将数据去重之后再写入磁盘就可以大大提高磁盘的读写性能。

利于虚拟服务器存储:如果为不同的服务建立多个虚拟机,其实这些虚拟机的系统是相同的,如果采用去重技术,将大大减少不必要的资源浪费,将磁盘空间用于有效数据的存储。

数据去重由于其在网络以及节省磁盘方面的绝对优势,已经被广泛应用到存储、网盘、云服务、邮件服务等方面。

- 数据去重的分类

| 分类标准 | 分类结果 |

|---|---|

| 去重时间 | 在线/离线去重 |

| 去重粒度 | 文件级别/块级别 |

| 分块方式 | 定长块/边长块 |

| 数据处理位置 | 源端/目的端 |

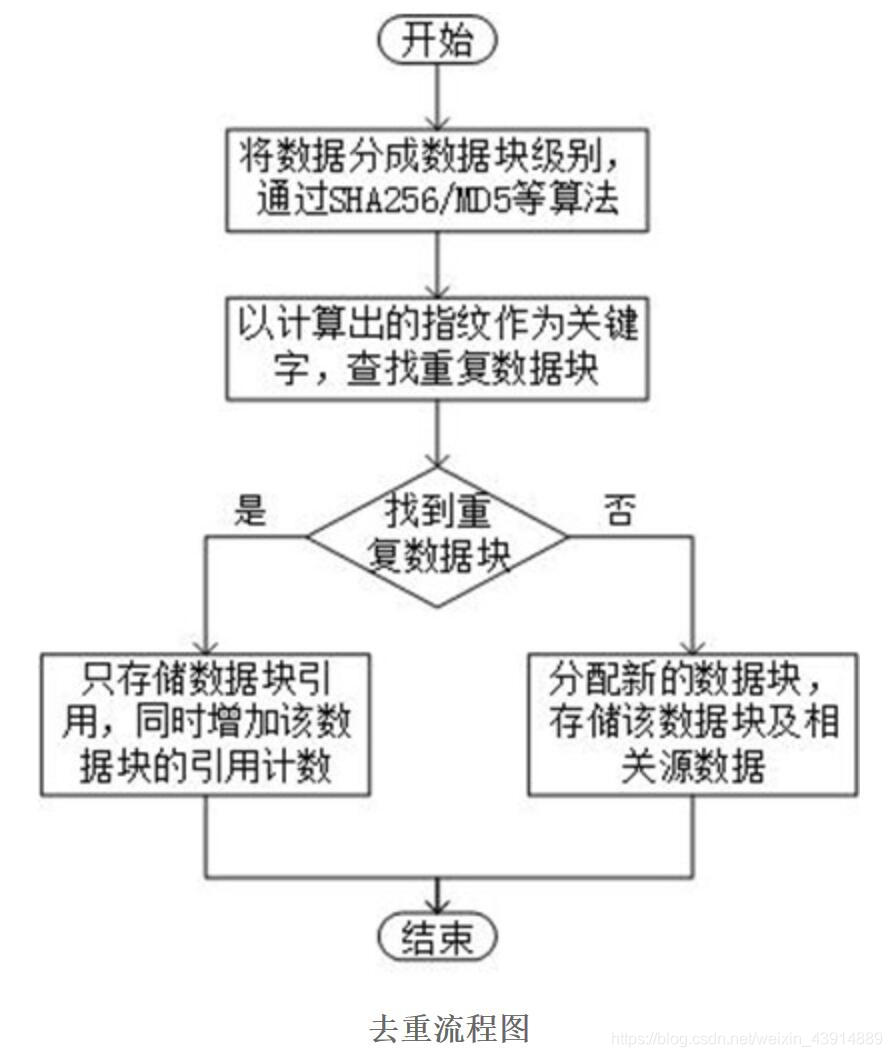

- 一般去重流程

为什么要数据去重

- 世界上的数字数据量正呈爆炸式增长,由于这种“数据泛滥”,如何有效地管理存储成为大数据时代海量存储系统最具挑战性和重要的任务之一。

- 根据IDC最近的一项研究,近80%的受访公司表示,他们正在其存储系统中探索重复数据消除技术,以减少冗余数据,从而提高存储效率和降低存储成本

说白了就是重复的东西多了,但是地方只有那么大,必须要减少重复

核心:提高存储效率和降低存储成本

一般来说,典型的块级重复数据消除系统将输入数据流(如备份文件、数据库快照、虚拟机映像等)分割成多个数据“块”,每个数据“块”由加密安全哈希签名(如SHA-1,也称为指纹)唯一标识和检测到重复。这些块可以固定大小如文件块,或由内容本身决定的可变大小单位。然后,重复数据消除系统删除重复的数据块,并仅存储或传输其中的一个副本,以实现节省存储空间或网络带宽的目标。