2.1 经验误差与过拟合

错误率:错分样本的占比

精度:分对样本的占比,与错误率是互补的。

误差:样本真实输出与预测输出之间的差异。学习器在训练集上的误差称为训练误差或经验误差,在新样本上的误差称为泛化误差。

由于事先并不知道新样本的特征,我们只能努力使经验误差最小化; 很多时候虽然能在训练集上做到分类错误率为零,但多数情况下这样的学习器并不好

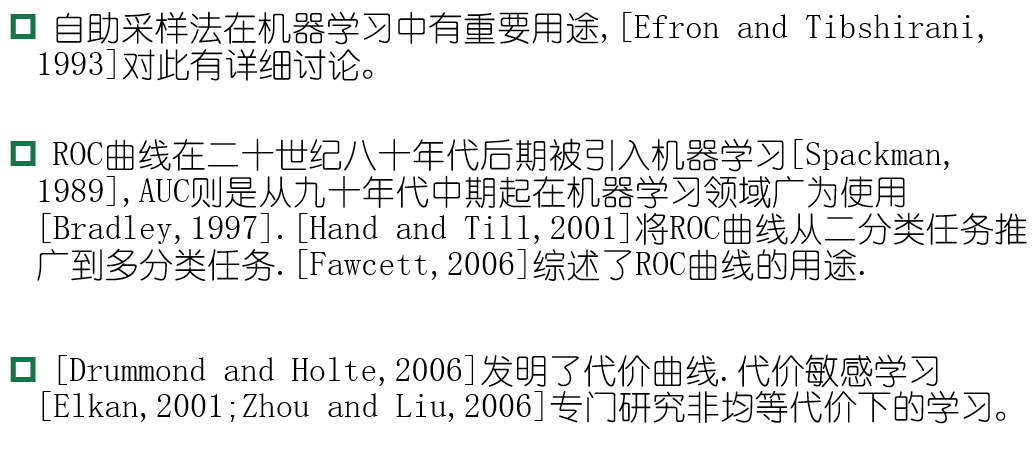

过拟合:学习器把训练样本学习的“太好”,将训练样本本身的特点 当做所有样本的一般性质,导致泛化性能下降;

解决措施:1.优化目标加正则项 ;2.early stop;

欠拟合:对训练样本的一般性质没有学习好

解决措施:1.决策树:拓展分支 ; 2.神经网络:增加训练轮数;具体表现如下图所示:

2.2 评估方法

前提:现实任务中往往会对学习器的泛化性能、时间开销、存储开销、可解释性等方面的因素进行评估并做出选择。

我们假设测试集是从样本真实分布中独立采样获得,将测试集上的“测试误差”作为泛化误差的近似,所以测试集要和训练集中的样本尽量互斥。通常将包含m个样本的数据集分为测试集T和训练集S,下面介绍几种常用的方法:

留出法:

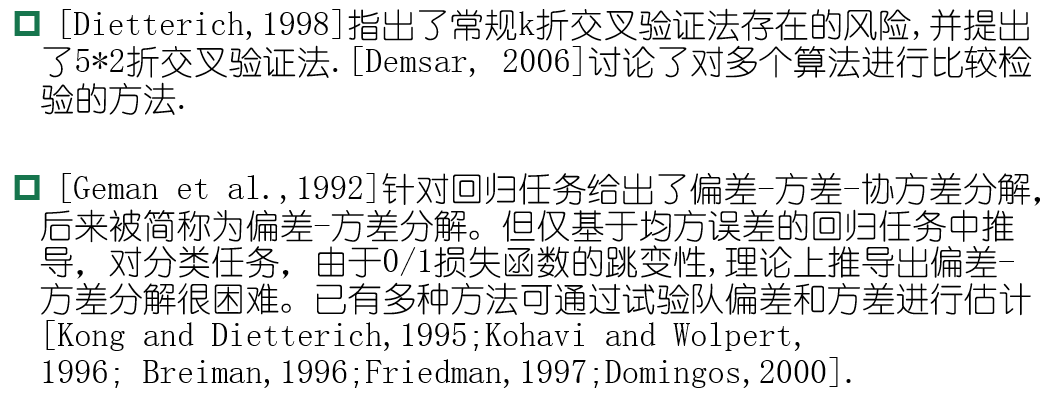

交叉验证法:

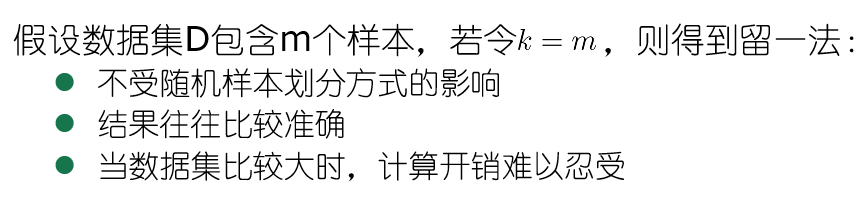

留一法的意思就是将每个样本都变成一个独立的子集,这样取一个留剩下所有个的做法就是留一法。

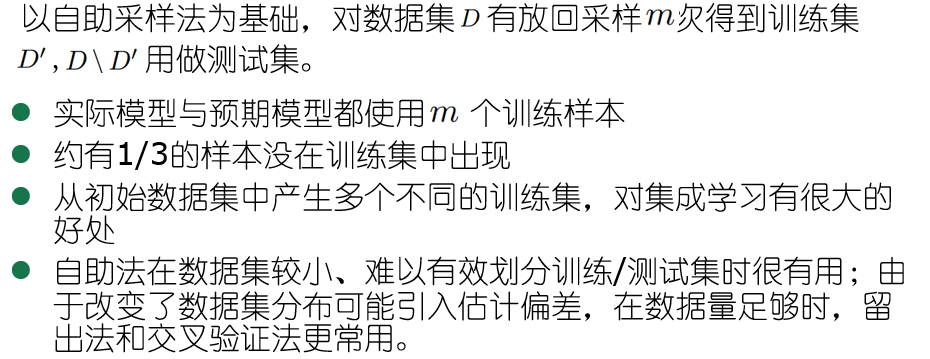

自助法:

解释一下大概1/3概率的来源:

![]()

这里的N相当于上文提到的 m ,每次不放回地抽样N个样本,最后取极限没有被抽到的样本的数目即使上述式子取极限。

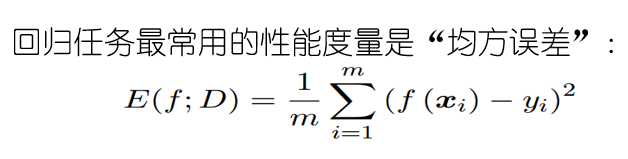

2.3 性能度量

2.3.1定义:对学习器的泛化性能进行评估,不仅需要有效可行的实验方法还需要有衡量模型泛化能力的评价标准,此评价标准就是性能度量。

给定样例集: ,其中yi是示例xi 的真实标记,我们的目标就是把学习器的预测结果f(x)与真实标记y进行比较。

,其中yi是示例xi 的真实标记,我们的目标就是把学习器的预测结果f(x)与真实标记y进行比较。

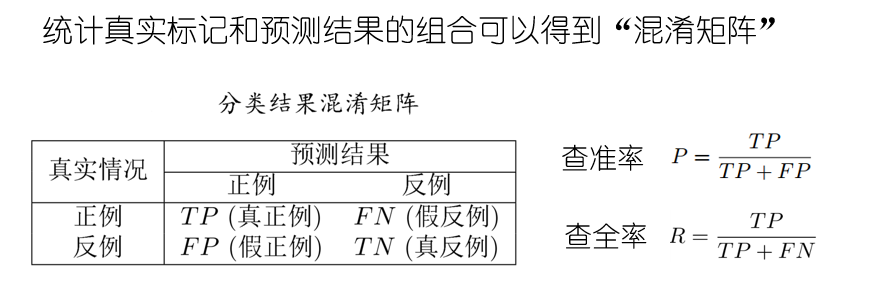

2.3.2查准率与查全率:

其中TP的意思是True Positive ,FN是Flase Negative,其余的类推。(混淆矩阵请自行百度)

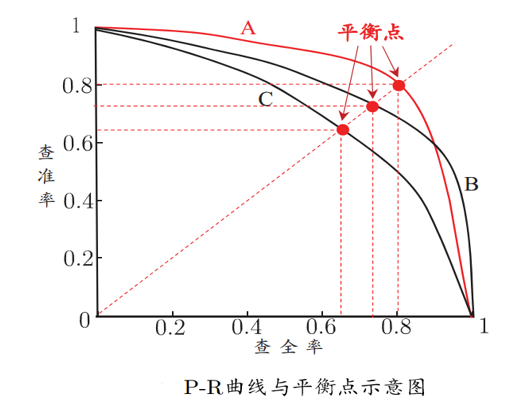

查准率P的意思是在预测结果中挑到真确的比例,类似于小圈子里面的内推,这样P、R的意思就很容易理解了。而后根据学习器的预测结果按正例可能性大小对样例进行排序,并逐个把样本作为正例进行预测,则可以得到查准率-查全率曲线,简称“P-R曲线”

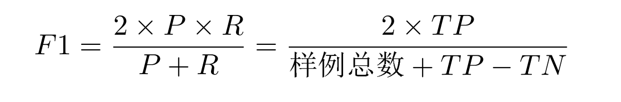

平衡点(BEP)是曲线上“查准率=查全率”时的取值,可用来用于度量P-R曲线有交叉的分类器性能高低,我们的主观当然是P和R越大越好,所以说若一个曲线能被另一个完全包住则说明被包住的性能没有外面的优越,比如优越性能排行:A>B>C,在很多情况下,一般是比较P-R曲线的面积来判断优越性,面积越大则越好。但是这个面积值又不太容易估算,我们就选择平衡点的值来进行比较,值越大越好。但是BEP又过于简单了,于是采用F1度量:

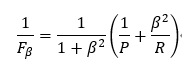

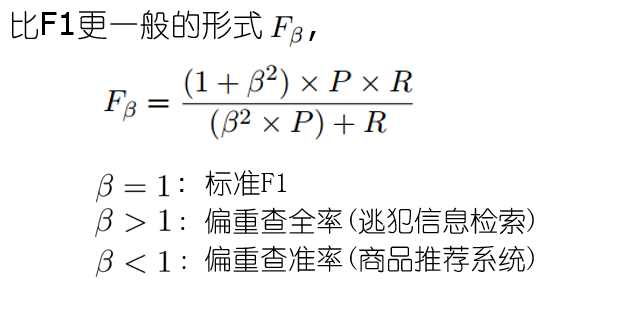

采用调和平均的定义:

F1即把角标贝塔等于1即可,通过化简:

在西瓜书上还有宏的查准率和查全率的概念,其实就是取了一个平均罢了。这里就不急于赘述了,有兴趣可以自行看书。

2.3.3ROC与AUC

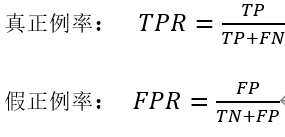

定义:类似P-R曲线,根据学习器的预测结果对样例排序,并逐个作为正例进行预测,以“假正例率”为横轴,“真正例率”为纵轴,可得到ROC曲线,全称“受试者工作特征”.

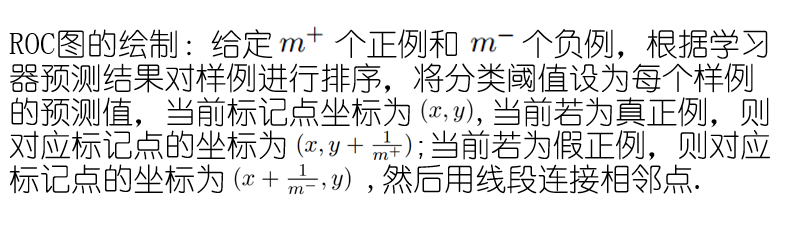

其中ROC图的绘制步骤如下:

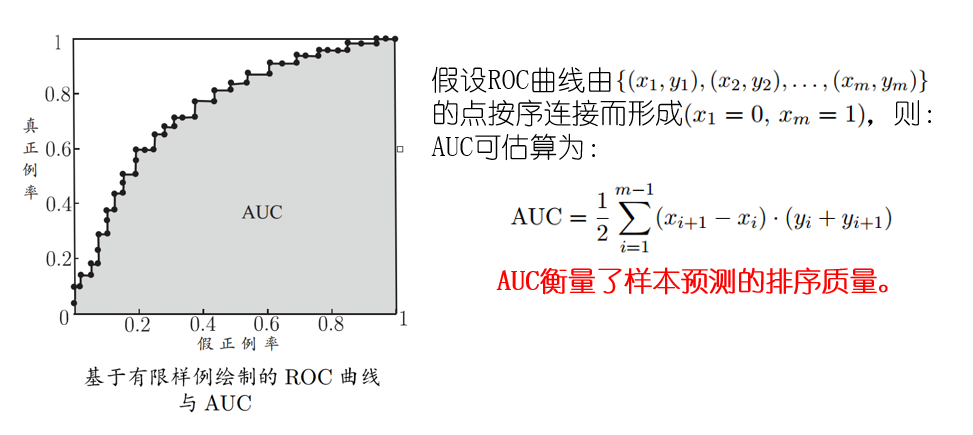

AUC:即ROC下的面积:

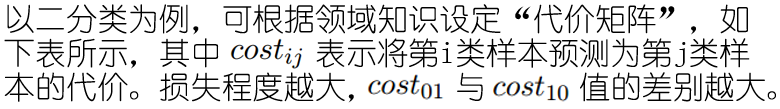

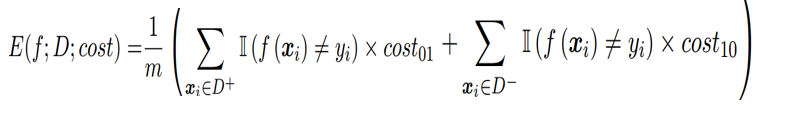

2.3.4代价敏感错误率与代价曲线:

背景:现实任务中不同类型的错误所造成的后果很可能不同,为了权衡不同类型错误所造成的不同损失,可为错误赋予“非均等代价”。

在非均等代价下,不再最小化错误次数,而是最小化“总体代价”,则“代价敏感”错误率相应的为:

在非均等代价下,ROC曲线不能直接反映出学习器的期望总体代价,而“代价曲线”可以。代价曲线的解释如下:

绘制方法:

2.4比较检验

由于测试性能并不等于泛化性能,测试性能随测试集的变化而变化,而且很多机器学习算法具有一定的随机性。直接选取的评估方法往往与现实不太贴切。假设检验为学习器性能比较提供了重要依据。

2.4.1 二项检验

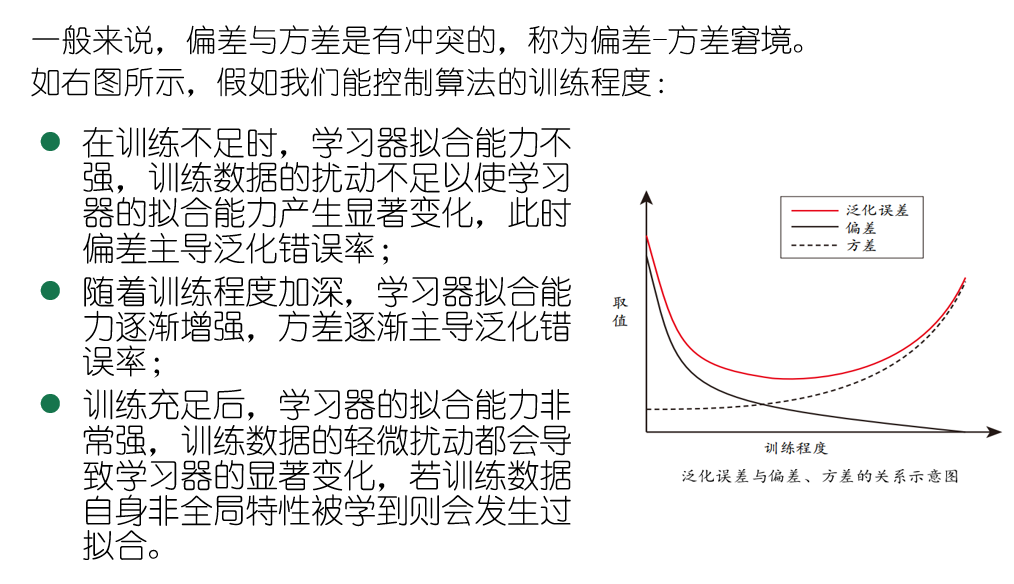

同样,还有 t 检验以及交叉验证 t 检验、McNemar检验、Friedman检验、Nemynyi后续检验、最后再将一个偏差与方差,这个没什么好讲的老套公式,这里给出一个前两个与泛化性能的关系图:

3 阅读材料