前言

新型冠状病毒泛滥,至今已有1w+同胞感染,在此深刻祝福他们早日康复。

学校依托易班APP展开了线上签到的web应用,思路很简单,没有什么复杂的,但是要命的不是代码,而是并发,学校共有4w人,可能是大家在家比较闲,流量高峰时期学校分配的土豆服务器会崩掉,在此我参考前辈们的做法,决定用nginx+tomcat集群的方式来实现流量的负载均衡,用redis来解决session共享问题

首先,我们知道nginx是:

Nginx (engine x) 是一个高性能的HTTP和反向代理web服务器,同时也提供了IMAP/POP3/SMTP服务。Nginx是由伊戈尔·赛索耶夫为俄罗斯访问量第二的Rambler.ru站点(俄文:Рамблер)开发的,第一个公开版本0.1.0发布于2004年10月4日。

其将源代码以类BSD许可证的形式发布,因它的稳定性、丰富的功能集、示例配置文件和低系统资源的消耗而闻名。2011年6月1日,nginx 1.0.4发布。

Nginx是一款轻量级的Web 服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器,在BSD-like 协议下发行。其特点是占有内存少,并发能力强,事实上nginx的并发能力在同类型的网页服务器中表现较好,中国大陆使用nginx网站用户有:百度、京东、新浪、网易、腾讯、淘宝等。

官方测得能支持五万并发,这个就算在实际并发中有缩水的情况,应对学校的并发数是远远够了,你总不可能让四万人在同一时间同时访问吧,实现的大致思路如下:

1. nginx配置

#user nobody;

worker_processes 1;

#error_log logs/error.log;

#error_log logs/error.log notice;

#error_log logs/error.log info;

#pid logs/nginx.pid;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

#log_format main '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

#access_log logs/access.log main;

sendfile on;

#tcp_nopush on;

#keepalive_timeout 0;

keepalive_timeout 65;

#gzip on;

# include hosts/tomcat_test.conf;

upstream localhost{

server 127.0.0.1:8080 weight=1;

server 127.0.0.1:8081 weight=1;

}

server {

listen 80;

server_name localhost;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

# root html;

# index index.html index.htm;

proxy_pass http://localhost;

}

#error_page 404 /404.html;

# redirect server error pages to the static page /50x.html

#

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

# proxy the PHP scripts to Apache listening on 127.0.0.1:80

#

#location ~ \.php$ {

# proxy_pass http://127.0.0.1;

#}

# pass the PHP scripts to FastCGI server listening on 127.0.0.1:9000

#

#location ~ \.php$ {

# root html;

# fastcgi_pass 127.0.0.1:9000;

# fastcgi_index index.php;

# fastcgi_param SCRIPT_FILENAME /scripts$fastcgi_script_name;

# include fastcgi_params;

#}

# deny access to .htaccess files, if Apache's document root

# concurs with nginx's one

#

#location ~ /\.ht {

# deny all;

#}

}

# another virtual host using mix of IP-, name-, and port-based configuration

#

#server {

# listen 8000;

# listen somename:8080;

# server_name somename alias another.alias;

# location / {

# root html;

# index index.html index.htm;

# }

#}

# HTTPS server

#

#server {

# listen 443 ssl;

# server_name localhost;

# ssl_certificate cert.pem;

# ssl_certificate_key cert.key;

# ssl_session_cache shared:SSL:1m;

# ssl_session_timeout 5m;

# ssl_ciphers HIGH:!aNULL:!MD5;

# ssl_prefer_server_ciphers on;

# location / {

# root html;

# index index.html index.htm;

# }

#}

}

最核心的两个地方,负责转发

不得不说的是nginx实现负载均衡的几个方式:

-

轮询

默认配置

upstream xsdemo{

server 192.168.110.128:8081;

server 192.168.110.128:8082;

} -

weight(权重)

正向代理 设置权重

upstream xsdemo{

server 192.168.110.128:8081 weight=10;

server 192.168.110.128:8082 weight=10;

} -

ip_hash

每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器,可以解决session(并不是共享session解决)的问题。 网传这种方式其实不算是负载均衡,但是我觉得算吧,假如A和B访问,A去tomcat1,B去tomcat2,虽然session可以不通过共享的方式来减轻某个tomcat的压力,但是我觉得也算是负载均衡的一种实现思路吧!

upstream xsdemo{

ip_hash;

server 192.168.110.128:8081 weight=10;

server 192.168.110.128:8082 weight=10;

} -

fair(未经测试) 按后端服务器的响应时间来分配请求,响应时间短的优先分配

-

url_hash(未经测试)按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效

2. tomcat集群搭建方式

tomcat8下载(官网)http://tomcat.apache.org/download-80

需要我们做的

-

下载jar包:分别是 commons-pool2-2.2.jar、jedis-2.8.2.jar、tomcat-redis-session-manager.jar,注意各个版本之间的依赖,这个依赖经实际测试没有问题,我放到了我的百度网盘里,请自行下载:链接:https://pan.baidu.com/s/14UU4rnMGxaggqKuBs7vn6Q

提取码:xlt5

这个实现的还得得益于一个外国大神,我参考了他的GitHub才搞成了的!

源码地址:https://github.com/jcoleman/tomcat-redis-session-manager -

下载我的jar包后,将这三个jar包放到tomcat目录下的lib文件夹里

-

更改xml配置文件:

(1)更改conf目录下的context.xml,在上方加入如下所示

<Valve className="com.seejoke.tomcat.redissessions.RedisSessionHandlerValve"/>

<Manager className="com.seejoke.tomcat.redissessions.RedisSessionManager"

host="localhost"

port="6379"

database="0"

password="123456"

maxInactiveInterval="1800" />

host:主机。

port:端口。

database:这里指的是redis的数据库名。

password:redis的密码,这个一定要设置,我就吃了很多亏,因为没有设置这个!

maxInactiveInterval:session存活时间,以秒为单位。

(2)更改tomcat端口,这里要改三个端口,不会出现闪退的情况:

<!--web服务端口-->

<Connector port="8080" protocol="HTTP/1.1"

connectionTimeout="20000"

redirectPort="8443" />

<!--推出端口-->

<Server port="8005" shutdown="SHUTDOWN">

<Connector port="8009" protocol="AJP/1.3" redirectPort="8443" />

更改三个端口直至互不占用

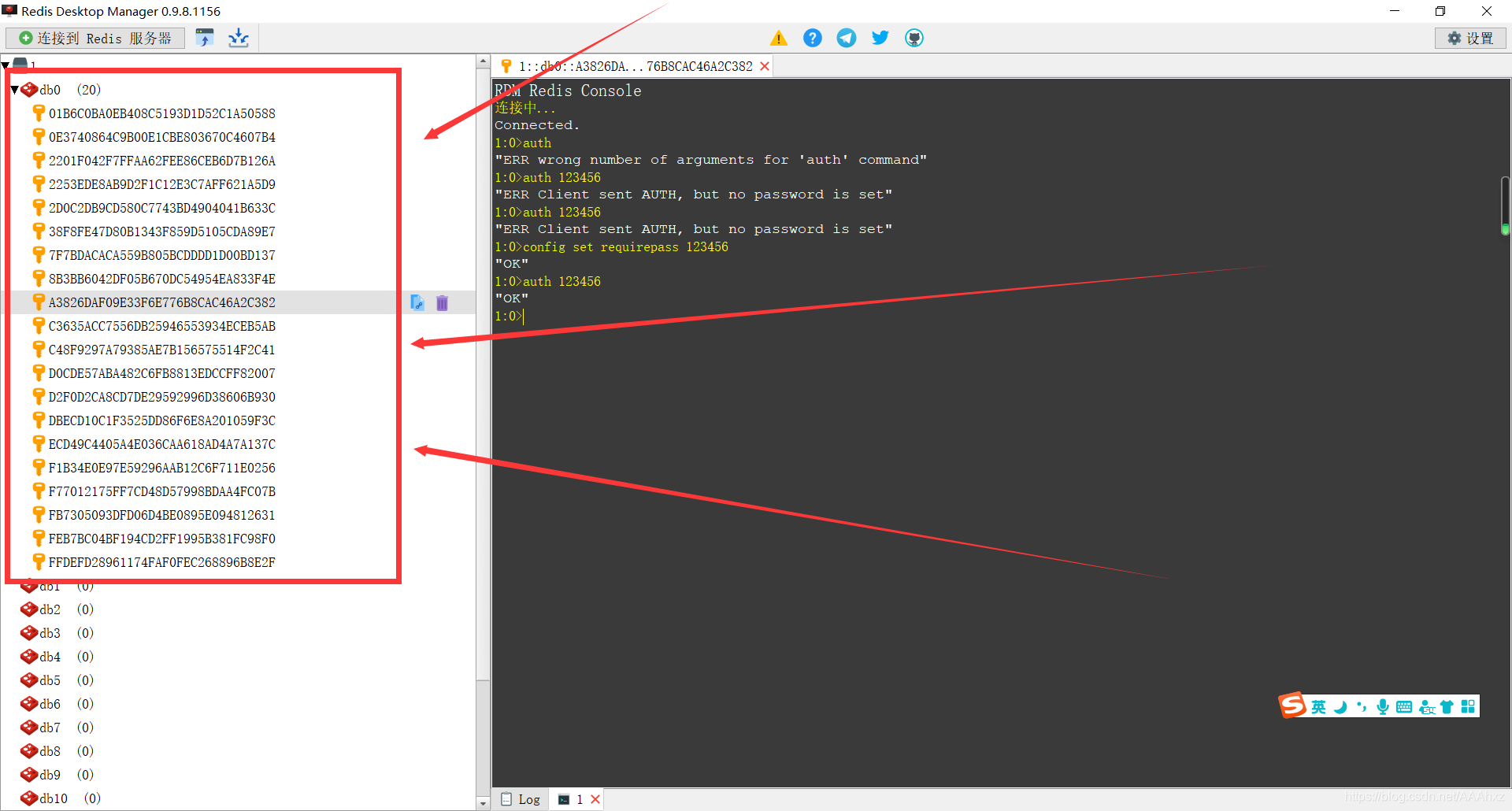

3. redis

redis是不需要做什么具体配置的,只需要将密码设置一下就好了

在redis命令行,或者在RDM里面设置一下:

config set requirepass 123456

所有的跑起来,先运行tomcat,在运行nginx,比较鸡肋的就是nginx的Windows版本得在任务管理器里面杀死然后在启动才算重启。

效果图:

大功告成!

4. 后续,SQL语句的优化

后来项目的推进,又搞了一个SQL语句的优化我想把它一并写到这里

原语句挤不太清楚,大概就是这样的:

SELECT DISTINCT message.id, message.content, message.title, message.date, IF(EXISTS(SELECT * FROM tongzhi WHERE yb_userid = '16751040' AND tongzhi.tongzhi = message.id), 1, 0) AS is_read FROM message

冗长而且这个并发度一点都不高

第一没有走索引

第二用exist会进行全表搜索

优化思路:

- 创建索引,在where条件语句后面

- 用left join代替eixt

- 去掉if判断

- 数据库垂直分表,因为有一部分例如学号和个人ID是永不会变的,而其他的例如这个状态值是会改变的而且是频繁改变的

- 用MyISAM存储引擎代替InnoDB,有必要提几句这两个存储引擎有哪些异同:

MyISAM 它不支持事务,也不支持外键,尤其是访问速度快,对事务完整性没有要求或者以SELECT、INSERT为主的应用基本都可以使用这个引擎来创建表。

InnoDB InnoDB存储引擎提供了具有提交、回滚和崩溃恢复能力的事务安全。但是对比MyISAM的存储引擎,InnoDB写的处理效率差一些并且会占用更多的磁盘空间以保留数据和索引。

【更多区别:】

MyISAM是非事务安全型的,而InnoDB是事务安全型的。

MyISAM锁的粒度是表级,而InnoDB支持行级锁定。

MyISAM支持全文类型索引,而InnoDB不支持全文索引。

MyISAM相对简单,所以在效率上要优于InnoDB,小型应用可以考虑使用MyISAM。

MyISAM表是保存成文件的形式,在跨平台的数据转移中使用MyISAM存储会省去不少的麻烦。

InnoDB表比MyISAM表更安全,可以在保证数据不会丢失的情况下,切换非事务表到事务表(alter table tablename type=innodb)。

回到我们的场景,我们这个应用对于数据的准确性要求并不是很高,退而求其次的我们会用MyISAM的更快一些,在保证数据要求的前提下。这个就像是HashMap的扩容因子为0.75以空间换取时间的做法一样,鱼和熊掌不可得兼嘛 - 其他的像什么数据库表数据多了就自动分表啊,MySQL分库,主从数据库的搭建都是可以应对高并发的很好的思路。