学习吴恩达的深度学习视频,记录的笔记,方便回顾。

每天学习一点,加油!

二分类:

通过训练来预测该图中是否有猫。

一般一张彩色图像分为RGB三通道,假设图像图幅大小64 x 64,每个像素用像素值表示。用向量x表示该图片的特征向量,则x的维度位64 x 64 x 3。用y作为标签,1表示有猫, 0者无猫。

假设有m个训练样本, 则可以表示为{(x1, y1), (x2, y2), …,(xm, ym)};

logistic回归:

对于二分类问题,希望通过给定的x向量,得到p(y=1|x),对于上述例子而言,即给定这张图,希望得到该图中有猫的概率。

logistic回归参数:

1.w,权重,维度与向量x相等

2.b,偏置。

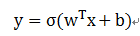

模型:

,

,

其中w^T 为w的转置。因为希望得到的是该图中有猫的概率,而概率的值应该在0~1之间,所以对(w^T x+b)求出的值映射到0~1之间。这里σ函数: sigmod函数。

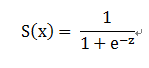

sigmod函数:

其函数图形为:

该函数中,当自变量z趋向于正无穷时,输出->1。

当自变量z趋向于负无穷时,输出->0。

有的参考资料将b写入w向量中,即w0 = b。

logistic回归损失函数:

对于单一样本(x, y)

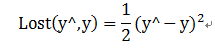

一般情况下,损失函数定义为:

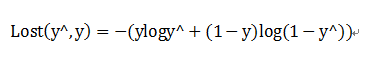

但是这个函数往往是非凸函数。因而logistic采用的损失函数为:

其中y^为预测的概率,范围0~1。

为什么上述函数可以作为损失函数呢?

分析:

当y=1时,Lost(y^,y)=-(logy^),损失函数越小越好,因而y^越大越好,趋向于1.

当y=0时,Lost(y^,y)=-(log(1-y^)),同样,要想损失函数小,则y^越小越好,趋向于0。

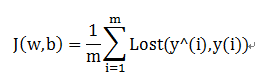

成本函数:

当样本数大于1时,要计算所有样本的损失和,即成本函数。

定义为:

明天继续后续视频以及笔记,加油!