本节仅是对神经网络的背景知识介绍和神经网络的表述方式进说明。因为生物学知识不难,理解也还行。

1、神经元(neuron)

下图是以左侧表示神经网络的一个神经元(这个神经元对应的就是简单的逻辑回归)。

2、神经网络(Neural Network)表示

下图表示一个神经网络

从左至右三层(layer)分别叫:输入层(input layer)、隐藏层(hidden layer)、输出层(output layer)

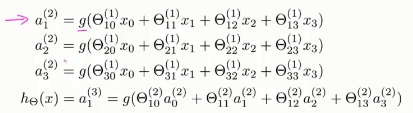

表示第

层的第

个元素,

表示第j、j+1层之间的参数

因为每一层有偏置项,

、

,所以

列数要+1

3、向量化

还是上面的例子,用向量表示输入,为了和隐藏层一致,用

表示

,

令

表示上述等式的加法项,则:

(则

)

当然,神经网络还有不同的框架,例如下图,含有两个隐藏层。其实最后一个隐藏层例如下面layer3和输出层就是一个逻辑回归算法。其他各层也是,所以他是一个非常复杂的多层逻辑回归。中间的隐藏层作为后面的参数输入,已经非常难以解释。

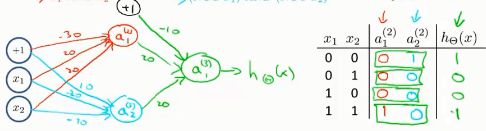

4、例子

例子是使用简单神经网络模拟逻辑运算(AND、OR、NOT、XOR、XNOR)

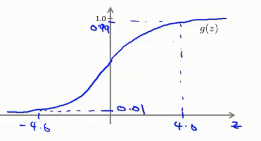

回忆simoid 方程的特性:

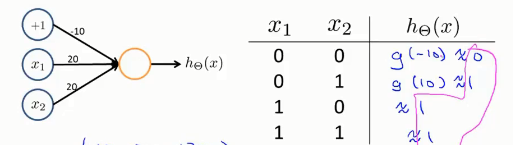

使用单个神经元可以模拟(AND、OR、NOT)

例如:OR 的表示如下,其实就是使用

控制simoid函数的输入

)

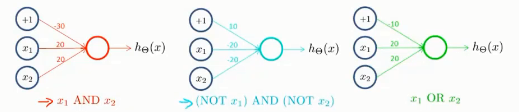

与非或如下:

然后,直接使用OR神经元将前两个组合,形成3层神经网络,得到复杂逻辑XNOR

5、多元分类

多元分类,并不是单个输出,而是同时多个输出,由每个输出{0,1}(仅有一个为1,其余为0),判别属于那一类: