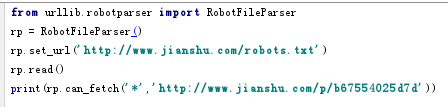

robotparser模块提供了一个RobotFileParser类,可以方便的判断哪些页面可以抓取,哪些页面不可以抓取。

首先需创建类:urllib.robotparser.RobotFileParser(url=''),申明是也可以不传入url,用set_url()设置。

该类常用方法:

- set_url():设置robots.txt文件的链接;

- read():读取robots.txt文件并进行分析,该方法不会返回结果,但对文件进行了读取操作,这一步必须调用,如果不调用,则接下来的判断均为False;

- parser():解析robots.txt文件;

- can_fetch():第一个 参数为user_agent,第二个参数为要抓取的url,判断该搜索引擎是否可抓取该url;

- mtime():返回上次抓取和分析robots.txt协议的时间;

- modified():将当前时间设置为上次抓取和分析的时间。

代码: