参考网址:https://www.cnblogs.com/SivilTaram/p/graph_neural_network_1.html

论文名称《A Comprehensive Survey on Graph Neural Networks》

图神经网络(Graph Neural Network, GNN)

结构框架推导

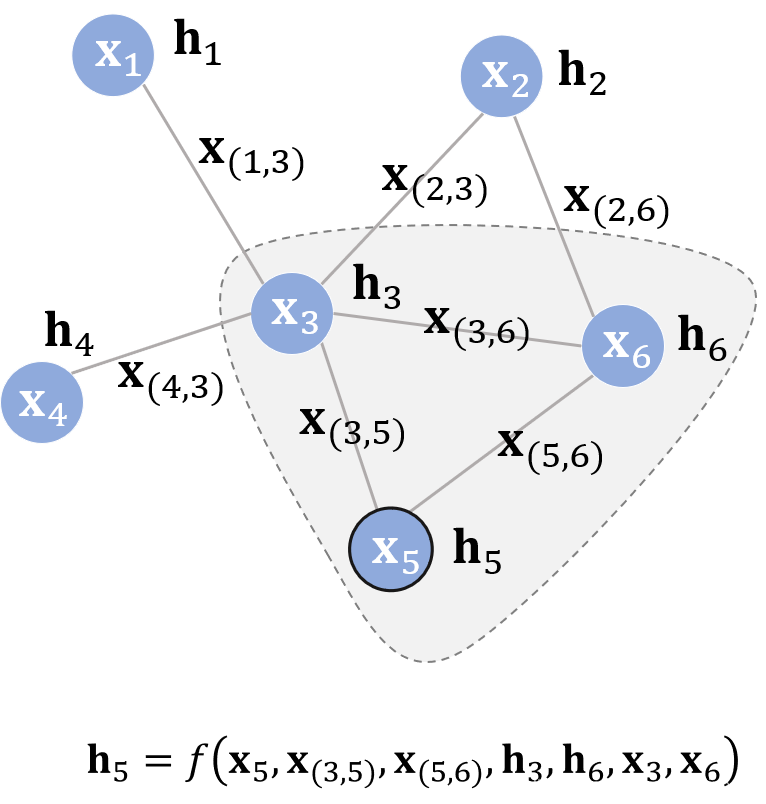

对于不规则图(规则图指的是跟图片一样的)来进行卷积(卷积之后要求的一个隐藏状态),我们可以根据它的周围结点和边的信息来算,假设这个结点的隐藏状态跟 ①自己特征

②周围结点的特征

③周围结点上一层的隐藏状态

④连接着的边的特征

,再假设可以根据某个函数f求得该结点现在的隐藏状态,那么有

对于不规则图(规则图指的是跟图片一样的)来进行卷积(卷积之后要求的一个隐藏状态),我们可以根据它的周围结点和边的信息来算,假设这个结点的隐藏状态跟 ①自己特征

②周围结点的特征

③周围结点上一层的隐藏状态

④连接着的边的特征

,再假设可以根据某个函数f求得该结点现在的隐藏状态,那么有

![ht+1v=f(xv,xco[v],htne[v],xne[v]),](https://img-blog.csdnimg.cn/20191027000812836.png)

计算出隐藏状态之后怎么利用这些隐藏状态呢?

这个时候我们可以,设置另外一个函数 g 来描述如何适应下游任务。有:

,其中g 又被称为局部输出函数。

那么函数f怎么求呢?可以利用我们的神经网络来自动寻找这个函数,如下。另外,与 f 类似,g 也可以由一个神经网络来表达。

仔细观察两个时刻之间的连线,它与图的连线密切相关。比如说在 T1 时刻,结点 1 的状态接受来自结点 3 的上一时刻的隐藏状态,因为结点 1 与结点 3相邻。直到 Tn 时刻,各个结点隐藏状态收敛,每个结点后面接一个 g 即可得到该结点的输出 o。

对于不同的图来说,收敛的时刻可能不同,因为收敛是通过两个时刻p-范数的差值是否小于某个阈值 ϵ来判定的,比如:

即达到某个阈值,我们就判定我们收敛结束。

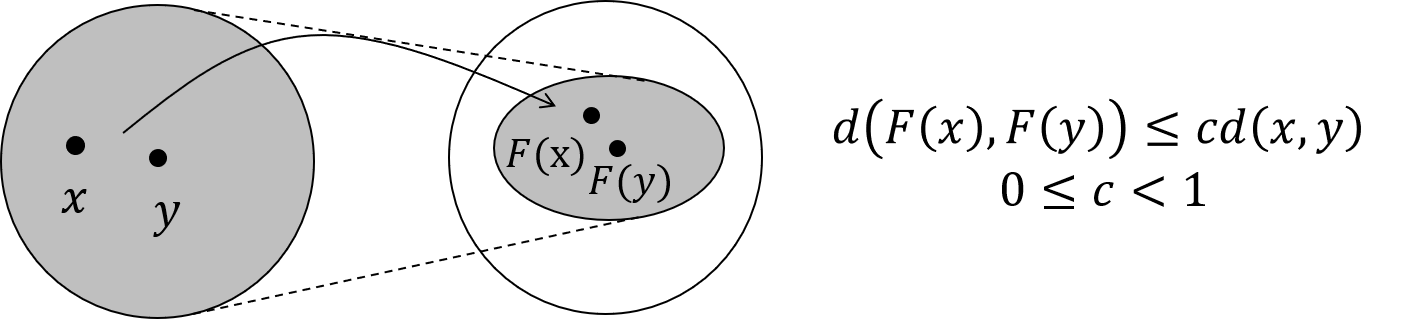

巴拿赫不动点理论

具体不懂,可以参考该网址:https://www.cnblogs.com/SivilTaram/p/graph_neural_network_1.html

引入雅可比矩阵(Jacobian Matrix)的惩罚项就可以完成,具体公式见参考链接。