文章目录

论文信息

Cross-Node Federated Graph Neural Network for Spatio-Temporal Data Modeling

原文链接:Cross-Node Federated Graph Neural Network for Spatio-Temporal Data Modeling:https://dl.acm.org/doi/10.1145/3447548.3467371

摘要

Vast amount of data generated from networks of sensors, wearables, and the Internet of Things (IoT) devices underscores the need for advanced modeling techniques that leverage the spatio-temporal structure of decentralized data due to the need for edge computation and licensing (data access) issues. While federated learning (FL) has emerged as a framework for model training without requiring direct data sharing and exchange, effectively modeling the complex spatio-temporal dependencies to improve forecasting capabilities still remains an open problem. On the other hand, state-of-the-art spatio-temporal forecasting models assume unfettered access to the data, neglecting constraints on data sharing. To bridge this gap, we propose a federated spatio-temporal model – Cross-Node Federated Graph Neural Network (CNFGNN) – which explicitly encodes the underlying graph structure using graph neural network (GNN)-based architecture under the constraint of cross-node federated learning, which requires that data in a network of nodes is generated locally on each node and remains decentralized. CNFGNN operates by disentangling the temporal dynamics modeling on devices and spatial dynamics on the server, utilizing alternating optimization to reduce the communication cost, facilitating computations on the edge devices. Experiments on the traffic flow forecasting task show that CNFGNN achieves the best forecasting performance in both transductive and inductive learning settings with no extra computation cost on edge devices, while incurring modest communication cost.

传感器、可穿戴设备和物联网设备网络生成的大量数据强调了对利用分散数据的时空结构的高级建模技术的需求,因为需要边缘计算和许可问题。虽然联邦学习已经成为模型训练的框架,不需要直接的数据共享和交换,但有效地对复杂的时空依赖关系进行建模以提高预测能力仍然是一个悬而未决的问题。另一方面,最先进的时空预测模型假设不受限制地访问数据,忽略了数据共享的限制。为了弥合这一差距,我们提出了一个联邦时空模型——跨节点联邦图神经网络(CNFGNN)——它在跨节点联邦学习的约束下,使用基于图神经网络(GNN)的架构对底层图结构进行显式编码,这要求节点网络中的数据在每个节点上本地生成并保持去中心化。CN-FGNN通过解开设备上的时间动力学建模和服务器上的空间动力学来运行,利用交替优化来降低通信成本,促进边缘设备上的计算。交通流预测任务的实验表明,CNFGNN在转导和归纳学习设置中都实现了最佳的预测性能,在边缘设备上没有额外的计算成本,同时产生的通信成本适中。

主要贡献

- 我们提出了跨节点联邦图神经网络(CN-FGNN),这是一种基于GNN的联邦学习架构,可以捕获多个节点之间复杂的时空关系,同时确保本地生成的数据保持分散,没有额外的计算成本在边缘设备上。

- 我们的建模和训练程序使基于GNN的架构能够在联邦学习环境中使用。我们通过解开边缘设备上的局部时间动力学建模和 cen-tral 服务器上的空间动力学建模来实现这一目标,并利用基于优化的交替过程来更新空间和时间模块使用拆分学习和联邦平均来实现有效的基于 GNN 的联邦学习。

- 我们证明了CNFGNN在具有适度通信成本的边缘设备上实现了最佳的预测性能(在转导和归纳设置中),与交通流预测任务中的相关技术相比,没有额外的计算成本。

CROSS-NODE FEDERATED GRAPHNEURAL NETWORK

问题定义

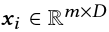

给定一个图 G = (V, E) 的数据集,一个特征张量 X 和标签张量 Y,任务在数据集上定义,X 作为输入,Y 作为预测目标。我们考虑在跨节点联邦学习约束下学习模型:节点特征  ,…,节点标签

,…,节点标签  ,…,模型输出

,…,模型输出  仅对节点 i 可见。

仅对节点 i 可见。

需要跨节点联合学习约束的一个典型任务是预测传感器网络生成的时空数据。在这种情况下,V 是传感器的集合,E 描述传感器之间的关系。特征张量  表示过去 m 个时间步长中第 i 个传感器在 D-dim 空间中的记录,标签

表示过去 m 个时间步长中第 i 个传感器在 D-dim 空间中的记录,标签 表示第 i 个传感器在未来 n 个时间步长的记录。由于不同用户/组织拥有的不同传感器上收集的记录可能由于数据访问时需要边缘计算或许可问题而不允许共享,因此有必要设计一种模拟时空关系的算法,而无需直接交换节点级数据。

表示第 i 个传感器在未来 n 个时间步长的记录。由于不同用户/组织拥有的不同传感器上收集的记录可能由于数据访问时需要边缘计算或许可问题而不允许共享,因此有必要设计一种模拟时空关系的算法,而无需直接交换节点级数据。

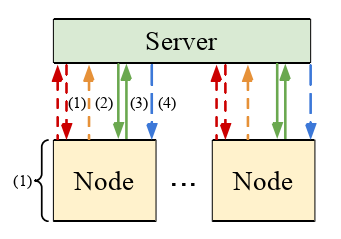

Cross-Node Federated Graph Neu-ral Network (CNFGNN) model

首先解开节点级时间动态和服务器级空间动态的建模,如下所示:

(i)在每个节点上,编码器-解码器模型从节点上的数据中提取时间特征并进行预测;

(ii)在中央服务器上,GraphNetwork (GN) [6]传播提取的节点时间特征并输出节点嵌入,这些嵌入包含节点之间的信息关系。

(i) 有权访问不可共享的节点数据,并在本地执行每个节点。(ii) 仅涉及上传和下载粉碎的特征和梯度,而不是节点上的原始数据。这种分解允许在跨节点联邦学习约束下交换和聚合节点信息。

Modeling of Node-Level Temporal Dynamics

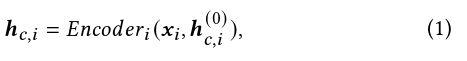

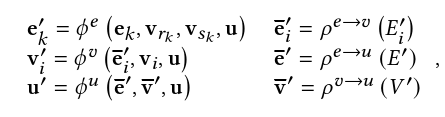

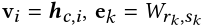

我们修改了基于门控循环单元(GRU)的编码器-解码器架构,以对每个节点上的节点级时间动态进行建模。给定在第i个节点上的输入序列 。编码器按顺序读取整个序列,并根据公式1输出隐藏状态

。编码器按顺序读取整个序列,并根据公式1输出隐藏状态 作为输入序列的摘要:

作为输入序列的摘要:

其中, 是一个零值初始隐藏状态向量。

是一个零值初始隐藏状态向量。

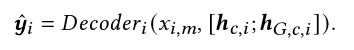

为了将空间动力学纳入每个节点的预测模型中,我们将 与嵌入

与嵌入 的节点连接起来,其中包含空间信息,作为解码器的初始状态向量。解码器从输入序列 xi,以自回归方式生成预测

的节点连接起来,其中包含空间信息,作为解码器的初始状态向量。解码器从输入序列 xi,以自回归方式生成预测 。

。

我们选择预测值和真实值之间的均方误差(MSE)作为损失函数,该函数在本地评估每个节点。

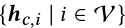

Modeling of Spatial Dynamics

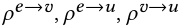

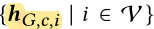

为了捕捉复杂的空间动态,我们采用GNN来生成包含所有节点关系信息的节点嵌入。中央服务器从所有节点 收集隐藏状态作为GNN的输入。GNN 的每一层更新输入特征,如下所示:

收集隐藏状态作为GNN的输入。GNN 的每一层更新输入特征,如下所示:

其中 ek、vi,U 分别是边特征、节点特征和全局特征。 是神经网络,

是神经网络, 聚合函数,如求和。

聚合函数,如求和。

我们设置  (W 是邻接矩阵),并将空向量作为第一个 GNN 层的输入。服务器端 GNN 输出所有节点的嵌入

(W 是邻接矩阵),并将空向量作为第一个 GNN 层的输入。服务器端 GNN 输出所有节点的嵌入  ,并相应地发送每个节点的嵌入。

,并相应地发送每个节点的嵌入。

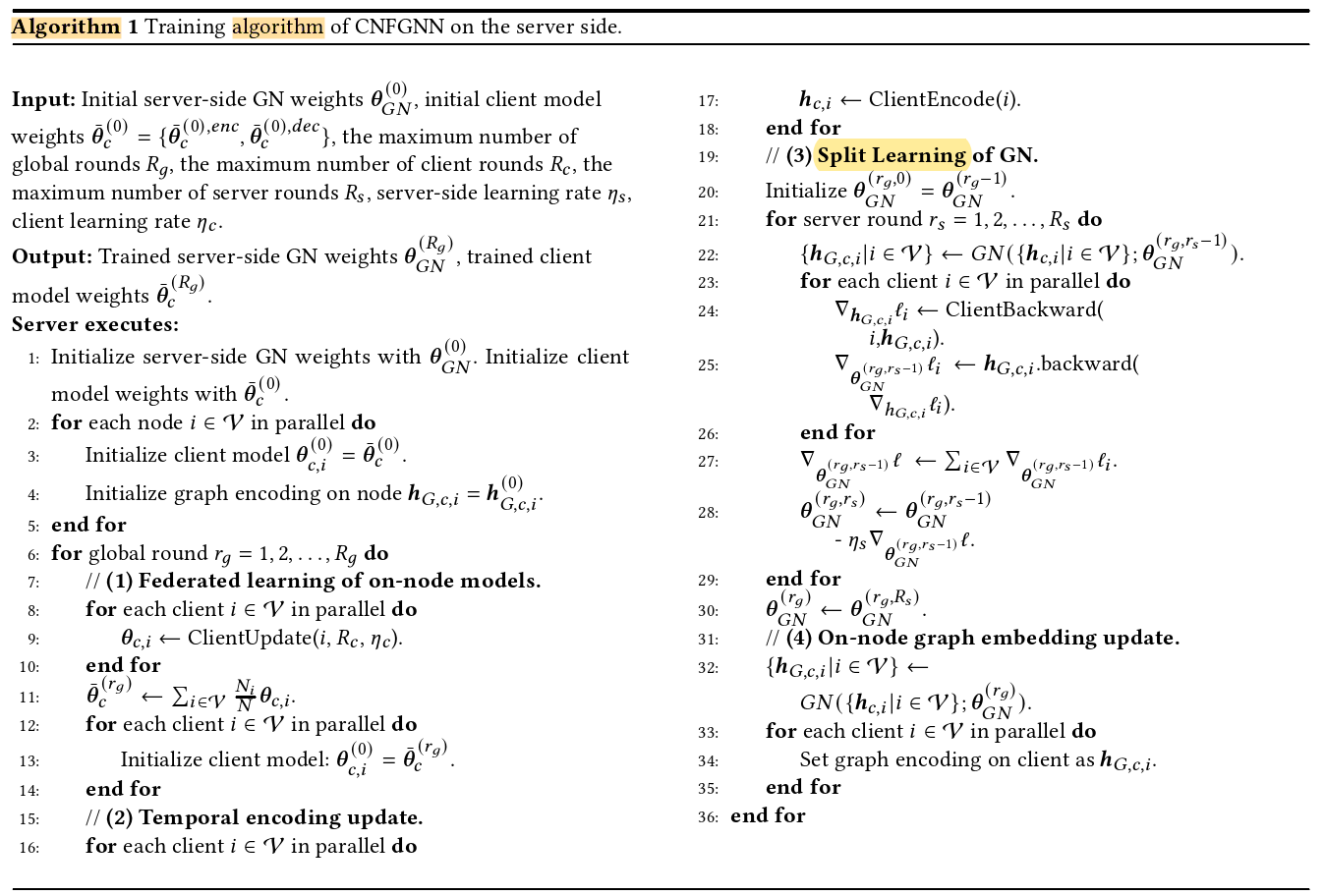

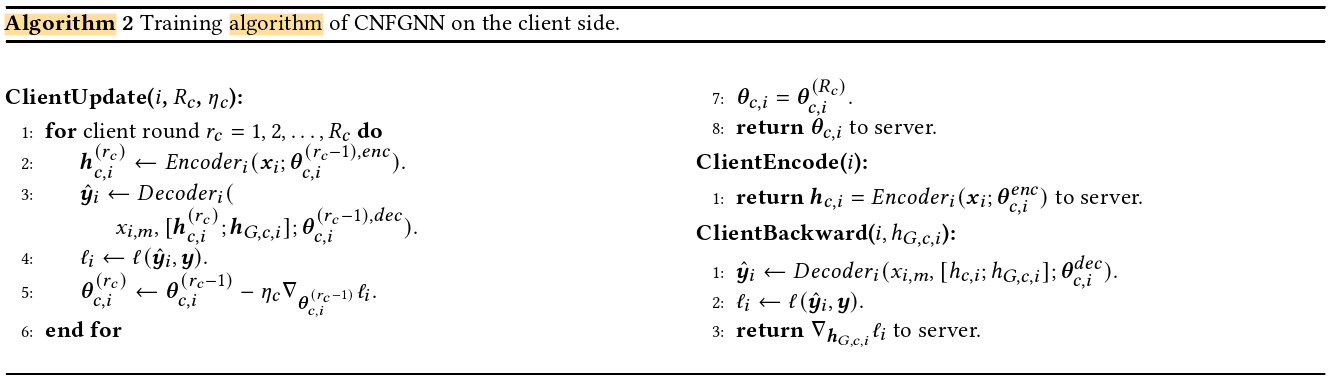

Alternating Training of Node-Level and Spatial Models

跨节点联邦学习要求和服务器端GNN模型带来的一个挑战是训练阶段的高通信成本。由于我们将模型的不同部分分布在不同的设备上,因此拆分学习是训练的潜在解决方案,其中隐藏向量和梯度在设备之间通信。然而,当我们简单地通过拆分学习端到端地训练模型时,中央服务器需要从所有节点接收隐藏状态,并将节点嵌入发送到前向传播中的所有节点,然后它必须从所有节点接收节点嵌入的梯度,并将隐藏状态的梯度发回向后传播中的所有节点。假设所有隐藏状态和节点嵌入具有相同的大小 S,则 GNN模型每轮训练中传输的数据总量为 4|V|S。

为了降低训练阶段的高通信成本,我们改为在节点上交替训练模型,在服务器上交替训练 GNN模型。更具体地说,在每一轮训练中,(1)更新节点嵌入 并优化R轮的编码器-解码器模型,然后(2)我们优化GNN模型,同时将所有模型固定在节点上。

并优化R轮的编码器-解码器模型,然后(2)我们优化GNN模型,同时将所有模型固定在节点上。

由于节点上的模型是固定的, 在 GNN模型的训练过程中保持不变,服务器只需要在 GNN训练开始之前从节点获取

在 GNN模型的训练过程中保持不变,服务器只需要在 GNN训练开始之前从节点获取  ,并且只需要传达节点嵌入和梯度。因此,GNN模型R轮训练每轮平均传输的数据量减少到

,并且只需要传达节点嵌入和梯度。因此,GNN模型R轮训练每轮平均传输的数据量减少到 。我们在算法 1 和算法 2 中提供了训练过程的更多详细信息。

。我们在算法 1 和算法 2 中提供了训练过程的更多详细信息。

为了更有效地从每个节点中提取时态特征,使用 FedAvg 算法在节点上训练编码器-解码器模型。这使得所有节点能够共享相同的特征提取器,从而共享一个联合的时序特征隐藏空间,从而避免了模型在节点上的潜在过度拟合,并表现出更快的收敛性和更好的预测性能。