前言

情感分析在文本领域可以说是最好入门但发展至今仍有巨大发掘空间的领域了,分类问题对于文本图像可以说是一通百通的入门练级实验,各种CNN\LSTM\Attention混合的模型既能训练基础也能较高效地运用到实际项目中,从最早的句子、篇章情感分类到aspect-based一些子任务以及CMU一直在做的多模态,可以说都是兼具研究价值和实际意义的。近两年新加坡科技与设计大学学者Soujanya Poria对于对话场景下的情感分析工作(Emotion Recognition in Conversation)也逐渐受人关注。以下的内容是基于Soujanya Poria今年写的ERC综述来总结的。

ERC任务定义

虽然也是最基本的文本分类,但是ERC的关键在于如何对于历史对话建模来分析当前说话人这句话的情感倾向。比如下图对u6情感分类,就要加入u1到u5的信息来建模,当然要使用的utterence个数是自己定的。

这个方向是和学长在调研多模态情感识别发现的,ERC这个任务本身是可以用多模态来做的,但是Soujanya Poria的几篇论文看下来并没有过多关注多模态表示学习,而是将研究重点放在了历史对话建模上。本来我做过语音的单模态项目,实验时用了南加州的IEMOCAP数据集,当时我们在上面的最高Recall大概65左右,用的类似Multiway-attention这种不算复杂模型结构,CMU的多模态也用了IEMOCAP数据集,语音文本视频三模态到现在最高也能达到了80多,这个数据集特殊在于它是以两人对话的形式,所以可以取出单句utterence来做分类,也可以像ERC任务里一样用历史对话来分析当前utterence,但是Soujanya Poria的几篇论文里在IEMOCAP数据集上效果似乎并没有比CMU组的要好,话说这里不得不吐槽一下这个数据集情感明明总共有9类情感,处于数据量的问题有的论文只用了6类,有的就用了4类,这有时候难得比较…当时本来觉得是不是ERC这个方向有问题,只分析当前utterence就好了嘛,还要知道历史对话反而没有提升不是瞎耽误了,后来仔细看了看论文又自己思考了一些,ERC这个任务特殊性就在于它的历史对话,当前utterence的分析倒是弱化了(但当前的信息还是用上了),更像是一种根据历史对话来半预测当前的情感流向,有些简单的句子比如“yes”可能在文本或者语音下并不足以准确分析出感情,图像也可能是嘴上笑嘻嘻心里MMP的情况。

历史对话的信息在这时就能起到作用,引入历史对话相当于问答中引入了外部知识,另外其实这个任务也可以扩展出更多其它用途,比如分析各个说话人的用户画像,电商客服对话或者社区问答中的aspect-based问题、分析对面的情感倾向来生成回复、以及一些反讽、隐式情感的分析,这些都是只看单句无法分析的,其实像今年ACL南理工的那篇 Emotion-Cause Pair Extraction: A New Task to Emotion Analysis in Texts 在文档中分析情感的产生原因也可以在对话上做。不过其实说到底历史对话建模很早也开始做了,之前看的记忆网络就是差不多的例子,近些年的ERC论文更对话建模上的工作,其实既然数据集很多都是多模态的,不知道表示学习这方面有没有什么突破性的思路。

历史对话的信息在这时就能起到作用,引入历史对话相当于问答中引入了外部知识,另外其实这个任务也可以扩展出更多其它用途,比如分析各个说话人的用户画像,电商客服对话或者社区问答中的aspect-based问题、分析对面的情感倾向来生成回复、以及一些反讽、隐式情感的分析,这些都是只看单句无法分析的,其实像今年ACL南理工的那篇 Emotion-Cause Pair Extraction: A New Task to Emotion Analysis in Texts 在文档中分析情感的产生原因也可以在对话上做。不过其实说到底历史对话建模很早也开始做了,之前看的记忆网络就是差不多的例子,近些年的ERC论文更对话建模上的工作,其实既然数据集很多都是多模态的,不知道表示学习这方面有没有什么突破性的思路。

数据集简介

直接上图:

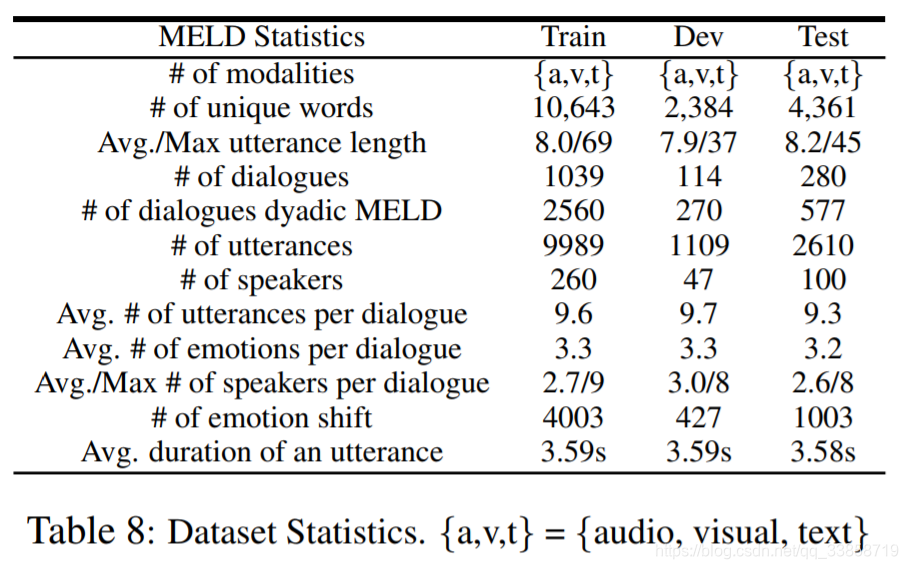

其中IEMOCAP用的最为广泛,因为发布的较早,很多做单句的分类也基本都会用,但是原始数据要给南加州那个作者填个申请表,下载链接可能要等几天,大概17个G左右的数据。EmoContext在SemEval2019评测上也用到了,它是固定历史utterence个数为三个。MELD是Soujanya Poria组2018年底新发布的数据集,里面的数据都是老友记原始片段,内容相对IEMOCAP更生活化。

不过对于多模态来说固定的演员人数可能是限制模型泛化能力的因素之一,像MELD只有老友记主角6人。IEMOCAP是5男5女是个演员,我之前在语音上面的做法是10-fold取9人做训练来测试剩下1人。

另外,严格来说情感分析的label可以是离散型的高兴生气(emotion)也可以是稍微抽象的positive、neutral、negative(sentiment)也可以是连续型的维度值(Valence-Arousal-Dominance),这里我就只看离散型了,更直观更常用。

研究进展

先看IEMOCAP数据集上的结果:

最后三个是Soujanya Poria组2019年前的三篇顶会论文中的模型,目前的SOTA是AAAI2019发表的DialogRNN,其实结果提高的并不是很多,上涨空间还是挺大的,隔壁CMU的四分类都80多了。这里就简要介绍一下这三种模型的思想。

CMN

Conversational Memory Network for Emotion Recognition in Dyadic Dialogue Videos -ACL 2018

这篇的创新点在于使用了对话中两人的历史对话信息,上图中两个说话人的三模态特征对称地输入记忆网络,这里三模态的提取T:CNN,V:3DCNN,A:IS13,各自通过一层全连接映射成100维在拼接成300维的输入,再用GRU层连接一个说话人的历史对话作为记忆网络的输入

。

这里的记忆网络用最终要预测的utterence做映射后的

和历史utterence的

分别做attention,两个说话人分别得到

和

两个加权和后的历史信息,两者和

相加后得到下一次记忆网络迭代的输入,最终的预测就是最后一层记忆网络的输出做softmax。

ICON

ICON: Interactive Conversational Memory Network for Multimodal Emotion Detection -EMNLP 2018

相比CMN模型这次ICON的改进显得顺理成章了,之前是分别对两个说话人各自建模历史对话,这样就没有用上两人的交互信息,ICON就是把两人的历史对话用同一层GRU连起来,另外就是每个记忆网络中都用GRU去建模下一次的

输入,相当于是一个stack GRU,其余就没什么太大的变化了。

DialogRNN

Dialoguernn: An attentive rnn for emotion detection in conversations -AAAI 2019

扫描二维码关注公众号,回复: 7579401 查看本文章

DialogRNN这个模型图画的不是很好理解,不过看(b)的话其实拆分开来看基本框架还是和之前差不多,只不过这里不再使用记忆网络,而是全用RNN网络去建模说话人各自、交互的信息。还有就是文中提到的对话过程中speaker和listener的不同之处,虽然实验证明作用不大不过这里还是说一下,之前所有用到的都是speaker信息,因为主要的信息来源就是speaker表现的三种模态,而listener有在speaker说话时的visual特征,就是listener的面部表情变化,可能可以为他的下句utterence情感做铺垫,虽然实验证明这个信息是多余的,但是私以为这里说不定有可挖掘之处。DialogRNN与之前最大的不同是RNN的构建多了历史信息和当前信息的加权和(attention)的,而不是之前的只有历史信息,所以这样传下去可以代替记忆网络的反复迭代的步骤,最终实验证明的确是更有效一些。另外实验中也对比了使用未来utterence的BiRNN结构效果会更好,但是从实际的信息流角度来说这个其实意义并不大。

以下是跑通的作者开源代码在IEMOCAP数据集上的结果:

CMN:

ICON:

DialogRNN(TEXT):

总结

- 任务虽然是比较新的概念,但是方法没有很新颖的地方,从历史对话建模的角度来看问答、对话有很多可以借鉴的地方,但是多模态的信息一直被忽视,以后会从多模态和对话问答两个角度去看论文。

- 论文中对比实验较多,有很多地方作者都有自己的思考和实验证明,不过目前来看的确这些网络设计性比较强,对于数据的分析往往比模型先一步会更好,比如作者分析了历史utterence影响的程度高低以及情感转移的几种情况,特别是后者,其实更难去识别+预测的去做一个情感迁移的任务。

- 除了上述三篇,最近还有很多其他论文可以参考,同组的DialogGCN,还有IJCAI一篇用量子理论的思想做的,还有一篇用transformer和外部知识库来做的,以后会继续跟进。

参考文献

[1]: Emotion Recognition in Conversation: Research Challenges, Datasets, and Recent Advances]

[2]: IEMOCAP: interactive emotional dyadic motion capture database

[3]: Meld: A multimodal multi-party dataset for emotion recognition in conversations