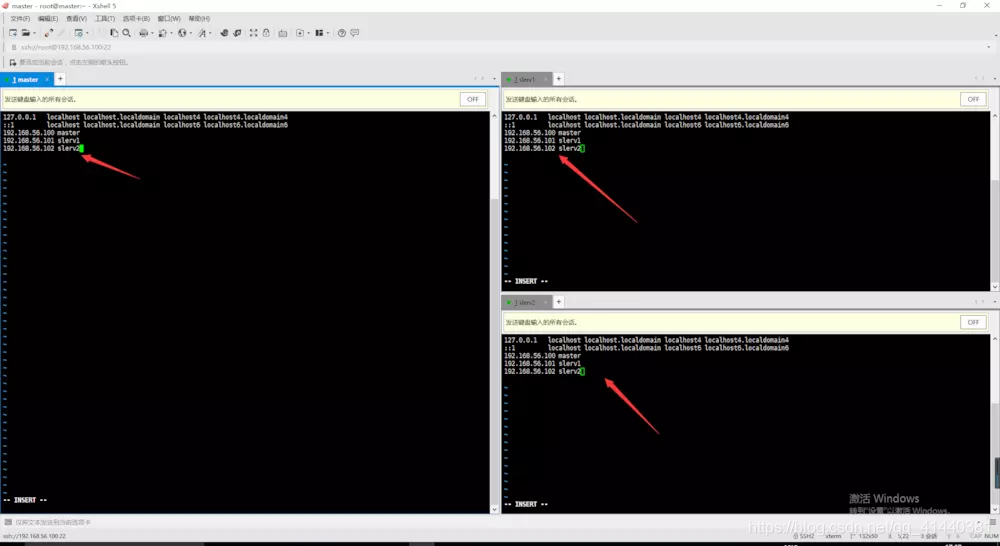

开机后将各个虚拟机的ip修改好之后,将三个节点的ip以及hostname都加上

可以使用xshell的工具,将命令一次性发送到各个窗口。三台虚拟机必须一致

准备工作完毕!开始集群配置

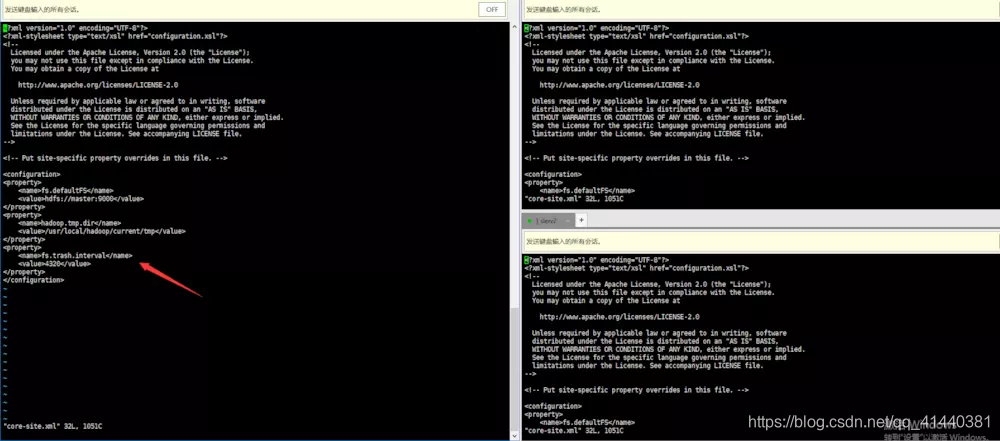

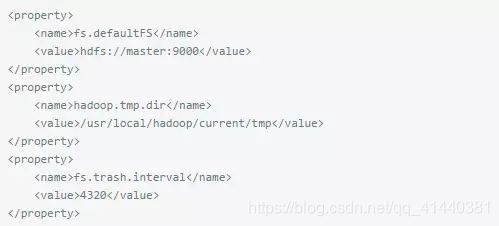

配置core-site.xml

在所有的节点上都应该修改/etc/hadoop/core-site.xml.

注意:需要修改tmp目录,不然默认是linux的tmp目录,这样会出现意想不到的错误,因为linux重启后,会删除/tmp目录下的内容。

这里是master上的配置信息,core-site.xml这个配置在其他几台slave 上必须保持跟master一致!

配置core-site.xml

在所有的节点上都应该修改/etc/hadoop/core-site.xml.注意:需要修改tmp目录,不然默认是linux的tmp目录。必须在各个机器上一定要保持此配置的一致性

配置内容

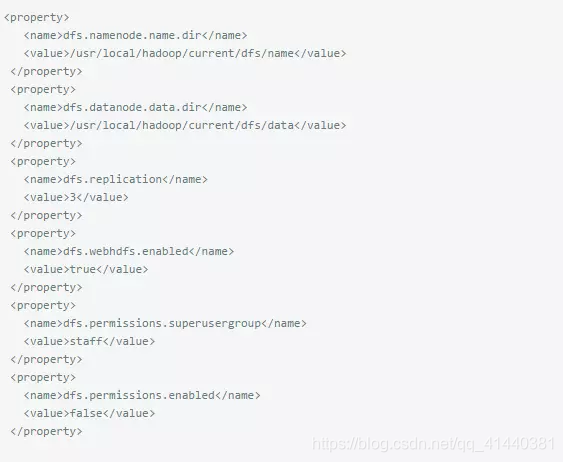

配置hdfs-site.xml

在master修改/etc/hadoop/hdfs-site.xml

配置内容

格式化HDFS: hdfs namenode -format

启动集群

在master上启动hadoop-daemon.sh start namenode

在slave上启动hadoop-daemon.sh start datanode

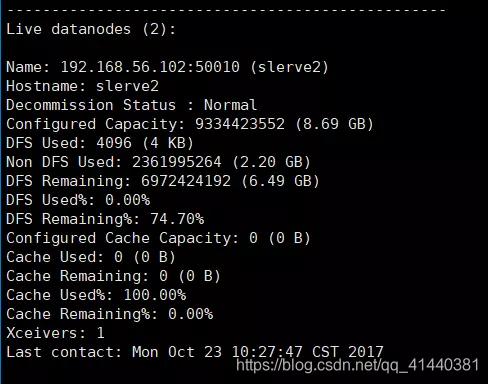

启动后用hdfs dfsadmin -report观察集群配置情况, 或者在各台机器输入jps 查看是否启动成功。

启动成功!

查看端口号:netstat -ntlp

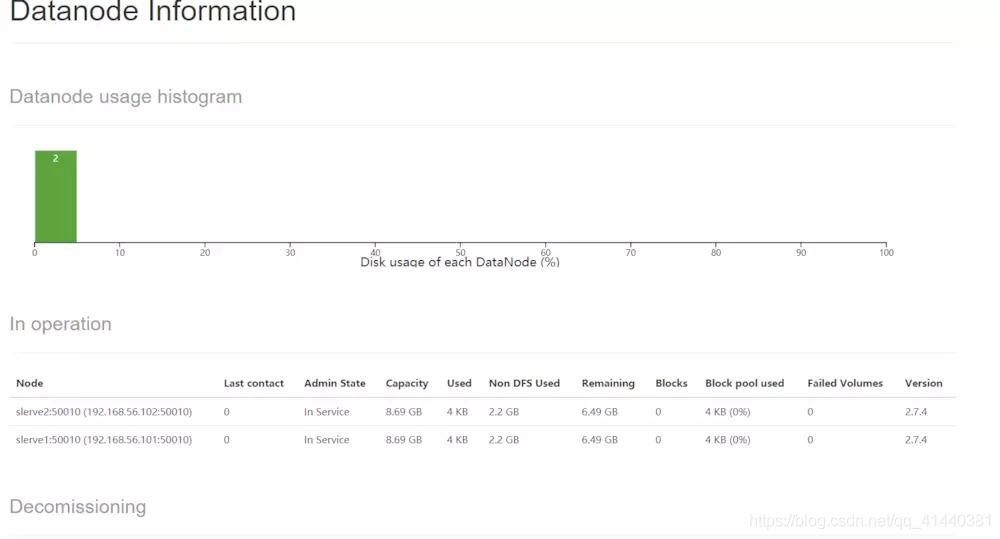

访问http://192.168.56.100:50070 查看集群情况。

集群