1.1增加hadoop用户

一)创建一个admin用户

[root@izbp11722iq94py8qx691sz home]# adduser hadoop

没输出?没有输出在linux下就是操作正确

(二)为admin用户设置密码

[root@izbp11722iq94py8qx691sz home]# passwd hadoop

Changing password for user admin.

New password:

Retype new password:

passwd: all authentication tokens updated successfully.

(三)对新hadoop用户进行sudo操作的授权

因为sudo命令是在sudoers文件中的,我们看一下sudoers文件

[root@izbp11722iq94py8qx691sz home]# sudoers

-bash: sudoers: command not found

(四) 查找sudoers文件所在

[root@izbp11722iq94py8qx691sz home]# whereis sudoers

sudoers: /etc/sudoers /etc/sudoers.d /usr/share/man/man5/sudoers.5.gz

(五)查看一下文件的权限

[root@izbp11722iq94py8qx691sz home]# ls -l /etc/sudoers

-r--r----- 1 root root 3938 Sep 6 2017 /etc/sudoers

可以看到只有只读的权限,这时候我们要加入一个可写的(w)的权限

(六)加入可写的权限

[root@izbp11722iq94py8qx691sz home]# chmod -v u+w /etc/sudoers

mode of ‘/etc/sudoers’ changed from 0440 (r--r-----) to 0640 (rw-r-----)

(七)把hadoop用户添加到sudoers中

[root@izbp11722iq94py8qx691sz home]# vi /etc/sudoers## Allow root to run any commands anywher

root ALL=(ALL) ALL

hadoop ALL=(ALL) ALL #新增hadoop用户

(八)wq保存,然后把sudoers文件权限改回去,毕竟这是一个重要的文件

[root@izbp11722iq94py8qx691sz home]# chmod -v u-w /etc/sudoers

mode of ‘/etc/sudoers’ changed from 0640 (rw-r-----) to 0440 (r--r-----)

(九)测试新用户admin进行登陆,使用su admin操作:

[root@izbp11722iq94py8qx691sz admin]# su admin

[admin@izbp11722iq94py8qx691sz ~]$

---------------------

作者:xudailong_blog

来源:CSDN

原文:https://blog.csdn.net/xudailong_blog/article/details/80518266

版权声明:本文为博主原创文章,转载请附上博文链接!

1.2同步时间

[HADOOP@izwz979fiyxxjf64z1apjcz root]$ date

Mon Oct 22 15:28:57 CST 2018

查看后没问题,跳过

1.3修改主机名称(另外两台相同方法设置)

(1)查看本机的主机名,使用如下三个命令中任意一个即可

# hostname

# uname -n

# cat /proc/sys/kernel/hostname

使用 vi 编辑器打开 /etc/hostname 文件

# vi /etc/hostname

删除文件中原有内容,添加内容主机名:hdp-node-01,保存退出

(2).设置主机名及IP映射

使用 vi 编辑器打开 /etc/hosts 文件

# vi /etc/hosts

在文件尾部添加内容,格式:IP地址 主机名(中间用空格分隔),保存退出

192.168.242.130 hdp-node-01

设置完成后,重启网路服务

# systemctl restart network

使用 ping 命令 ping 主机名

# ping hdp-node-02

如果可以ping 通,表示设置成功

---------------------

作者:HG_Harvey

来源:CSDN

原文:https://blog.csdn.net/HG_Harvey/article/details/74216759

版权声明:本文为博主原创文章,转载请附上博文链接!

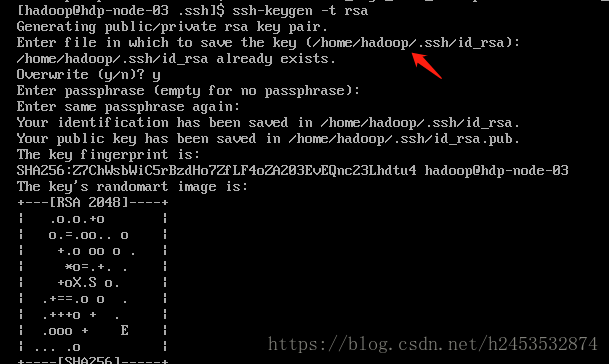

1.4配置ssh免密登陆(以hdp-node-01免密登陆hdp-node-02为例)

(1)在hadoop01机器上生成公私钥

执行以下命令后,如果提示,就一直按“Enter”键,直至生成公钥

1.在root用户下生成秘钥

su root

ssh-keygen -t rsa

执行完成后会生成两个文件id_rsa、id_rsa.pub

(2)把公钥复制到需要免密登录的服务器hadoop2

id_rsa.pub文件就是公钥,执行命令复制到hadoop2

scp id_rsa.pub root@hadoop-02:/root/.ssh/authorized_keys_from_hadoop1hadoop2上/root/.ssh/authorized_keys_from_hadoop1文件的内容就是id_rsa.pub的内容

(3)将公钥加到hadoop2的authorized_keys文件中

1. 登录到hadoop02服务器进入./ssh目录

cd root/.ssh

2. 将客户端发送来的公钥文件进行合并

cat authorized_keys_from_hadoop1 >> authorized_keys

说明:如果authorized_keys不存在就会自动创建,如果存在就会追加

(4)验证

配置免登录完成后,在本机中输入“ssh hadoop2” 或者 “ssh [email protected]” 。

* 如果无需输入密码,则表示配置免登录成功。

* 如果仍需要输入密码,则可能是.ssh目录和文件权限需要修改。

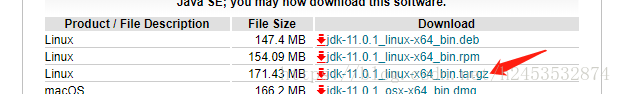

1.5安装配置jdk

(1)先去官网下jdk文件到你的Windows系统,因为wget命令无法用。(注意你的linux是64位还是32位)

(2)上传文件有很多种方法,我们这里采用最简单的 lrzsz

首先linux上安装lrzsz

yum install lrzsz上传文件,输入命令运行后弹框里选择要上传的文件,上传的文件在当前目录下

#rz 解压文件

tar -zxvf jdk-linux-x64.tar.gz配置环境变量

vim /etc/profile

添加如下内容:JAVA_HOME根据实际目录来

export JAVA_HOME=/usr/java/jdk1.8.0_161

export PATH=$PATH:$JAVA_HOME/bin

最后应用改变并测试安装

#source /etc/profile

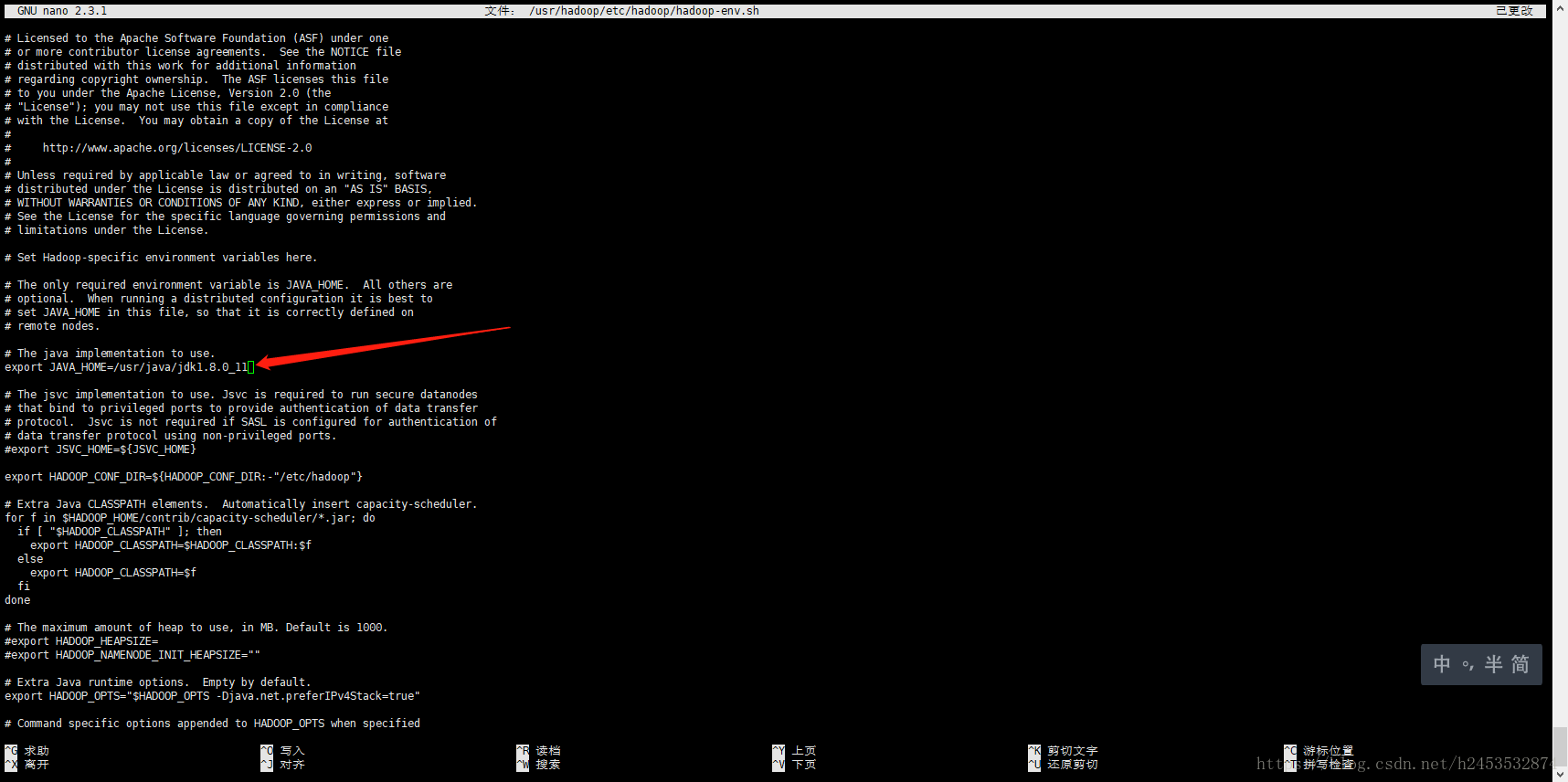

#java -version1.6安装配置hadoop

(1)下载上传hadoop二进制文件到 /user 目录下

(2)解压并重命名

tar -zxvf hadoop-2.7.7.tar.gz

mv hadoop-2.7.7 hadoop(3)配置java环境hadoop-env.sh文件

nano /usr/hadoop/etc/hadoop/hadoop-env.sh

(4).配置core-site.xml文件

nano /usr/hadoop/etc/hadoop/core-site.xml新增

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop-01:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop</value>

</property>

</configuration>(5)配置hdfs-site.xml文件

nano /usr/hadoop/etc/hadoop/hdfs-site.xml配置以下内容

<configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop-02:50090</value>

</property>

<property>

<name>dfs.namenode.secondary.https-address</name>

<value>hadoop-02:50091</value>

</property>

</configuration>

(6)配置datenode(主节点)

cd /usr/hadoop/etc/hadoop/

nano slaves删除 localhost 增加以下内容

hadoop-02

hadoop-03

(7)在/usr/hadoop/etc/hadoop/下新建masters文件

nano masters

新增以下内容

hadoop-01(8)删除/usr/hasoop/share/doc/内容

rm -rf /usr/hadoop/share/doc/

(9)配置完毕的hadoop文件夹copy到其节点

scp -r /usr/hadoop root@hadoop-02:/usr/

scp -r /usr/hadoop root@hadoop-03:/usr/

(10)格式化namenode节点

nano /etc/profile

结尾处添加

export HADOOP_HOME=/usr/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

保存文件后,使环境生效

source /etc/profile

hdfs namenode -format

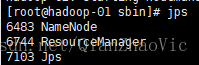

1.7启动hadoop集群

(1)在namenode节点启动hdfs

bash start-all.sh

(2)查看相关进程

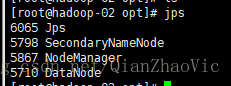

hadoop-01节点

hadoop-02节点

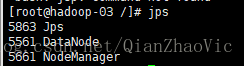

hadoop-03节点

9、网页验证

ECS实例安全组开饭50070端口权限(由于使用阿里云ECS)

在浏览器输入如下:

http://namenodeIP地址:50070