对抗样本攻击:在深度学习神经网络(DNN)输入较小的干扰因素会使DNN出现误判,这种攻击被称为是对抗样本攻击

对抗样本:是指在正常样本中有目的性地添加的一些干扰因素,使得DNN出现误判

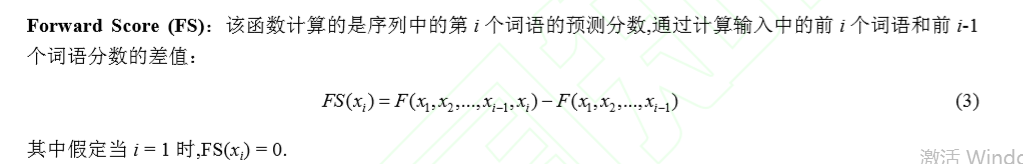

举例说明对抗样本分析带来的影响:

1、通过更改路标信息,使得车辆的DNN系统将左转识别为右转

2、在激烈的商业竞争环境下,对抗样本攻击导致恶性竞争

对抗样本分析分类:

1、白盒:白盒情景下攻击者对模型完全掌握,包括模型的类型、结构、所有参数及权重值;

2、黑盒可探测:攻击者对目标 模型部分了解,但能对模型进行探测或查询,如通过输入观察输出结果;

3、黑盒不可探测:攻击者对目标模 型了解有限或完全没有,构建对抗样本时不允许对目标模型进行探测查询.

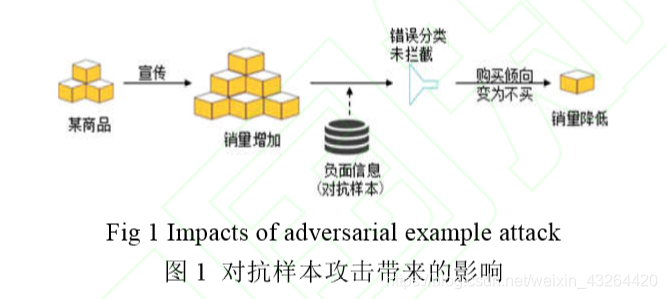

实例:

资料分享:https://blog.csdn.net/pku_langzi/article/details/83989758

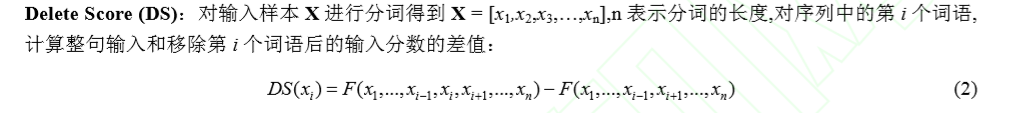

其中,需要涉及对所给文本中某些词语的重要性进行计算:

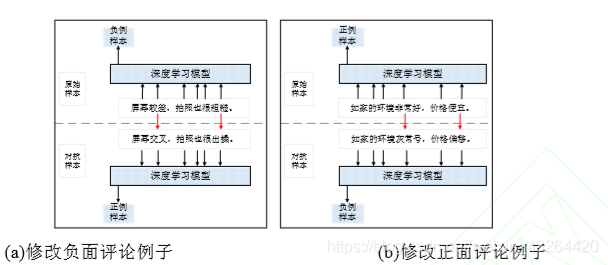

也可以单独计算某个词语的“贡献率”: