版权声明:本文为博主原创文章,转载请注明出处。 https://blog.csdn.net/weixin_39610043/article/details/87895332

论文名称

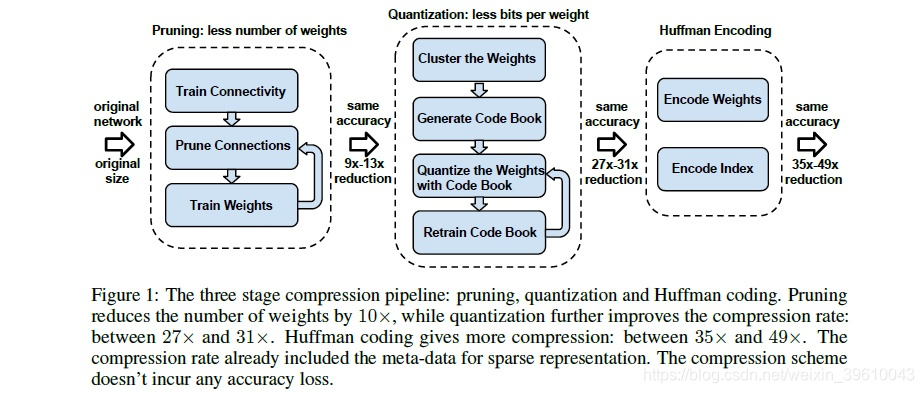

Deep Compression: Compressing Deep Neural Networks with Pruning, Trained Quantization and Huffman coding

参考博客:深度神经网络压缩

参考视频讲解:深度学习课程中的模型压缩小节

手下把论文的方法结构图放置如下:

1:剪枝:其中第一步,将模型中作用不大的参数进行去除,例如参数接近0的。

2:重新训练:剪枝之后对模型进行重新训练。

3:less bits:权值进行k-means聚类,利用1,2,3,4等值代替原来的float值。

4:对less bits之后的参数进行hufffman编码,该方式是通信中的编码方式,即对频率高的数值用低bit数进行标识,借此降低bits。