1、机器学习是什么

第一阶段:试图使用逻辑和规则直接来演绎人类的智商和智能

第二阶段: 让机器真正学会人类学习方式范式就是机器学习,通过大量的数据归纳出统计规律。

2、什么是模型

类似于y=ax+b的数学公式就是对一个模型的定义,线性回归模型就是假设建立一个模型,符合P=w1X1+w2X2+w3X3+b等式的线性模型,w1,w2,w3作为此模型的参数。

3、监督学习与损失函数

监督学习是一种归纳法!

求解方法:暴力求解法

结论:数据量太大,暴力无法做到求解

4、梯度下降

机器学习求解其实就是优化的过程,这里的优化也就是指的是梯度下降的方法。、

梯度下降也就是利用数学中求导的思想,求解下降到代价函数最优解的方法。

为什么一定能找到一个代价函数的最小值(最优解)?

代价函数J(θ)是一个多元的二次函数,数学中凸问题(凸优化)一定是有最优解。

5、数据标注的价值

大数据时代1.0: 数据的积累和呈现

大数据时代2.0: 机器学习用经验数据预测未来

机器学习给数据赋予价值

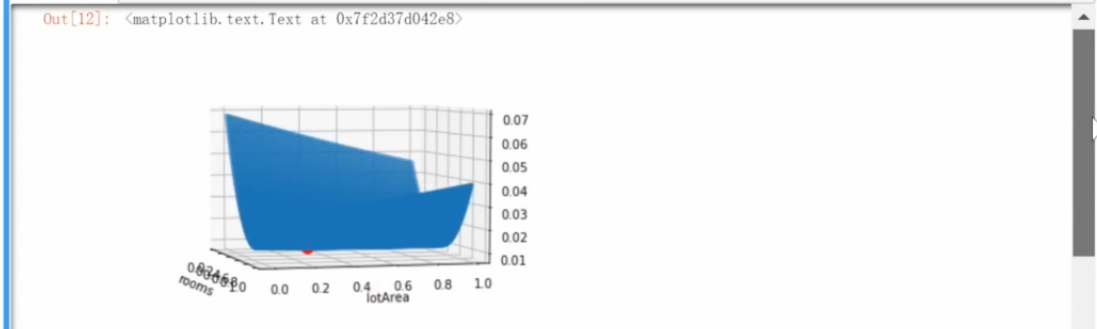

6、 线性回归模型代码展示(一)

线性回归,是最简单的回归模型。所谓回归问题,是指从一组特征,预测另一个连续的特征。

7、 线性回归模型代码展示(二)

8、 线性回归模型代码展示(三)

9、机器学习的三大基本范式(一)

dimensionality reduction 降维

reinforcement learning 强化学习

10、机器学习的三大基本范式(二)

监督学习大多数作预测,而强化学习大多数作决策。

11、 监督学习中分类和回归的特征

分类问题和回归问题都是x——y的映射,前者属于离散值,后者是连续值。

12、感知机

树突是感知信息,轴突是传递决策作用。

13、代价函数

求d,直接用点到直线的距离公式就好了。

14、随机梯度下降、如何判断分类器的好坏

随机梯度下降基于单个数据点进行调整,而不是基于整个数据集来进行调整。

随机梯度下降可能会增加时间开销,当数据集很大的情况,随机梯度下降可能花费时间会相对短,不失为一种主流的优化方法。

判断分类好坏的几个重要指标

F1-score是召回率和准确率的调和平均数,中和权衡这两个指标来判断分类的好坏。

15、感知机的缺陷及总结

16、代码展示

随即梯度下降代码展示:

17、 KNN的算法是什么

18、 如何选择KNN中的K

19、过拟合和交叉验证

20、代码展示 及KNN算法的问题

1、维度(特征)增加,距离失效

2、数据量大,算法超慢

21、 机器学习什么时候会成功

机器学习适用的条件

22、如何用概率论度量模型的不确定性(一)

23、如何用概率论度量模型的不确定性(二)

24、如何用概率论度量模型的不确定性(三)

25、如何用概率论度量模型的不确定性(四)

26、如何用概率论度量模型的不确定性(五)

27、模型误差的两种分类(一)

28、模型误差的两种分类(二)

偏差——预测值的期望值(ED)与真实值(h(x))的差值

方差——预测的真实值(y(x,Di))与预测期望值(ED)的差值

29、模型误差的两种分类(三)

如何减小泛化误差

- 数据量增加,减小方差

- 增加模型复杂度,减小偏差

- 最好的模型都有上限,噪声的限制

30、代码展示

用于训练的数据越多,预测结果的方差就越小;

用于训练的模型越复杂,预测结果的偏差就越小;

31、如何选择好的特征值(一)

相关性来看与特征是正相关还是负相关。

32、如何选择好的特征值(二)

33、如何选择好的特征值(三)

34、正则化(一)

35、正则化(二)

36、代码展示(一)

37、代码展示(二)

38、逻辑斯蒂(Logistic)模型

即机器学习的三步骤:找模型、损失函数、调参(梯度下降)

逻辑斯蒂(Logistic)模型和概率有关系,需要将线性回归-∞—+∞转化为0—1的概率,;

39、交叉熵KL散度

40、如何度量模型的目标(一)

41、如何度量模型的目标(二)

42、如何求解逻辑斯蒂回归模型的优化问题(一)

43、如何求解逻辑斯蒂回归模型的优化问题(二)

44、代码展示(一)

45、代码展示(二)

46、代码展示(三)

47、决策树是什么

48、信息熵,如何衡量哪些特征重要

49、如何用信息增益在决策树中选择特征(一)

50、如何用信息增益在决策树中选择特征(二)

51、决策树的构建何时停下来

52、决策树如何应对连续特征

53、决策树如何应对过拟合

54、随机森林在回归问题上的代码演示

55、复习决策树

56、Bagging方法

典型的例子:随机森林(并行思维)

57、Boosting方法(一)

另一种集成方法是stacking,形如Bagging和Boosting两种方法特点的结合;

Boosting方法的演化和改进方法:

GradientBoosting的方法核心思想——残差拟合

58、Boosting方法(二)

59、Boosting方法(三)

60、Boosting方法(四)

AdaBoost是尝试不同损失函数的结果

AdaBoost和Gradient Boosting很像,只不过处理梯度的方法不一样,另外Gradient Boosting是对样本的权重进行调整,AdaBoost是最后测试加合时给了不同的比重,正确率越高,权重越大;

61、主成分分析背后的直觉

62、PCA怎么做

63、代码展示(一)

64、代码展示(二)

65、传统机器学习方法的问题(一)

66、传统机器学习方法的问题(二)

67、神经网络的历史发展

68、神经网络三要素之一:权重矩阵

69、神经网络三要素之激活函数、决策层

70、网页展示

71、SVM的目标:如何将间隔最大化

72、SVM要解决什么样的优化问题

73、拉格朗日最优问题的解法(一)

74、拉格朗日最优问题的解法(二)

75、SVM中的软间隔

76、SVM中的核函数

77、核函数为什么有用(一)

78、核函数为什么有用(二)

79、SVM与其他模型的对比

SVM同样是解决线性不可分问题的办法,作用在原特征的基础上,后来被复杂的神经网络所慢慢取代地位;

SVM的核心思想是正则(使分类区两端尽可能分的开,硬间隔和软间隔);

SVM通过升维(非线性项x1x2)的方式来解决二维线性不可分;

VC维增加,拟合能力变强,容易产生过拟合;其中C参数能限制过拟合,C越小,过拟合越小;