版权声明:博客内容都是对一些知识的整理,可能有些部分存在借鉴,如果存在侵权,请联系我删掉。 https://blog.csdn.net/cunxinlitian/article/details/82707176

6 正则化

6.1 过拟合问题

通过学习得到的假设可能能够非常好地适应训练集(代价函数可能几乎为 0),但是可能会不能推广到新的数据。如何处理过拟合问题:

1)丢弃一些不能帮助我们正确预测的特征。可以是手工选择保留哪些特征,或者使用一些模型选择的算法来帮忙(例如 PCA)。

2)正则化。保留所有的特征,但是减少参数的大小( magnitude)。

6.2 正则化参数

回归问题中的模型为:,其中,高次项导致了过拟合的产生,若使高次项系数接近于0,就能更好地拟合。在一定程度上减小参数的值,就是正则化的基本方法。能够防止过拟合问题的代价函数表示为:

其中,称为正则化参数(Regularization Parameter),不对

进行惩罚。若

过大,会把所有的参数都最小化,导致模型变成

,造成欠拟合。取一个合理的

的值,这样才能更好的应用正则化。

6.3 正则化线性回归

对于线性回归的求解,主要有两种学习算法:一种基于梯度下降,一种基于正规方程。正则化线性回归的代价函数为:

梯度下降算法将分为两种情形:

Repeat until convergence{

}

Repeat

对上面的算法中j=1,2,…,n时的更新式子进行调整可得:

可以看出,正则化线性回归的梯度下降算法的变化在于,每次都在原有算法更新规则的基础上令值减少了一个额外的值。

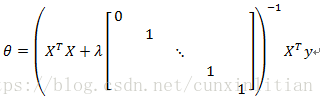

利用正规方程求解正则化线性回归模型,方法如下:

图中的矩阵尺寸为(n+1)*(n+1)。

6.4 正则化逻辑回归

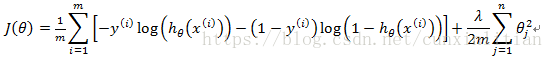

正则化逻辑回归的代价函数表示为:

最小化代价函数,通过求导,得出梯度下降算法为:

Repeat until convergence{

}