关于熵(对所有信息量的期望),交叉熵,最大似然估计=最小KL散度的理论。转自

https://blog.csdn.net/tsyccnh/article/details/79163834

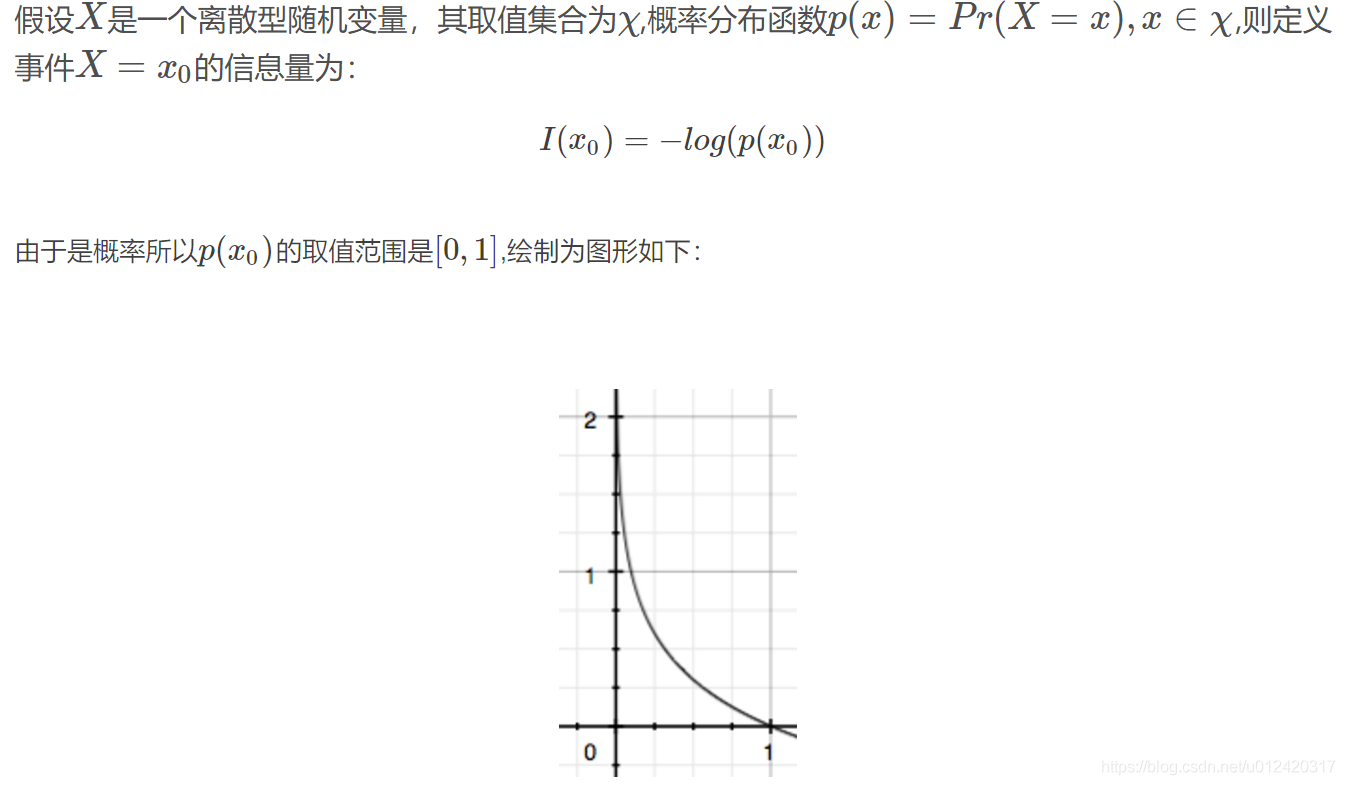

越容易发生的事件其信息量越小。

信息量:

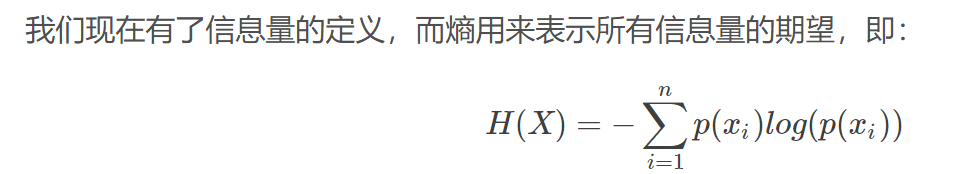

熵:

熵表示信息量的期望

其中的n代表n种可能性。即事件取的n种可能值。

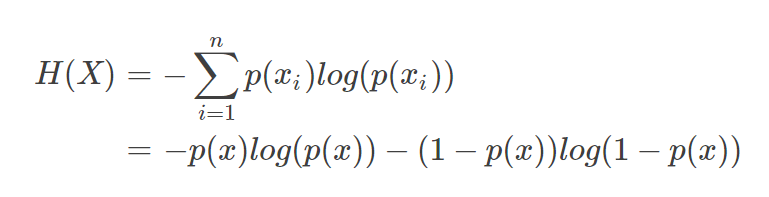

当n取2时,如抛硬币等问题,此时有

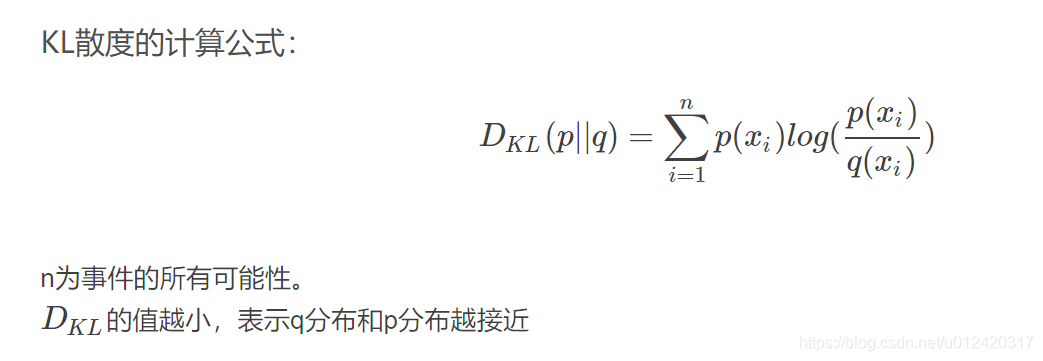

相对熵

也叫做KL散度,如果我们对于同一个随机变量 x 有两个单独的概率分布 P(x) 和 Q(x),我们可以使用 KL 散度(Kullback-Leibler (KL) divergence)来衡量这两个分布的差异。

如果用P来描述目标问题,而不是用Q来描述目标问题,得到的信息增量。