版权声明:转载需附上本文地址 https://blog.csdn.net/weikaixxxxxx/article/details/86431562

es对中文分词不给力,所以要用ik分词器。

下载和es对应版本的ik

# cd /usr/local/elasticsearch-6.5.3/plugins

# mkdir ik

# cd ik/

# wget https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v6.5.3/elasticsearch-analysis-ik-6.5.3.zip

# unzip elasticsearch-analysis-ik-6.5.3.zip

# rm elasticsearch-analysis-ik-6.5.3.zip

y+回车

因为ik要解压到这个目录下,所以直接下载到那。

不用配置什么,运行的时候ES会自动检测ik/plugin-descriptor.properties,如果没有这个文件,说明下载的不对。

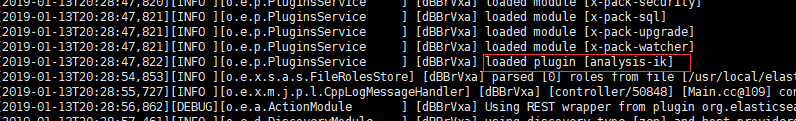

重启es。

如果不成功,https://github.com/medcl/elasticsearch-analysis-ik/tree/v6.5.3,把版本号改成你的es版本号,然后访问这个地址,看具体的安装方法。

注:不是从Elasticsearch(一)看过来的读者可以关闭此页面了。

测试,软件是postman

在没有使用ik前,搜索逼真这个词,搜出了包含搜索字体的内容。

搜索地址,必须加q=后面是字段名“:”之后才是要搜索的词

http://192.168.247.140:9200/test/test/_search?q=name:逼真

在head插件页面删除这个索引

新建索引

PUT 方式提交

http://192.168.247.140:9200/test

json格式

{

"settings" : {

"index" : {

"analysis.analyzer.default.type": "ik_max_word"

}

}

}

刷新head插件。

再通过logstash-input-jdbc插件同步数据

就只出现了搜索词语的数据了。