文章目录

0.前提

windows下搭建spark环境需要首先在本地安装JDK,spark支持的jdk版本为1.8及以上

1. 安装Scala

1.1. 下载Scala

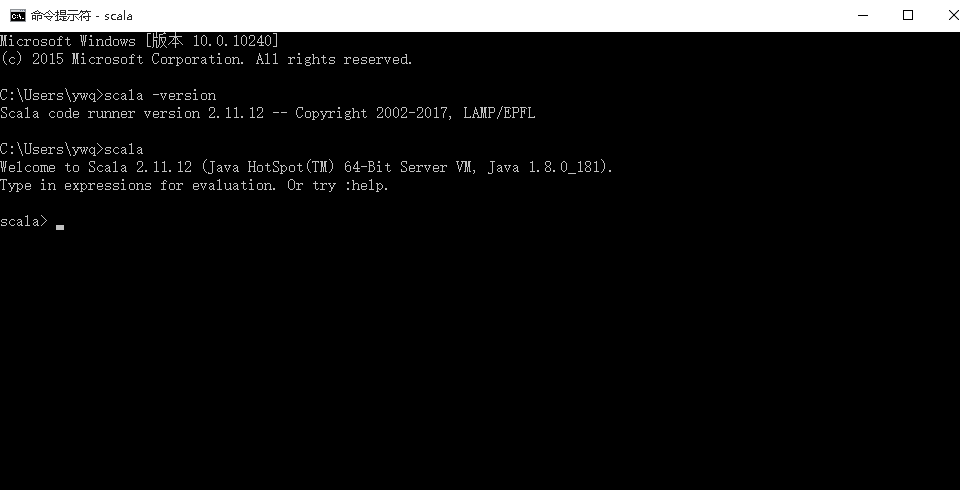

我安装的是Scala2.11.12版本

1.2. 配置环境变量

SCALA_HOME=C:\Users\ywq\soft\Scala

path=%SCALA_HOME%\bin;

1.3. 验证

# 查看版本号

scala-version

# 进入scala环境

scala

如果出现上图所示结果,说明Scala安装成功

2. 安装spark

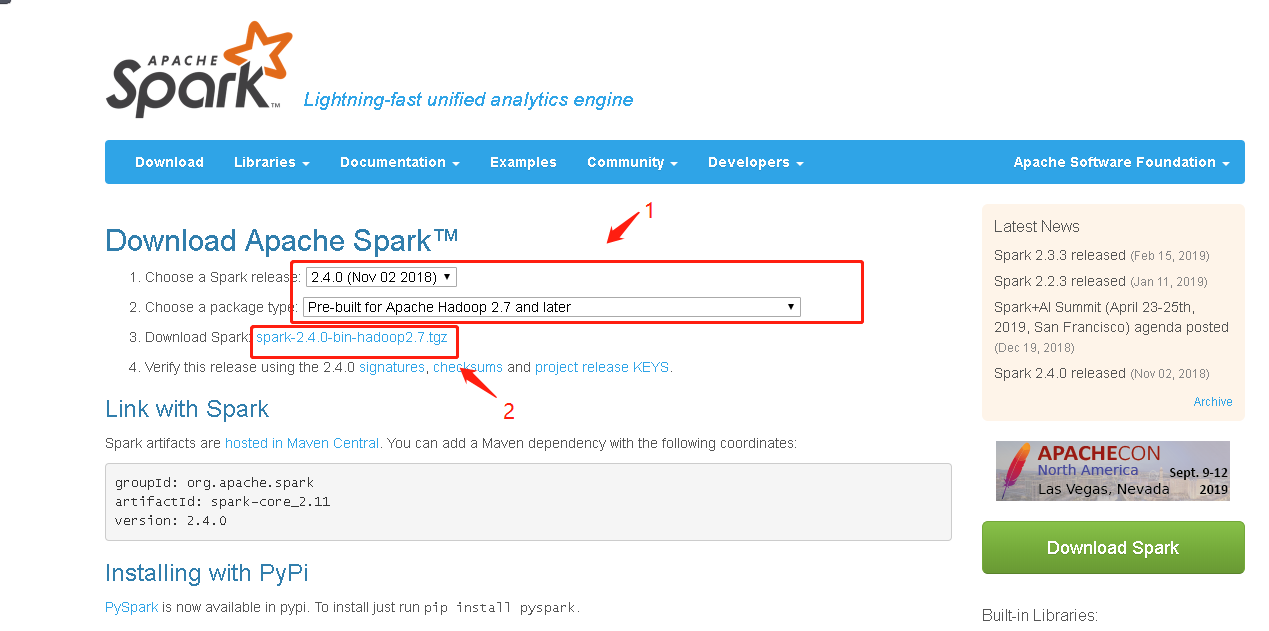

2.1. 下载spark

2.2. 配置环境变量

spark不需要安装,解压后配置path环境变量即可

path=C:\Users\ywq\Downloads\spark-2.4.0-bin-hadoop2.7\spark-2.4.0-bin-hadoop2.7\bin;

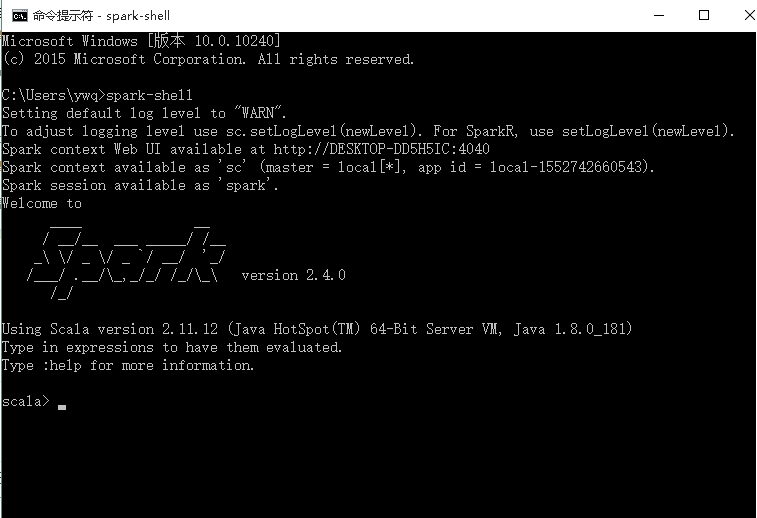

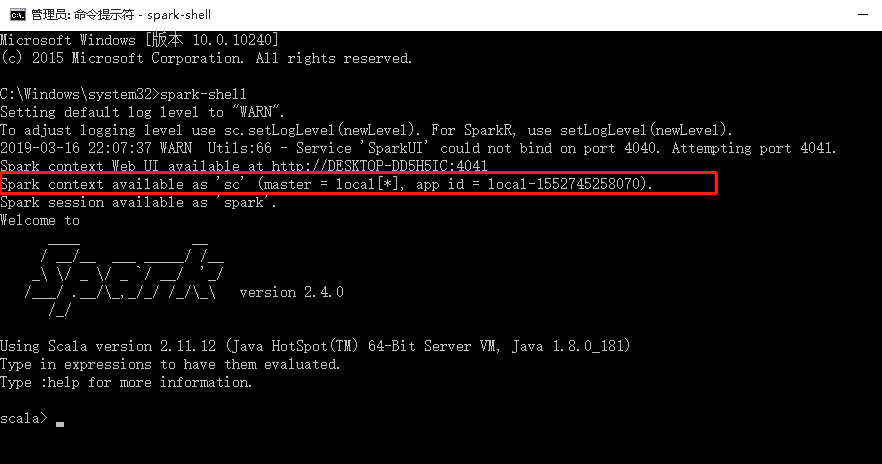

2.3. 验证spark是否能正常启动

spark-shell

# 在命令行输入以上命令,中间是没有空格的

出现上图说明spark安装成功

3. 安装hadoop

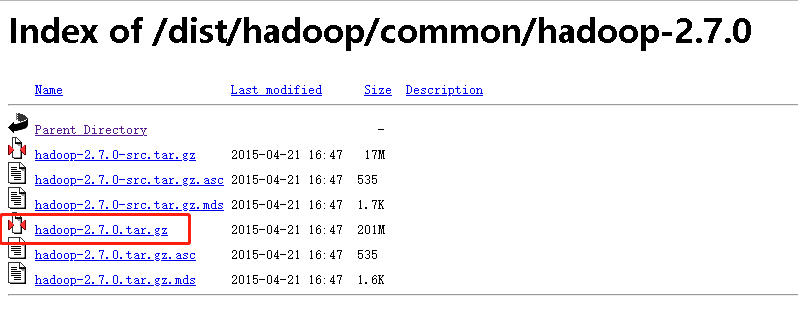

3.1. 下载

- 注:这里要和spark中选择的hadoop保持一致,所以我的是hadoop2.7

3.2. 安装

解压即安装

扫描二维码关注公众号,回复:

5619955 查看本文章

3.3. 配置环境变量

HADOOP_HOME=E:\hadoop-2.7.2\hadoop-2.7.2

path=%HADOOP_HOME%\bin;

3.4. 安装hadoop winutils,

选择你要的hadoop版本号,你只需要下载winutils.exe,然后拷贝到Hadoop目录下的bin文件夹中。(如果你的bin目录下已经有该文件,就不必再下载了)

3.5. 验证

以管理员身份打开cmd,运行spark-shell,如果遇到访问权限等错误的话,运行 winutils.exe chmod 777 \tmp\hive

以管理员身份打开cmd,运行spark-shell,你应该看到如下界面

最重要的,你要看到Spark context available as ‘sc’ (master = local[*], app id = local-1507235397368).字样

这时,你的spark环境已经搭建成功了!