bond接口

Red Hat Enterprise Linx 允许管理员使用 bonding 内核模块和称为通道绑定接口的特殊网络接口将多个网络接口绑定到一个通道。根据选择的绑定方式,通道绑定使两个或者更多个网络接口作为一个网络接口,从而增加带宽/提供冗余性。

选择Linux以太网绑定模式

模式0(平衡轮循)-轮循策略,所有接口都采用轮循方式在所有Slave 中传输封包;任何Slave都可以接收。增大传输速率

模式1 (主动备份)-容错。一次只能使用一个Slave 接口,但如果该接口出现故障,另一个Slave将接替他。

模式3 (广播)-容错。DHCP。所有封包都通过所有Slave 接口广播。

模式(备份)最常用,防止服务器网卡出现问题无法访问。

主备模式测试:

首先添加多块网卡(这里添加eth0和eth1)

删除网卡信息

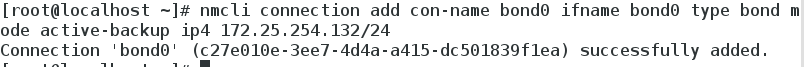

添加bond接口

nmcli connection add con-name bond0 ifname bond0 type bond mode active-backup ip4 172.25.254.100/24

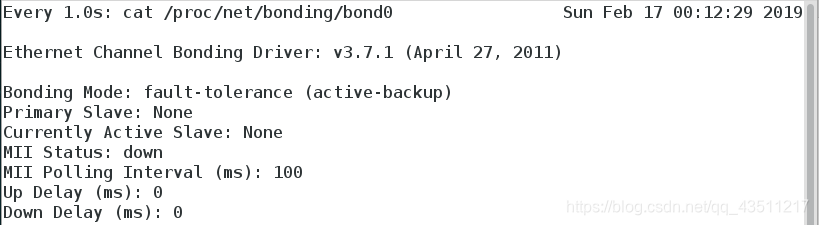

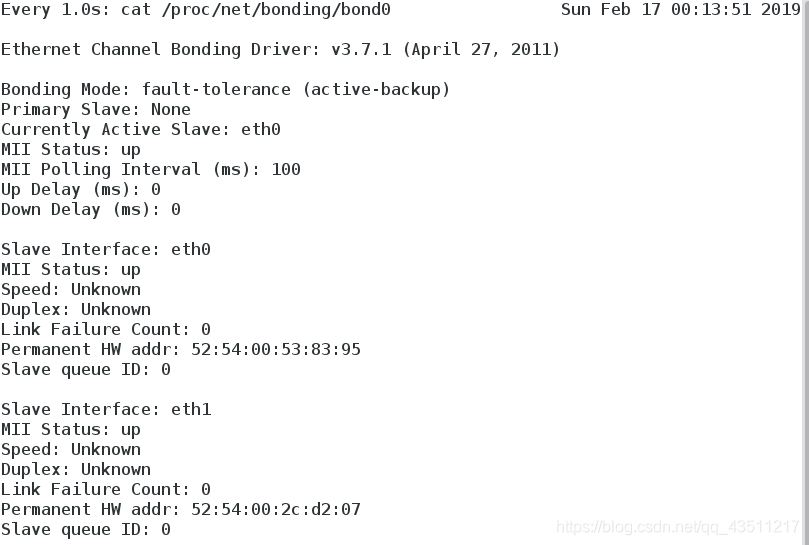

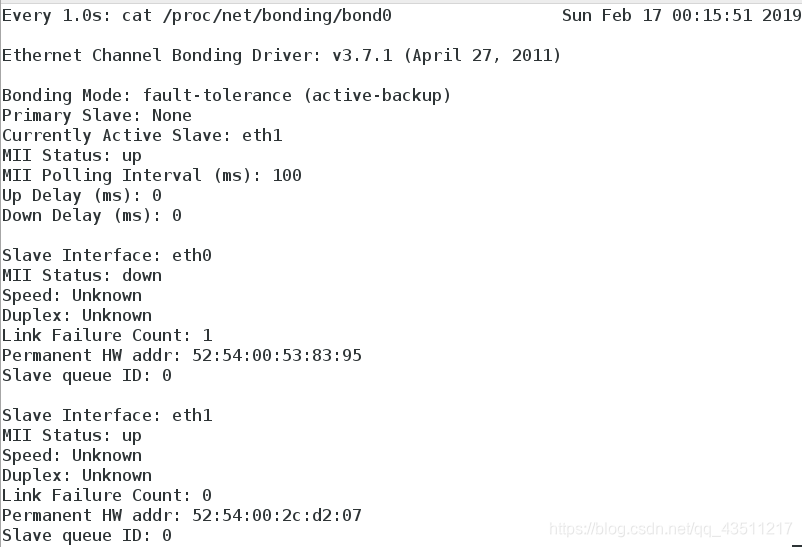

watch -n1 cat /proc/net/bonding/bond0 ##监控bond接口

为bond0添加物理硬件网卡

nmcli connection add con-name eth0 ifname eth0 type bond-slave master bond0

nmcli connection add con-name eth1 ifname eth1 type bond-slave master bond0

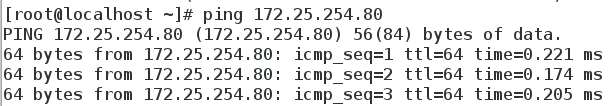

ping 172.25.254.80

ifconfig eth0 down ##关掉eth0

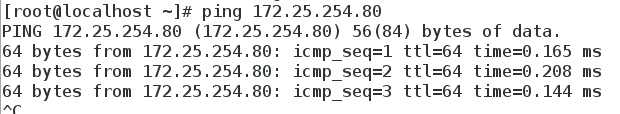

ping 172.25.254.80

删除bond0

nmcli connection delete bond0

Team接口

Team 和bond功能类似

Team不需要手动加载相应内核模块

Team有更强的拓展性

支持8块网卡

Team的种类

broadcast ##广播容错

roundrobin ##平衡轮循

activebackup ##主备

loadbalance ##负载均衡

主备模式测试:

首先需要添加两块网卡

新建team0接口

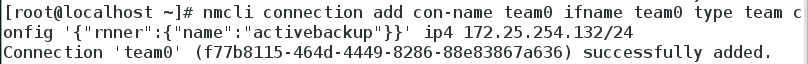

nmcli connection add con-name team0 ifname team0 type team config '{"rnner":{"name":"activebackup"}}' ip4 172.25.254.132/24

watch -n1 teamdctl team0 stat ##监控team0接口信息

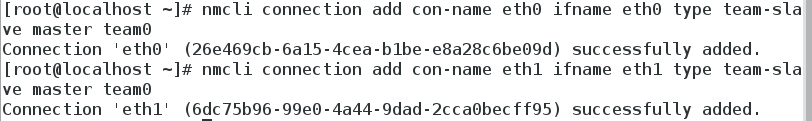

为team0添加硬件设备

nmcli connection add con-name eth0 ifname eth0 type team-slave master team0

nmcli connection add con-name eth1 ifname eth1 type team-slave master team0

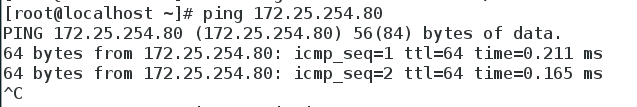

ping 172.25.254.80

此时无论当掉哪一个网卡网络依然畅通

桥接

模拟问题:

su - root ##切换到root

cd /etc/sysconfig/network-scripts/

ls

mkdir /backup

cp ifcfg-br0 ifcfg-enp0s25 /backup/

删除所有网络配置

重新配置网络为以太网

reboot

su - root ##切换到root

virt-manager

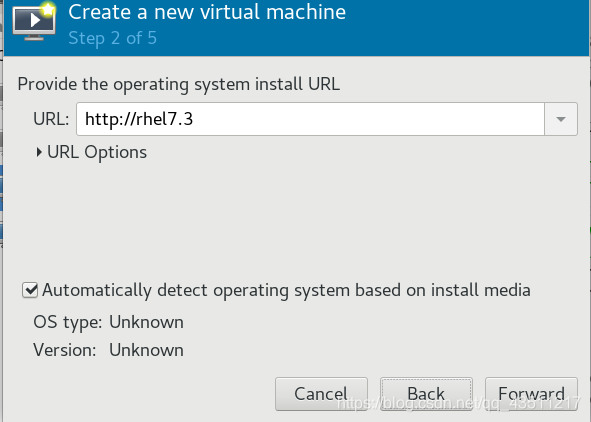

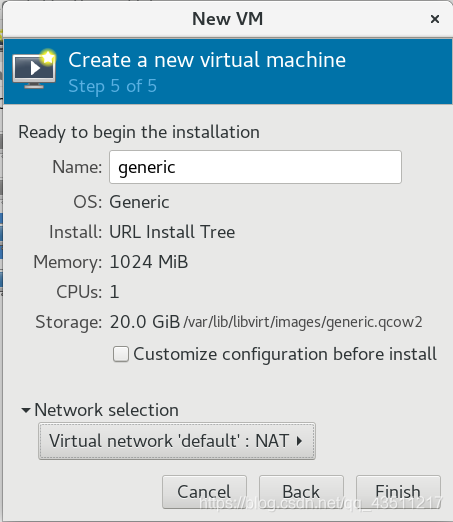

网络源方式新建虚拟机

http://172.25.254.180/rhel7.3

到Network selection这一步时只能选择NAT

ping本地主机时延时很大

建立网络桥接

cd /etc/systemconfig/network-scripts/

ls

vim ifcfg-test

1 BOOTPROTO=none

2 NAME=westos

3 DEVICE=enp0s25

4 ONBOOT=yes

5 BRIDGE=br0

vim ifcfg-br0

1 DEVICE=br0

2 IPADDR=172.25.254.32

3 PREFIX=24

4 ONBOOT=yes

5 BOOTPROTO=none

6 TYPE=Bridge

此时仍然无法打开本地创建好的使用桥接的虚拟机

因为br0没有启用

systemctl stop NetworkManager

systemctl restart network

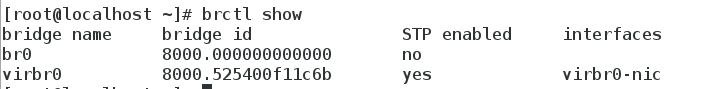

brctl show ##查询桥接状态

bridge name bridge id STP enabled interfaces

br0 8000.0021cc6e64b5 no enp0s25

privbr0 8000.525400fc4ea6 yes privbr0-nic

virbr0 8000.525400e038d3 yes virbr0-nic

virbr1 8000.525400ec0967 yes virbr1-nic

再次使用网络源安装虚拟机

Network selection可以选择Bridge br0

ping本地主机可以看到网络延时减小

使用桥接的虚拟机可以正常运行

命令临时设定网络桥接

1.添加网络桥接

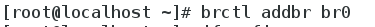

brctl show ##查看网络桥接

brctl addbr br0 ##添加网络桥接br0

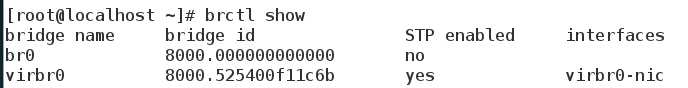

brctl show ##查看br0已经出现

ifconfig br0 172.25.254.132/24 ##设定br0的ip和子网掩码

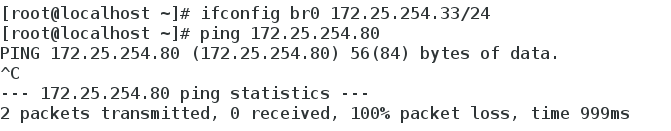

ping 172.25.254.32 ##此时无法ping通,因为没有添加硬件设备

brctl addif br0 eth0 ##为br0添加硬件设备eth0

ping 172.25.254.32 ##成功

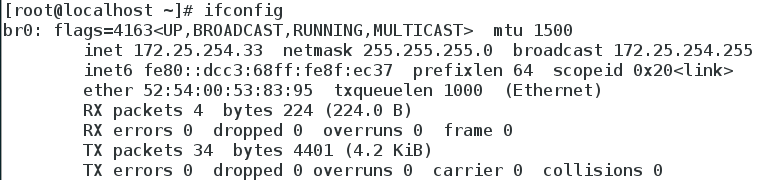

ifconfig ##查看br0

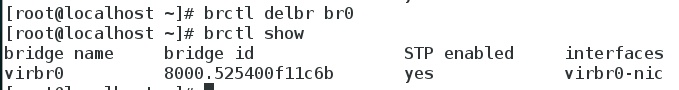

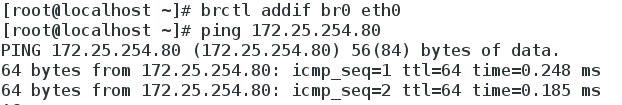

2.删除网络桥接

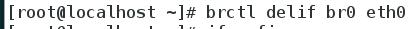

首先删除br0的硬件设备

brctl delif br0 eth0 ##删除eth0

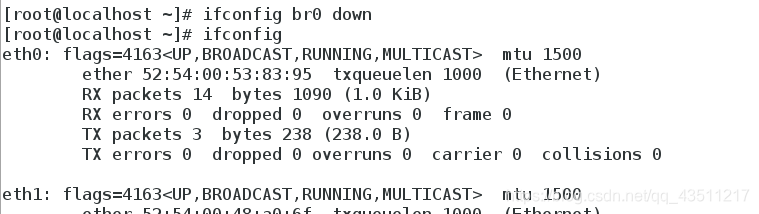

ifconfig br0 down ##卸载网络桥接br0

brctl delbr br0 ##删除br0接口

brctl show ##查看网络桥接,br0已经消失