损失函数

损失函数,又叫目标函数,是编译一个神经网络模型必须的两个参数之一。另一个必不可少的参数是优化器。

损失函数是指用于计算标签值和预测值之间差异的函数,在机器学习过程中,有多种损失函数可供选择,典型的有距离向量,绝对值向量等。

我们先定义两个二维数组,然后用不同的损失函数计算其损失值。

import torch

from torch.autograd import Variable

import torch.nn as nn

import torch.nn.functional as F

sample = Variable(torch.ones(2,2))

a=torch.Tensor(2,2)

a[0,0]=0

a[0,1]=1

a[1,0]=2

a[1,1]=3

target = Variable (a)

sample 的值为:[[1,1],[1,1]]。

target 的值为:[[0,1],[2,3]]。

1 nn.L1Loss

L1Loss 计算方法很简单,取预测值和真实值的绝对误差的平均数即可。

criterion = nn.L1Loss()

loss = criterion(sample, target)

print(loss)

最后结果是:1。

它的计算逻辑是这样的:

先计算绝对差总和:|0-1|+|1-1|+|2-1|+|3-1|=4;

然后再平均:4/4=1。

2 nn.SmoothL1Loss

SmoothL1Loss 也叫作 Huber Loss,误差在 (-1,1) 上是平方损失,其他情况是 L1 损失。

criterion = nn.SmoothL1Loss()

loss = criterion(sample, target)

print(loss)

最后结果是:0.625。

3 nn.MSELoss

平方损失函数。其计算公式是预测值和真实值之间的平方和的平均数。

criterion = nn.MSELoss()

loss = criterion(sample, target)

print(loss)

最后结果是:1.5。

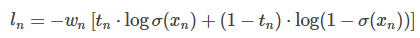

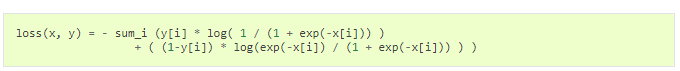

4 nn.BCELoss

二分类用的交叉熵,其计算公式较复杂,这里主要是有个概念即可,一般情况下不会用到。

criterion = nn.BCELoss()

loss = criterion(sample, target)

print(loss)

最后结果是:-13.8155。

5 nn.CrossEntropyLoss

交叉熵损失函数

该公式用的也较多,比如在图像分类神经网络模型中就常常用到该公式。

criterion = nn.CrossEntropyLoss()

loss = criterion(sample, target)

print(loss)

最后结果是:报错,看来不能直接这么用!

看文档我们知道 nn.CrossEntropyLoss 损失函数是用于图像识别验证的,对输入参数有各式要求,这里有这个概念就可以了,在图像识别一文中会有正确的使用方法。

6 nn.NLLLoss

负对数似然损失函数(Negative Log Likelihood)

在前面接上一个 LogSoftMax 层就等价于交叉熵损失了。注意这里的 xlabel 和上个交叉熵损失里的不一样,这里是经过 log 运算后的数值。这个损失函数一般也是用在图像识别模型上。

criterion = F.nll_loss()

loss = criterion(sample, target)

print(loss)

loss=F.nll_loss(sample,target)

最后结果是:报错,看来不能直接这么用!

Nn.NLLLoss 和 nn.CrossEntropyLoss 的功能是非常相似的!通常都是用在多分类模型中,实际应用中我们一般用 NLLLoss 比较多。

7 nn.NLLLoss2d

和上面类似,但是多了几个维度,一般用在图片上。

input, (N, C, H, W)

target, (N, H, W)

比如用全卷积网络做分类时,最后图片的每个点都会预测一个类别标签。

criterion = nn.NLLLoss2d()

loss = criterion(sample, target)

print(loss)

最后结果是:报错,看来不能直接这么用!

8 BCEWithLogitsLoss 与 MultilabelSoftMarginLoss

BCEWithLogitsLoss :

MultiLabelSoftMarginLoss :

可以看出, 后者是前者权值为1时的特例。

import torch

from torch.autograd import Variable

from torch import nn

x = Variable(torch.randn(10, 3))

y = Variable(torch.FloatTensor(10, 3).random_(2))

# double the loss for class 1

class_weight = torch.FloatTensor([1.0, 2.0, 1.0])

# double the loss for last sample

element_weight = torch.FloatTensor([1.0]*9 + [2.0]).view(-1, 1)

element_weight = element_weight.repeat(1, 3)

bce_criterion = nn.BCEWithLogitsLoss(weight=None, reduce=False)

multi_criterion = nn.MultiLabelSoftMarginLoss(weight=None, reduce=False)

bce_criterion_class = nn.BCEWithLogitsLoss(weight=class_weight, reduce=False)

multi_criterion_class = nn.MultiLabelSoftMarginLoss(weight=class_weight,

reduce=False)

bce_criterion_element = nn.BCEWithLogitsLoss(weight=element_weight, reduce=False)

multi_criterion_element = nn.MultiLabelSoftMarginLoss(weight=element_weight,

reduce=False)

bce_loss = bce_criterion(x, y)

multi_loss = multi_criterion(x, y)

bce_loss_class = bce_criterion_class(x, y)

multi_loss_class = multi_criterion_class(x, y)

print(bce_loss_class)

print(multi_loss_class)

print('bce_loss',bce_loss)

print('bce loss mean', torch.mean(bce_loss, dim = 1))

print('multi_loss', multi_loss)

参考:

1 Pytorch 论坛;

2 图灵社区;

3 sshuair’s notes PyTorch中的Loss Fucntion