这篇复习第二个非常经典的模型——逻辑回归。《百面机器学习》中内容不是很全,所以与上篇SVM类似,先参考《统计学习方法》和CS229对相关知识点进行总结,再看下《百面机器学习》提到几个相关面试题。

设

X

X

X

X

X

X

X

X

X

F

(

x

)

=

P

(

X

⩽

x

)

=

1

1

+

e

−

(

x

−

μ

)

/

γ

F(x)=P(X\leqslant x)=\frac 1 {1+e^{-(x-\mu)/\gamma}}

F ( x ) = P ( X ⩽ x ) = 1 + e − ( x − μ ) / γ 1

f

(

x

)

=

F

′

(

x

)

=

e

−

(

x

−

μ

)

/

γ

γ

(

1

+

e

−

(

x

−

μ

)

/

γ

)

2

f(x)=F^{\prime}(x)=\frac {e^{-(x-\mu)/\gamma}}{\gamma(1+e^{-(x-\mu)/\gamma})^2}

f ( x ) = F ′ ( x ) = γ ( 1 + e − ( x − μ ) / γ ) 2 e − ( x − μ ) / γ

μ

\mu

μ

γ

>

0

\gamma>0

γ > 0

二项逻辑回归模型是一种分类模型,由条件概率分布

P

(

Y

∣

X

)

P(Y|X)

P ( Y ∣ X )

二项逻辑回归模型是如下的条件概率分布:

P

(

Y

=

1

∣

x

)

=

e

x

p

(

w

⋅

x

+

b

)

1

+

e

x

p

(

w

⋅

x

+

b

)

P(Y=1|x)=\frac{exp(w\cdot x+b)}{1+exp(w\cdot x+b)}

P ( Y = 1 ∣ x ) = 1 + e x p ( w ⋅ x + b ) e x p ( w ⋅ x + b )

P

(

Y

=

0

∣

x

)

=

1

1

+

e

x

p

(

w

⋅

x

+

b

)

P(Y=0|x)=\frac1{1+exp(w\cdot x+b)}

P ( Y = 0 ∣ x ) = 1 + e x p ( w ⋅ x + b ) 1

w

,

x

w,x

w , x

w

=

(

w

(

1

)

,

w

(

2

)

,

.

.

.

,

w

(

n

)

,

b

)

T

,

x

=

(

x

(

1

)

,

x

(

2

)

,

.

.

.

,

x

(

n

)

,

1

)

T

w=(w^{(1)},w^{(2)},...,w^{(n)},b)^T, x=(x^{(1)},x^{(2)},...,x^{(n)},1)^T

w = ( w ( 1 ) , w ( 2 ) , . . . , w ( n ) , b ) T , x = ( x ( 1 ) , x ( 2 ) , . . . , x ( n ) , 1 ) T

P

(

Y

=

1

∣

x

)

=

e

x

p

(

w

⋅

x

)

1

+

e

x

p

(

w

⋅

x

)

P(Y=1|x)=\frac{exp(w\cdot x)}{1+exp(w\cdot x)}

P ( Y = 1 ∣ x ) = 1 + e x p ( w ⋅ x ) e x p ( w ⋅ x )

P

(

Y

=

0

∣

x

)

=

1

1

+

e

x

p

(

w

⋅

x

)

P(Y=0|x)=\frac1{1+exp(w\cdot x)}

P ( Y = 0 ∣ x ) = 1 + e x p ( w ⋅ x ) 1

一个事件的几率(odds)是指该事件发生的概率与该事件不发生的概率的比值。如果事件发生的概率是

p

p

p

p

1

−

p

\frac p {1-p}

1 − p p

l

o

g

i

t

(

p

)

=

l

o

g

p

1

−

p

logit(p)=log\frac p{1-p}

l o g i t ( p ) = l o g 1 − p p

l

o

g

P

(

Y

=

1

∣

x

)

P

(

Y

=

0

∣

x

)

=

w

⋅

x

log\frac{P(Y=1|x)}{P(Y=0|x)}=w\cdot x

l o g P ( Y = 0 ∣ x ) P ( Y = 1 ∣ x ) = w ⋅ x

Y

=

1

Y=1

Y = 1

x

x

x

逻辑回归模型应用极大似然估计法估计模型参数,具体如下:

设:

P

(

Y

=

1

∣

x

)

=

π

(

x

)

P(Y=1|x)=\pi(x)

P ( Y = 1 ∣ x ) = π ( x )

P

(

Y

=

0

∣

x

)

=

1

−

π

(

x

)

P(Y=0|x)=1-\pi(x)

P ( Y = 0 ∣ x ) = 1 − π ( x )

则

P

(

Y

∣

x

)

=

π

(

x

)

Y

(

1

−

π

(

x

)

)

1

−

Y

P(Y|x)=\pi(x)^Y(1-\pi(x))^{1-Y}

P ( Y ∣ x ) = π ( x ) Y ( 1 − π ( x ) ) 1 − Y

∏

i

=

1

N

[

π

(

x

i

)

]

y

i

[

1

−

π

(

x

i

)

]

1

−

y

i

\prod_{i=1}^N[\pi(x_i)]^{y_i}[1-\pi(x_i)]^{1-y_i}

i = 1 ∏ N [ π ( x i ) ] y i [ 1 − π ( x i ) ] 1 − y i

L

(

w

)

=

∑

i

=

1

N

[

y

i

l

o

g

π

(

x

i

)

+

(

1

−

y

i

)

l

o

g

(

1

−

π

(

x

i

)

)

]

L(w)=\sum_{i=1}^N[y_ilog\pi(x_i)+(1-y_i)log(1-\pi(x_i))]

L ( w ) = i = 1 ∑ N [ y i l o g π ( x i ) + ( 1 − y i ) l o g ( 1 − π ( x i ) ) ]

=

∑

i

=

1

N

[

y

i

l

o

g

π

(

x

i

)

1

−

π

(

x

i

)

+

l

o

g

(

1

−

π

(

x

i

)

)

]

=\sum_{i=1}^N \lbrack y_ilog\frac{\pi(x_i)}{1-\pi(x_i)}+log(1-\pi(x_i)) \rbrack

= i = 1 ∑ N [ y i l o g 1 − π ( x i ) π ( x i ) + l o g ( 1 − π ( x i ) ) ]

=

∑

[

y

i

(

w

⋅

x

i

)

−

l

o

g

(

1

+

e

x

p

(

w

⋅

x

i

)

)

]

=\sum[y_i(w\cdot x_i)-log(1+exp(w\cdot x_i))]

= ∑ [ y i ( w ⋅ x i ) − l o g ( 1 + e x p ( w ⋅ x i ) ) ]

其实就是softmax,

P

(

Y

=

k

∣

x

)

=

e

x

p

(

w

k

⋅

x

)

∑

i

=

1

K

e

x

p

(

w

k

⋅

x

)

P(Y=k|x)=\frac{exp(w_k\cdot x)}{\sum_{i=1}^K exp(w_k\cdot x)}

P ( Y = k ∣ x ) = ∑ i = 1 K e x p ( w k ⋅ x ) e x p ( w k ⋅ x )

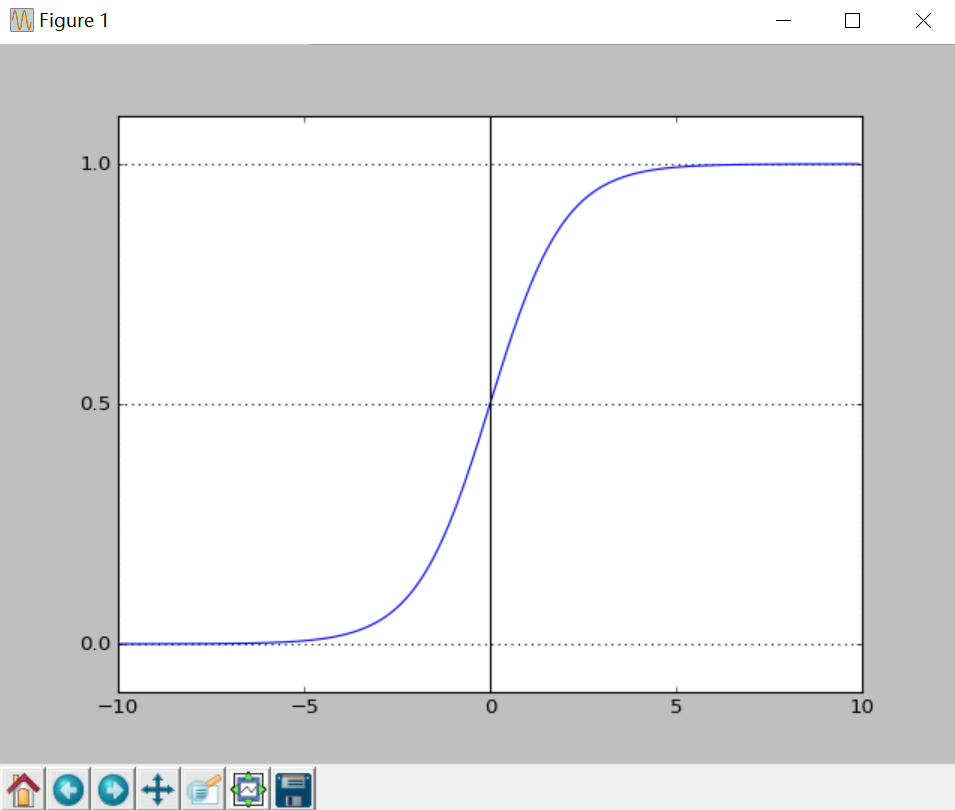

对于sigmoid这个函数怎么来的,为什么逻辑回归要选用sigmoid函数,前面都没给出形式化的解释。后来终于在CS229课上找到答案,其实我们可以从广义线性模型展开思考。

在介绍广义线性模型之前,先要说下指数分布族,因为指数分布族是广义线性模型提出的假设之一。

如果一个分布可以用

p

(

y

;

η

)

=

b

(

y

)

e

x

p

(

η

T

T

(

y

)

−

a

(

η

)

)

p(y;\eta)=b(y)exp(\eta^TT(y)-a(\eta))

p ( y ; η ) = b ( y ) e x p ( η T T ( y ) − a ( η ) )

η

\eta

η

T

(

y

)

T(y)

T ( y )

T

(

y

)

=

y

T(y)=y

T ( y ) = y

a

(

η

)

a(\eta)

a ( η )

e

−

a

(

η

)

e^{-a(\eta)}

e − a ( η )

p

(

y

;

η

)

p(y;\eta)

p ( y ; η )

伯努利分布属于指数分布族。推导过程如下,

设伯努利分布的均值为

ϕ

\phi

ϕ

p

(

y

=

1

;

ϕ

)

=

ϕ

;

p

(

y

=

0

;

ϕ

)

=

1

−

ϕ

p(y=1;\phi)=\phi;p(y=0;\phi)=1-\phi

p ( y = 1 ; ϕ ) = ϕ ; p ( y = 0 ; ϕ ) = 1 − ϕ

p

(

y

;

ϕ

)

=

ϕ

y

(

1

−

ϕ

)

1

−

y

=

e

x

p

(

y

l

o

g

ϕ

+

(

1

−

y

)

l

o

g

(

1

−

ϕ

)

)

=

e

x

p

(

y

l

o

g

(

ϕ

1

−

ϕ

)

+

l

o

g

(

1

−

ϕ

)

)

p(y;\phi)=\phi^y(1-\phi)^{1-y}=exp(ylog\phi+(1-y)log(1-\phi))=exp(ylog(\frac\phi{1-\phi})+log(1-\phi))

p ( y ; ϕ ) = ϕ y ( 1 − ϕ ) 1 − y = e x p ( y l o g ϕ + ( 1 − y ) l o g ( 1 − ϕ ) ) = e x p ( y l o g ( 1 − ϕ ϕ ) + l o g ( 1 − ϕ ) )

b

(

y

)

=

1

,

T

(

y

)

=

y

,

η

=

l

o

g

(

ϕ

1

−

ϕ

)

,

a

(

η

)

=

−

l

o

g

(

1

−

η

)

=

l

o

g

(

1

+

e

η

)

b(y)=1,T(y)=y,\eta=log(\frac \phi {1-\phi}),a(\eta)=-log(1-\eta)=log(1+e^{\eta})

b ( y ) = 1 , T ( y ) = y , η = l o g ( 1 − ϕ ϕ ) , a ( η ) = − l o g ( 1 − η ) = l o g ( 1 + e η )

高斯分布同样属于指数分布族,推导过程如下,

设方差

σ

2

=

1

\sigma^2=1

σ 2 = 1

μ

\mu

μ

p

(

y

;

μ

)

=

1

2

π

e

x

p

(

−

1

2

(

y

−

μ

)

2

)

=

1

2

π

e

x

p

(

−

1

2

y

2

)

⋅

e

x

p

(

μ

y

−

1

2

μ

2

)

p(y;\mu)=\frac1 {\sqrt{2\pi}}exp(-\frac12(y-\mu)^2)=\frac 1{\sqrt{2\pi}}exp(-\frac12y^2)\cdot exp(\mu y-\frac12\mu^2)

p ( y ; μ ) = 2 π

1 e x p ( − 2 1 ( y − μ ) 2 ) = 2 π

1 e x p ( − 2 1 y 2 ) ⋅ e x p ( μ y − 2 1 μ 2 )

η

=

μ

,

T

(

y

)

=

y

,

a

(

η

)

=

1

2

μ

2

=

1

2

η

2

,

b

(

y

)

=

1

2

π

e

x

p

(

−

1

2

y

2

)

\eta=\mu,T(y)=y,a(\eta)=\frac12\mu^2=\frac12\eta^2,b(y)=\frac1{\sqrt{2\pi}}exp(-\frac12y^2)

η = μ , T ( y ) = y , a ( η ) = 2 1 μ 2 = 2 1 η 2 , b ( y ) = 2 π

1 e x p ( − 2 1 y 2 )

另外,多项式分布,泊松分布,

γ

\gamma

γ

β

\beta

β

构建广义线性模型基于以下三个假设:

y

∣

x

;

θ

~

E

x

p

o

n

e

n

t

i

a

l

F

a

m

i

l

y

(

η

)

y|x;\theta \text{\textasciitilde}ExponentialFamily(\eta)

y ∣ x ; θ ~ E x p o n e n t i a l F a m i l y ( η )

θ

\theta

θ

y

y

y

η

\eta

η 给定

x

x

x

T

(

y

)

∣

x

T(y)|x

T ( y ) ∣ x

T

(

y

)

=

y

T(y)=y

T ( y ) = y

h

(

x

)

=

E

[

y

∣

x

]

h(x)=E[y|x]

h ( x ) = E [ y ∣ x ]

h

θ

(

x

)

=

p

(

y

=

1

∣

x

;

θ

)

=

0

⋅

p

(

y

=

0

∣

x

;

θ

)

+

1

⋅

p

(

y

=

1

∣

;

x

,

θ

)

=

E

[

y

∣

;

x

,

θ

]

h_\theta(x)=p(y=1|x;\theta)=0\cdot p(y=0|x;\theta)+1\cdot p(y=1|;x,\theta)=E[y|;x,\theta]

h θ ( x ) = p ( y = 1 ∣ x ; θ ) = 0 ⋅ p ( y = 0 ∣ x ; θ ) + 1 ⋅ p ( y = 1 ∣ ; x , θ ) = E [ y ∣ ; x , θ ]

η

=

θ

T

x

\eta=\theta^Tx

η = θ T x

对于二分类,很自然想到y服从伯努利分布,所以满足第一个假设。

第二个假设,对于伯努利分布来说,

p

(

y

=

1

∣

x

;

θ

)

=

ϕ

,

p

(

y

=

0

∣

x

;

θ

)

=

1

−

ϕ

p(y=1|x;\theta)=\phi,p(y=0|x;\theta)=1-\phi

p ( y = 1 ∣ x ; θ ) = ϕ , p ( y = 0 ∣ x ; θ ) = 1 − ϕ

h

θ

(

x

)

=

E

[

y

∣

x

;

θ

]

=

ϕ

=

1

1

+

e

−

η

h_\theta(x)= E[y|x;\theta]=\phi=\frac1{1+e^{-\eta}}

h θ ( x ) = E [ y ∣ x ; θ ] = ϕ = 1 + e − η 1

根据第三个假设,

η

=

θ

T

x

\eta=\theta^Tx

η = θ T x

ϕ

=

1

1

+

e

−

η

=

1

1

+

e

−

θ

T

x

\phi=\frac1{1+e^{-\eta}}=\frac1{1+e^{-\theta^Tx}}

ϕ = 1 + e − η 1 = 1 + e − θ T x 1

得到sigmoid函数。

问题1 逻辑回归相比于线性回归,有何异同?

首先,逻辑回归处理的是分类问题,线性回归处理的是回归问题,这是两者的最本质的区别。逻辑回归中,因变量取值是一个二元分布,模型学习得出的是

E

[

y

∣

x

;

θ

]

E[y|x;\theta ]

E [ y ∣ x ; θ ]

y

′

=

θ

T

x

y' = {\theta ^{\rm{T}}}x

y ′ = θ T x

y

=

θ

T

x

+

ε

y = {\theta ^{\rm{T}}}x + \varepsilon

y = θ T x + ε

ϵ

\epsilon

ϵ

逻辑回归与线性回归最大的区别,即逻辑回归中的因变量为离散的,而线性回归中的因变量是连续的。并且在自变量x与超参数θ确定的情况下,逻辑回归可以看作广义线性模型(Generalized Linear Models)在因变量y服从二元分布时的一个特殊情况;而使用最小二乘法求解线性回归时,我们认为因变量y服从正态分布。

当然逻辑回归和线性回归也不乏相同之处,首先我们可以认为二者都使用了极大似然估计来对训练样本进行建模。线性回归使用最小二乘法,实际上就是在自变量x与超参数

θ

θ

θ

θ

θ

θ

问题2 当使用逻辑回归处理多标签的分类问题时,有哪些常见做法,分别应用于哪些场景,它们之间又有怎样的关系?

当存在样本可能属于多个标签的情况时,我们可以训练k个二分类的逻辑回归分类器。第i个分类器用以区分每个样本是否可以归为第i类,训练该分类器时,需要把标签重新整理为“第i类标签”与“非第i类标签”两类。通过这样的办法,我们就解决了每个样本可能拥有多个标签的情况。

h

θ

(

x

)

=

[

p

(

y

=

1

∣

x

;

θ

)

p

(

y

=

2

∣

x

;

θ

)

.

.

.

p

(

y

=

k

∣

x

;

θ

)

]

=

1

∑

j

=

1

k

e

θ

j

T

x

[

e

θ

1

T

x

e

θ

2

T

x

.

.

.

e

θ

k

T

x

]

h_\theta(x)=\begin{bmatrix} p(y=1|x;\theta)\\ p(y=2|x;\theta)\\ .\\.\\.\\ p(y=k|x;\theta)\\ \end{bmatrix}=\frac1{\sum_{j=1}^ke^{\theta^T_jx}}\begin{bmatrix} e^{\theta^T_1x}\\ e^{\theta^T_2x}\\ .\\.\\.\\ e^{\theta^T_kx}\\ \end{bmatrix}

h θ ( x ) = ⎣ ⎢ ⎢ ⎢ ⎢ ⎢ ⎢ ⎡ p ( y = 1 ∣ x ; θ ) p ( y = 2 ∣ x ; θ ) . . . p ( y = k ∣ x ; θ ) ⎦ ⎥ ⎥ ⎥ ⎥ ⎥ ⎥ ⎤ = ∑ j = 1 k e θ j T x 1 ⎣ ⎢ ⎢ ⎢ ⎢ ⎢ ⎢ ⎡ e θ 1 T x e θ 2 T x . . . e θ k T x ⎦ ⎥ ⎥ ⎥ ⎥ ⎥ ⎥ ⎤