版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/u010800708/article/details/87875664

1)cache

cache是为了追求计算的速度

spark中计算任务在内存中,但是结果是存储在磁盘中的,所以首次运行会慢,之后会拿磁盘中的计算结果,所以后面会快很多

通过对结果的RDD分布式数据集进行cache,将计算结果缓存在内存中,这样会比缓存在磁盘中更快的读取。

比如计算log文件的行数

scala> val rdd1 = sc.textFile("hdfs://192.168.252.121:9000/cache/itstar.log")

rdd1: org.apache.spark.rdd.RDD[String] = hdfs://192.168.252.121:9000/cache/itstar.log MapPartitionsRDD[1] at textFile at <console>:24

scala> rdd1.count

res0: Long = 8031

首次执行会花费20多秒,第二次在3秒。

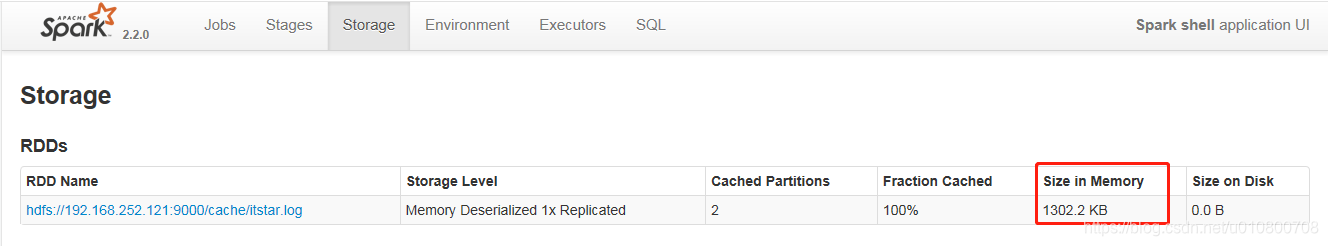

在执行cache后,花费在毫秒级

scala> val rdd1 = sc.textFile("hdfs://192.168.252.121:9000/cache/itstar.log")

scala> val rdd1cache = rdd1.cache

scala> rdd1cache.count

sc.textFile的结果都存储在内存中,所以读取非常快

2)checkpoint

checkpoint是为了保证数据计算结果的安全性

可以将计算的中间结果备份存储在hdfs的某个目录下

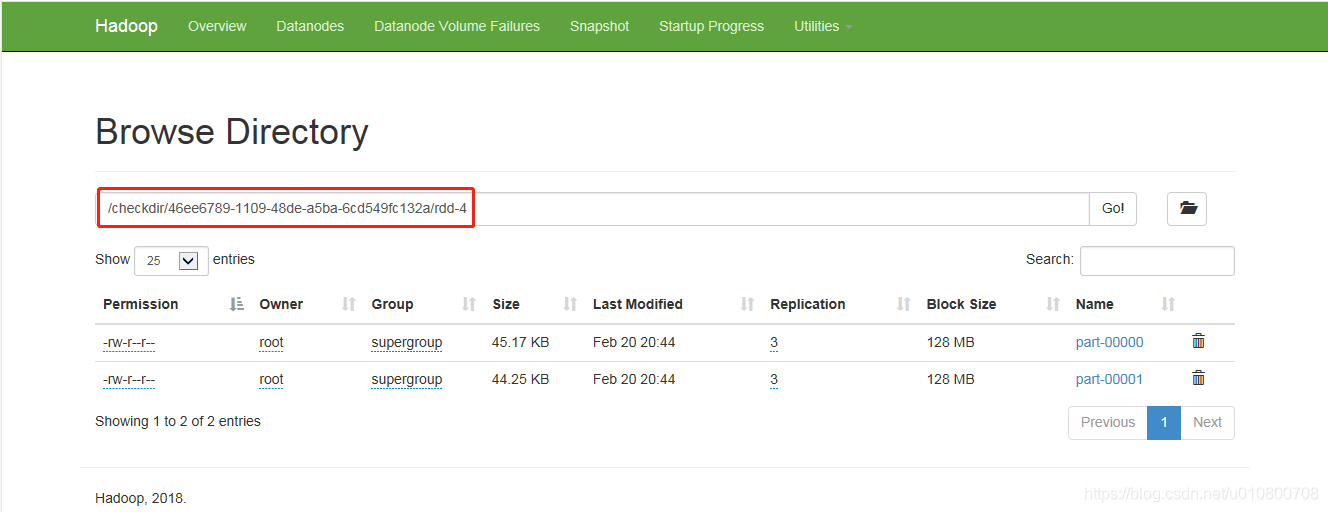

checkdir文件夹会自动创建

sc.checkpointDir("hdfs://192.168.252.121:9000/checkdir")

然后哪个rdd结果想先保存就可以调用checkpoint方法

scala> val rddc = rdd1.filter(_.contains("bigdata"))

scala> rddc.checkpoint

调用之后,那么rddc数据集的计算结果将会保存在checkdir目录中

比如调用rddc.count

rddc.count