UNSUPERVISED REPRESENTATION LEARNING WITH DEEP CONVOLUTIONAL GENERATIVE ADVERSARIAL NETWORKS

背景

前面【1】和【2】都提到这篇文章,之前也有看过,但是没有好好理一遍。今天有时间整理并且发布在博客上。

我们知道最早的GAN,并不是直接能用在深度卷积网络上。这篇paper主要在于提出一个deep convolutional generative adversarial networks(DCGANs)和一些对DCGANs相关的约束条件.当然,此时还没运用到分割【1】或者适配域【2】。

方法

文章提出三个优化GAN存在的问题或不足

第一,用strider convolutions下采样而代替pooling.个人觉得还是因为pooling向后传导不利于 GAN训练,可以看ResNet网络,越深网络越不会用pooling。

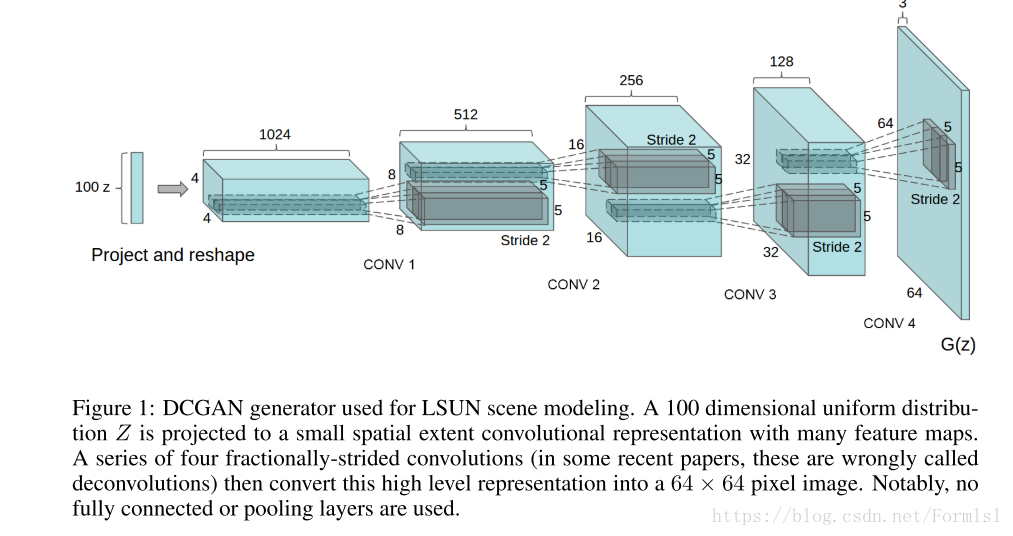

第二,移除所有全链接层。同使认为average pooling能增加网络稳定性,但是不利于收敛。下面的生成器模型图,很好的展示了这个。

第三,Batch Normalization(BN)一般的分类网络中,是有利于loss反向传播。但是在GAN加入会引起震荡和不稳定。作者认为不应该使用BN。个人认为是BN的对数据归一化造成网络训练中输入和输出数值相差不大,而一般生成图像的值域和归一化的域不在同一尺度上,从而会存在动荡。 ReLU效果没有Leaky rectified activation 效果好,个人认为主要原因还是ReLU直接丢弃非正部分,但是在网络训练过程如果没有非正部分,网络可能偏移第一象限,实际上难以需要更多的训练时间。

结果

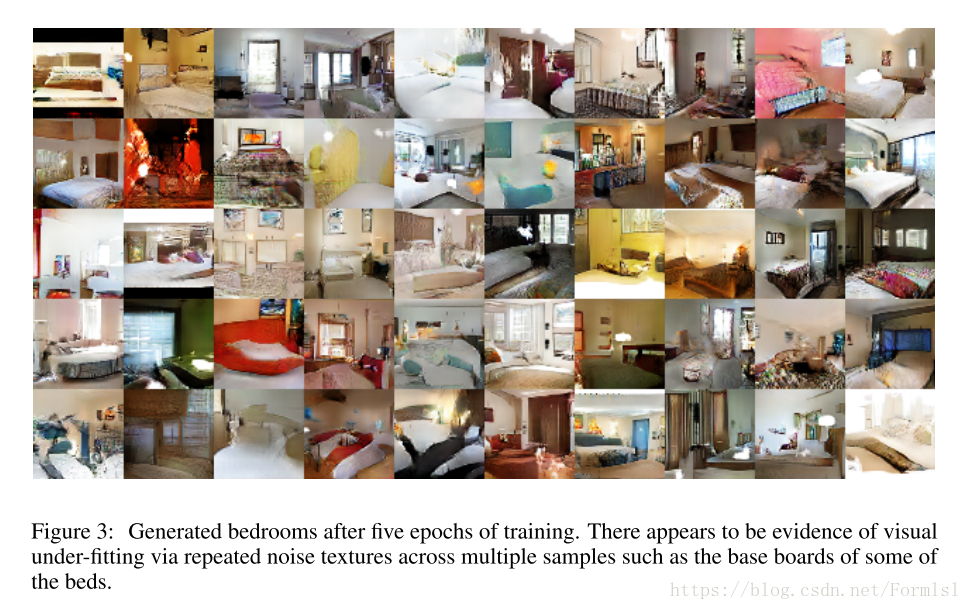

5个epoch效果,真是难以想象!!!

引用

【1】arXiv:1802.07934v2 [cs.CV] 24 Jul 2018.Adversarial Learning for Semi-Supervised Semantic Segmentation

【2】Learning to Adapt Structured Output Space for Semantic Segmentation