·scrapy框架

一、engine模块

1、控制所有模块的数据流

2、根据条件触发事件

3、不需要用户修改

二、download

1、根据请求下载模块

2、不需要用户修改

三、scheduler

1、对所有请求进行调度管理

2、不需要用户修改

四、spider

1、解析download返回的response(响应)

2、产生爬取scraped item(爬取项)

3、产生额外的requests(爬取请求)

五、item pieplines

1、以流水线方式处理spider产生的爬取项。

2、由一组操作顺序组成,类似流水线,每个操作是一个Item pipeline.

3、可能操作包括:清理、检验和查重爬取项中的HTML数据、将数据存储到数据库。

·requests 与 scrapy的比较

相同点:

不同点

选用哪个技术路线(requests or scrapy)来实现爬虫

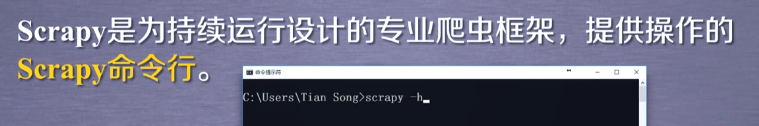

·scrapy的常用命令

一、scrapy命令行

二、格式:

>scrapy<command>[options][args]

//command就是scrapy命令

三、scrapy常用命令

四、scrapy爬取的命令行逻辑