搭建好HDFS HA集群后,我们来配置客户端,用来操作HDFS HA集群

首先我们选择一台客户机,任意选择,只要能与集群通信即可,这里就使用真机

-

将集群中配置好的 hadoop 安装包拷贝到真机上

-

配置 hadoop 的环境变量和参数

HADOOP_HOME:hadoop安装包的位置

PATH:%HADOOP_HOME%\bin

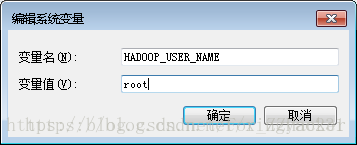

HADOOP_USER_NAME:登录集群的用户名称,只要是可以登录集群的用户名就可以,这里配置为root

(这也是防君子的错误操作,不妨小人的破坏操作的地方,只要名字相同就有权限)

-

将hadoop的插件放到eclipse的dropins\plugins\ 目录下,如果没有 plugins目录则手动创建。插件可到github下载对应版本。

注意插件版本应该与你的hadoop按照包对应一下

Github地址:https://github.com/winghc/hadoop2x-eclipse-plugin -

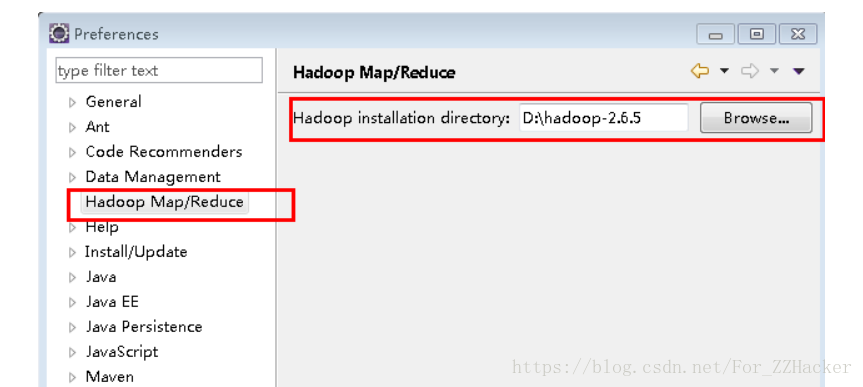

启动eclipse,点击菜单栏的window–>Preferences 进入Preferences选项窗口,此时会有一个Hadoop Map/Reduce,点击如下图,选择hadoop安装包的位置,点击Apply–>OK

这些配置会防止一些错误。

-

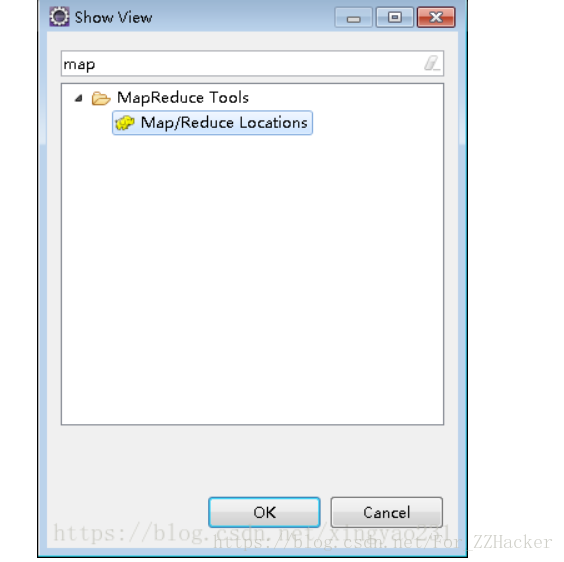

点击菜单栏的window–>Show View–>other进入Show View 窗口如下。在搜索栏输入Map/Reduce,选中黄色小象Map/Reduce Location,点击OK

-

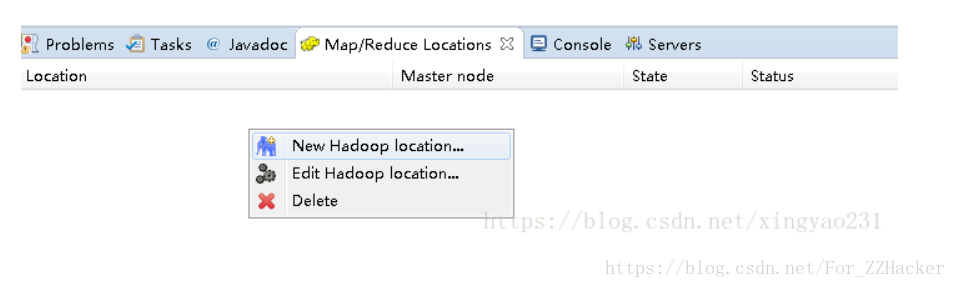

此时下方控制台窗口便会出现Map/Reduce Location的窗口,在空白处右击,选择 New Hadoop location

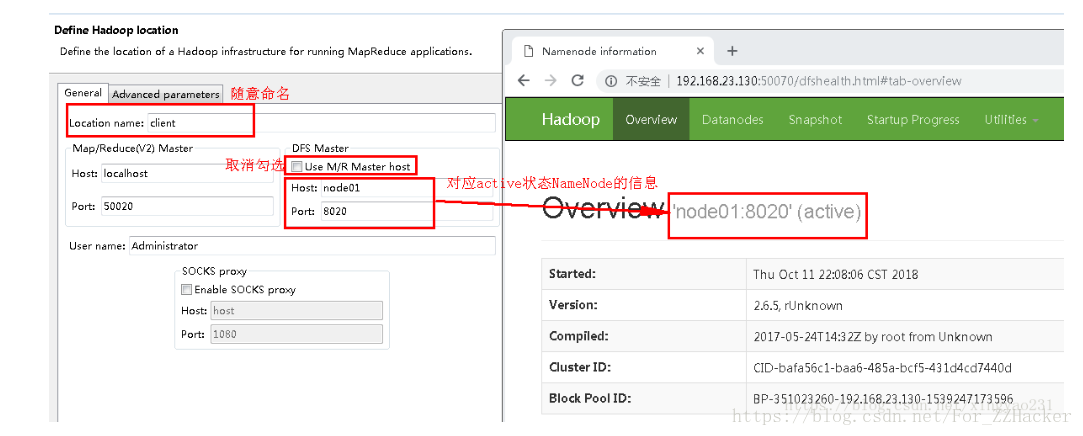

按下图进行配置,点击finish

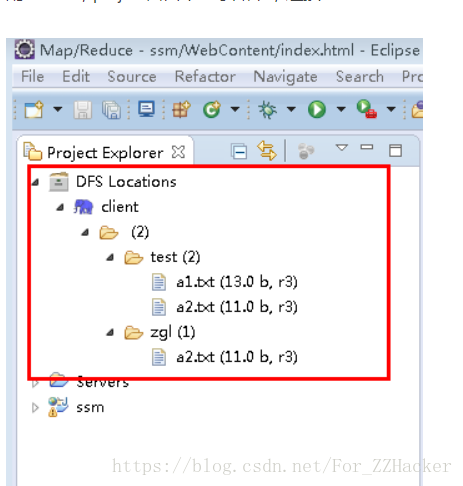

配置完成,project窗口中显示如下,连接成功

这里注意一下,你的查看方式不能是SET大包的查看方式,否则也是不显示的,只有普通的时候才会显示

-

如果要在项目中操作HDFS集群,则需要导入依赖jar包。

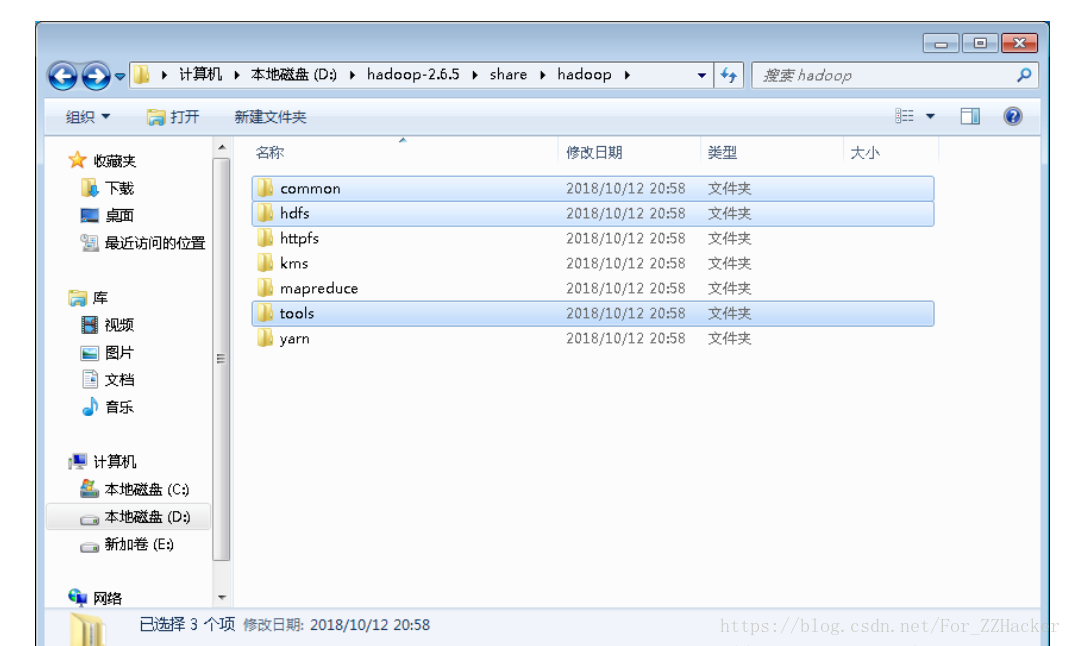

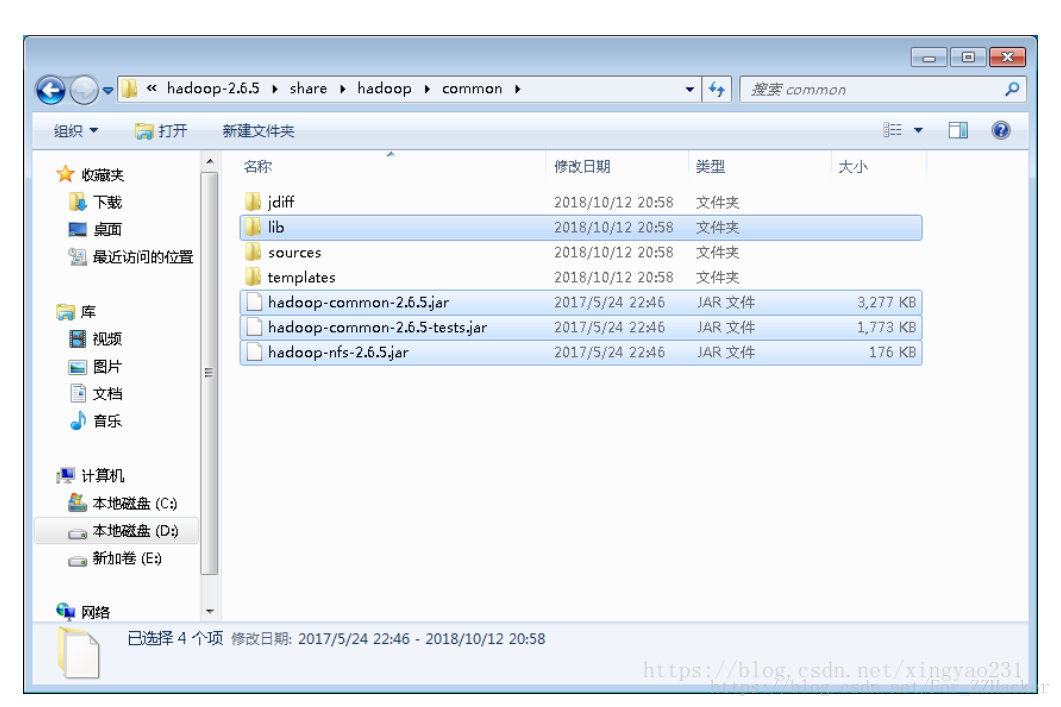

将hadoop安装包中share\hadoop目录下 common,hdfs,tools三个文件夹中的jar包及其下lib文件夹中的jar包整合并导入项目。

将加入的jar包加入bin目录中,通过build path(如果是web工程文件夹不需要,因为自动就导进去了)。然后就可以在项目中操作HDFS集群了

注意有的包可能会冲突,导致tomcat启动失败,所以需要注意这些包导入的时候,这些包可以精简的!去掉重复的!

参考文章:https://blog.csdn.net/xingyao231/article/details/83036915