一:Spark SQL的简介

Spark SQL是Spark处理数据的一个模块,跟基本的Spark RDD的API不同,Spark SQL中提供的接口将会提供给Spark更多关于结构化数据和计算的信息。其本质是,Spark SQL使用这些额外的信息去执行额外的优化,这儿有几种和Spark SQL进行交互的方法,包括SQL和Dataset API,当使用相同的执行引擎时,API或其它语言对于计算的表达都是相互独立的,这种统一意味着开发人员可以轻松地在不同的API之间进行切换。

二:Spark SQL的作用

Spark SQL的一大用处就是执行SQL查询语句,Spark SQL也可以用来从Hive中读取数据,当我们使用其它编程语言来运行一个SQL语句,结果返回的是一个Dataset或者DataFrame.你可以使用命令行,JDBC或者ODBC的方式来与SQL进行交互

三:Spark SQL的特点

官网上第一句话:**Spark SQL is Apache Spark’s module for working with structured data. **

Spark SQL是Apache Spark处理结构化数据的模块

官网地址:https://spark.apache.org/sql/

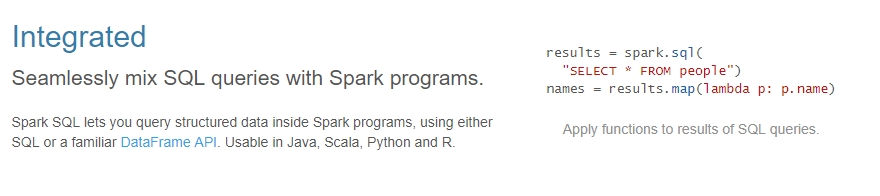

集成

无缝地将SQL查询与Spark程序混合。

Spark SQL允许您使用SQL或熟悉的DataFrame API在Spark程序中查询结构化数据。适用于Java、Scala、Python和R语言。

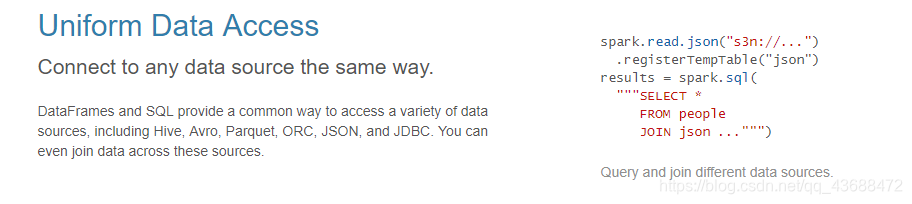

统一的数据访问

以相同的方式连接到任何数据源。

DataFrames和SQL提供了一种访问各种数据源的通用方法,包括Hive、Avro、Parquet、ORC、JSON和JDBC。您甚至可以通过这些源连接数据。

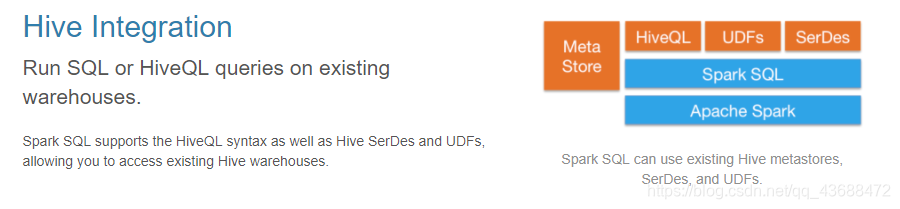

蜂巢集成

在现有仓库上运行SQL或HiveQL查询。

Spark SQL支持HiveQL语法以及Hive SerDes和udf,允许您访问现有的Hive仓库。

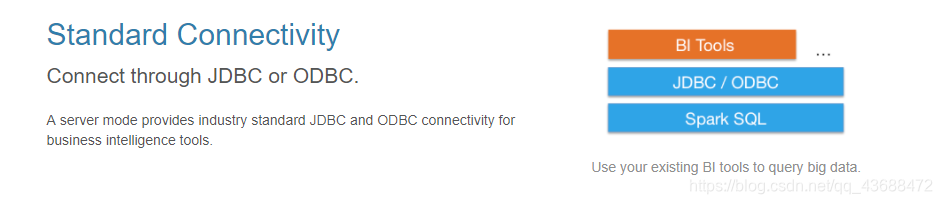

标准的连接

通过JDBC或ODBC连接。

服务器模式为业务智能工具提供了行业标准JDBC和ODBC连接。

四:总结

查询结构化数据

适用于各种语言

以相同的方式连接到任何数据源。

访问现有的Hive仓库

标准的连接