Linux下Hadoop源码的编译

1.前期准备

1.1CentOS联网

1.2采用root角色编译,减少文件夹权限出现问题

1.3jar包准备(hadoop源码、JDK8、maven、ant 、protobuf)

(1)hadoop-2.7.2-src.tar.gz

(2)jdk-8u144-linux-x64.tar.gz

(3)apache-ant-1.9.9-bin.tar.gz(build工具,打包用的)

(4)apache-maven-3.0.5-bin.tar.gz

(5)protobuf-2.5.0.tar.gz(序列化的框架)

在这里我要推荐下我自己建的大数据学习交流扣扣裙: 961523330, 裙 里有博主的jar包下载。

1.4linux工具安装

查看:https://blog.csdn.net/qq_39657909/article/details/84975864

2.编译源码

1.解压源码到/opt/目录:[root@hadoop101 software]# tar -zxvf hadoop-2.7.2-src.tar.gz -C /opt/

2.进入到hadoop源码主目录:[root@hadoop101 hadoop-2.7.2-src]# pwd

3.通过maven执行编译命令:[root@hadoop101 hadoop-2.7.2-src]#mvn package -Pdist,native -DskipTests -Dtar

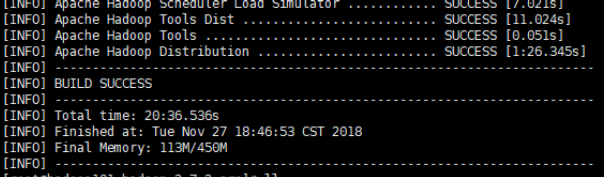

等待时间30分钟左右,最终成功是全部SUCCESS,成功截图如下:

3.编译后源码所在目录/opt/hadoop-2.7.2-src/hadoop-dist/target

(这可能是博主贴代码贴的最细致的一篇了!!!NG)

版权声明:本博客为记录本人自学感悟,转载需注明出处!

https://me.csdn.net/qq_39657909