1.在各个节点创建Hadoop账号

systemctl stop firewalld

useradd hadoop

passwd hadoop

chmod +w /etc/sudoers

vi /etc/sudoers

hadoop ALL=(root)NOPASSWD:ALL

chmod -w /etc/sudoers

chmod 777 /etc/hosts

3.配置hosts系统文件(需要在hadoop账号下配置)

su hadoop

vi /etc/hosts

192.168.1.1 dn1

192.168.1.2 dn2

192.168.1.3 dn3

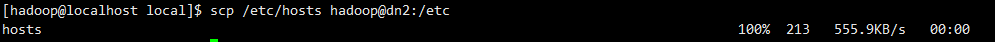

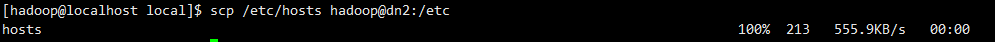

scp /etc/hosts hadoop@dn2:/etc

scp /etc/hosts hadoop@dn3:/etc

sudo shutdown -r now

4.安装SSH

ssh-keygen -t rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 700 /home/hadoop

chmod 600 ~/.ssh/authorized_keys

ssh-copy-id -i ~/.ssh/id_rsa.pub hadoop@dn1

scp ~/.ssh/authorized_keys hadoop@dn2:~/.ssh/

scp ~/.ssh/authorized_keys hadoop@dn3:~/.ssh/

ssh dn2

sudo chown -R hadoop zookeeper-3.4.14/

./zkServer.sh start