1. SVM简介

逻辑回归函数的不足:泛化能力不够强。通过最小化损失函数找到一个决策边界,通过决策边界来进行分类。没有考虑到位置数据的情况。

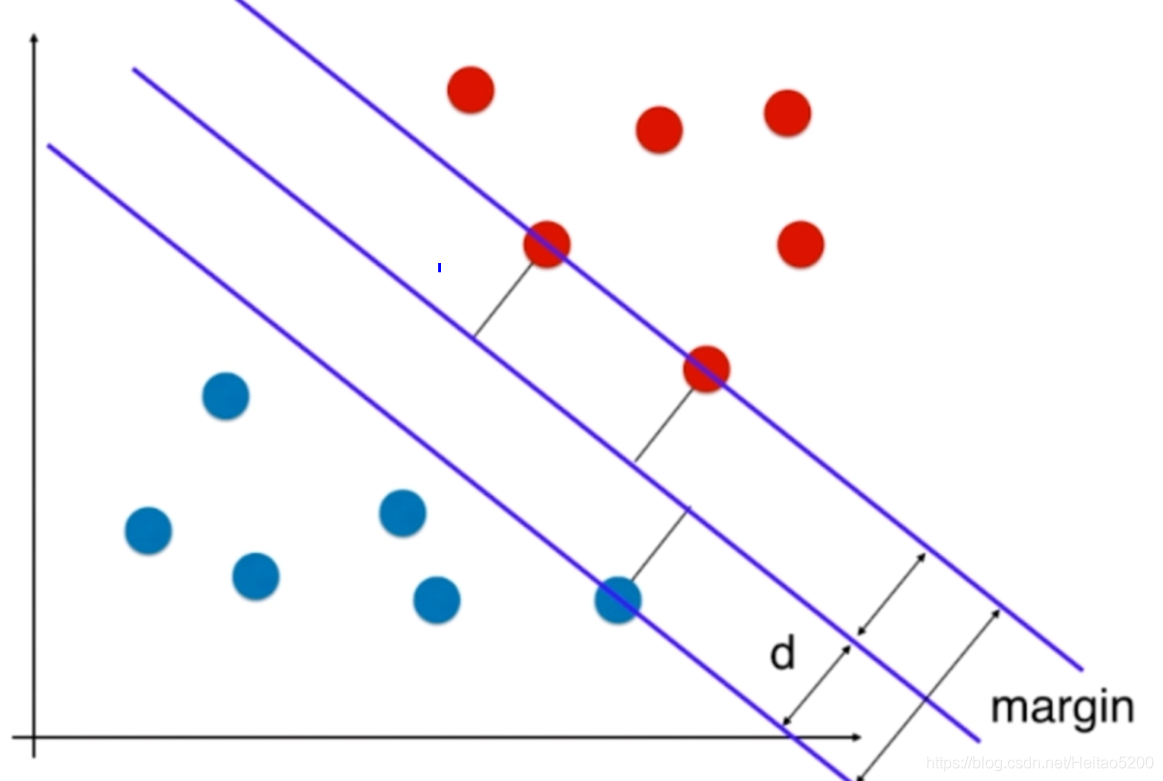

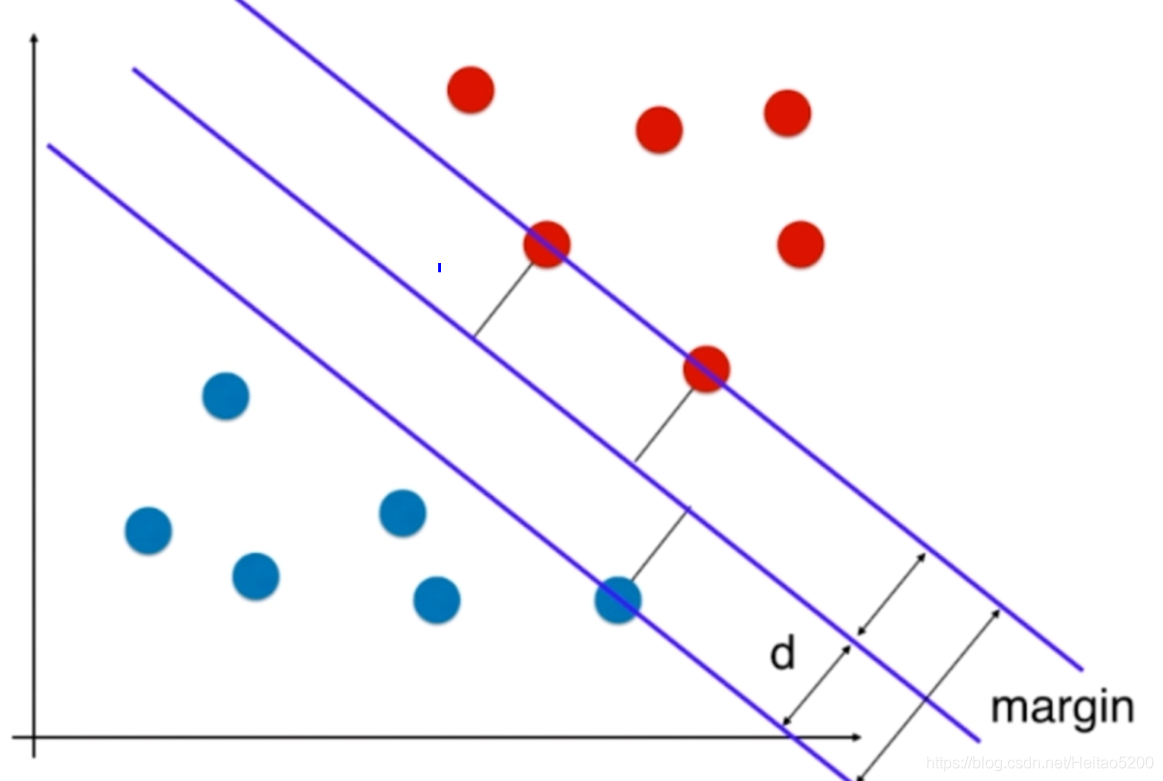

SVM算法也是找到决策边界, 但是SVM让这条决策边界离两边的数据尽可能的远(即SVM要最大化margin),这样不仅对数据进行了一个很好的划分,而且还考虑了未来的泛化能力。

SVM是一个二元分类算法,线性分类和非线性分类都支持。经过演进,现在也可以支持多元分类,同时经过扩展,也能应用于回归问题。

2. SVM的一些概念

2.1 函数间隔与几何间隔

超平面的函数表达式为

wTx+b=0时:

函数间隔:

d′=y(wTx+b)

几何间隔:

d=∣∣w∣∣y(wTx+b)=∣∣w∣∣d′

几何间隔才是点到超平面的真正距离,SVM模型里用到的距离就是几何距离。

2.2 支持向量

两个类别的数据点都尽可能的远实际上是这两个类别离决策边界最近的这些点离决策边界也尽肯能的远。其中,最近的这些点被称为支持向量点。

支持向量到超平面的距离为

∣∣w∣∣1两个支持向量之间的距离为

∣∣w∣∣2。

3. SVM模型目标函数与优化

3.1 SVM模型目标函数的推导(线性可分)

对于二维平面上的数据

最大化margin → 最大化d

在二维平面d怎么求?(点到直线的距离公式)

(x,y)到

Ax+By+C=0的距离用以下公式表示

d=A2+B2

∣Ax+By+C∣

拓展到n维空间有:

θTxb=0→

wTx+b=0

-

θT里有n+1个元素,

θ1,⋯θn对应

x1,⋯xn,还有一个

θ0为截距

-

xb里有n+1个元素,

x1,⋯xn,其中,

x0=1

-

wT里有n个元素,

w1,⋯wn对应

x1,⋯xn

- b为截距

在n维空间 d怎么求?

d=∣∣w∣∣∣wTx+b∣

∣∣w∣∣=w12+w22+⋯+wn2

{∣∣w∣∣wTxi+b⩾d∣∣w∣∣wTxi+b⩽−d∀yi=1∀yi=−1⟹{wdTxi+bd⩾1wdTxi+bd⩽−1∀yi=1∀yi=−1

其中

{wdT=∣∣w∣∣dwTbd=∣∣w∣∣db

对于决策边界的直线方程:

wTx+b=0⟹wdTx+bd=0

重命名!!! 令

{wdT=wTbd=b⟹{wTxi+b⩾1wTxi+b⩽−1∀yi=1∀yi=−1

可以将其合并

yi(wTxi+b)⩾1

对于任意支撑向量x,求最大距离d,实际上就是求

max∣∣w∣∣x∣wTx+b∣⟹max∣∣w∣∣1⟹min∣∣w∣∣

但是通常所求的目标函数是:

min21∣∣w∣∣2

限定条件是:

s.tyi(wTxi+b)⩾1⟹1−yi(wTxi+b)⩽0

3.2 目标函数的优化

我们可以通过拉格朗日乘子法将有约束条件的目标函数转化为无约束的优化函数,优化函数转化为:

L(b,w,α)=21wTw+i=1∑mαi[1−yi(wTxii+b)]αi⩾0【这一步具体是怎么转化的???】

⟹深入理解拉格朗日乘子法(Lagrange Multiplier) 和KKT条件

最终优化后的目标函数变为:

引入拉格朗日乘子,目标函数变为:

w,b

minαi⩾0

maxL(b,w,α)

由于这个目标函数满足KKT条件,因此,可以通过拉格朗日对偶将我们的优化问题转化为等价的对偶问题。

KKT条件:

⎩⎪⎪⎪⎨⎪⎪⎪⎧yi(wTxi+b)⩾1αi⩾0αi(1−yi(wTxi+b))=0∑αiyi=0,w=∑αiyixi

有

w,b

minαi⩾0

maxL(b,w,α)⟹αi⩾0

maxw,b

minL(b,w,α)

可以先求优化函数对于w和b的极小值。接着再求拉格朗日乘子α的极大值。

(1)对w和b分别求偏导数

∂w∂L=0⟹w=i=1∑mαiyixi(1)

∂b∂L=0⟹i=1∑mαiyi=0(2)

(2)将(1)式带入L(b,w,α)

得

Ψ(α)=w,b

minL(b,w,α)

Ψ(α)=21wTw+i=1∑mαi[1−yi(wTxi+b)]=21wTw+i=1∑mαi−i=1∑mαiyiwTxi−i=1∑mαiyib=21wTi=1∑mαiyixi−wTi=1∑mαiyixi+i=1∑mαi−i=1∑mαiyib=−21wTi=1∑mαiyixi+i=1∑mαi−i=1∑mαiyib=−21wTi=1∑mαiyixi+i=1∑mαi−bi=1∑mαiyi=−21(i=1∑mαiyixi)T(i=1∑mαiyixi)+i=1∑mαi−bi=1∑mαiyi=−21i=1∑mαiyi(xi)Ti=1∑mαiyixi+i=1∑mαi−bi=1∑mαiyi⟹其中i=1∑mαiyi=0=−21i=1∑mαiyi(xi)Ti=1∑mαiyixi+i=1∑mαi=i=1∑mαi−21i=1∑mj=1∑mαiαjyiyj(xi)Txj

求出

L(a,w,α)的极小值

Ψ(α)之后 ,

Ψ(α)中只有

α为未知参数,只要能够极大化

Ψ(α),就可以求出

αi⟹w,b 【why???】

maxΨ(α)=maxi=1∑mαi−21i=1∑mj=1∑mαiαjyiyj(xi)Txj=min21i=1∑mj=1∑mαiαjyiyj(xi)Txj−i=1∑mαi

限定条件:

s.ti=1∑mαiyi=0ai⩾0i为样本号

怎么求极小值

Ψ(α)???

⟹SMO算法

3.3 SVM软间隔(线性不可分)

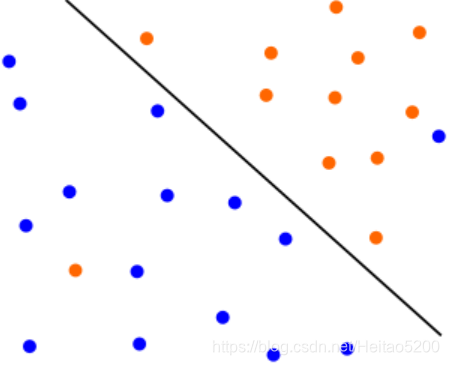

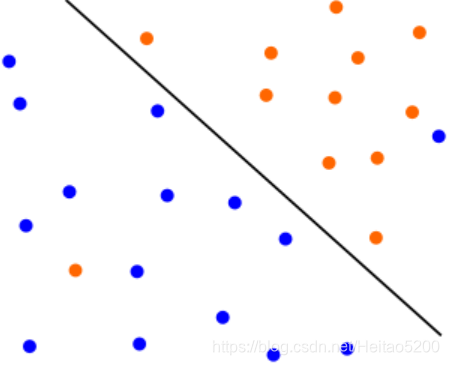

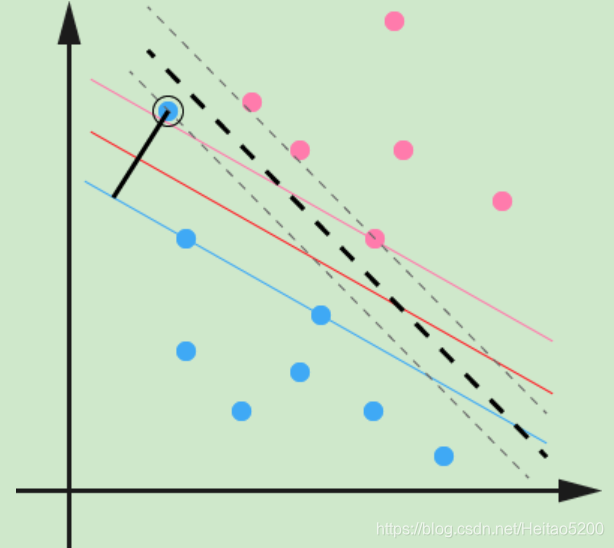

对于数据集的分布通常有线性可分和线性不可分两种情况,下面是线性不可分的情形。

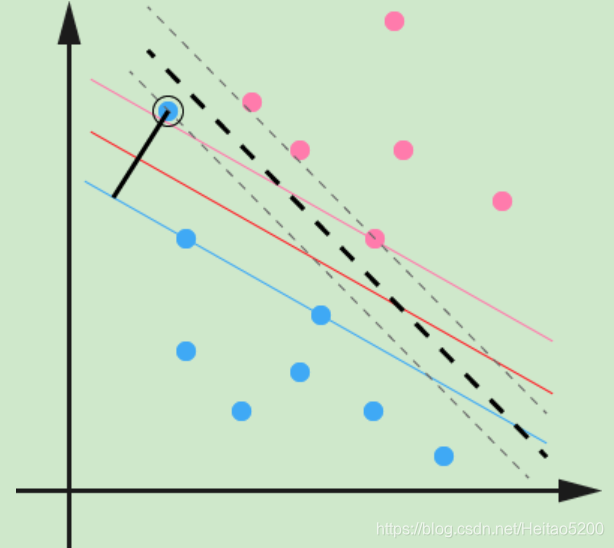

下面一种是线性可分的,但是由于有一个蓝色的异常点,导致我们学习到的超平面是下图中的粗虚线所示,这样会严重影响我们的分类模型预测效果。

以上两种情形严重影响了模型的泛化能力,因此,我们引入了软间隔最大化的方法来解决。

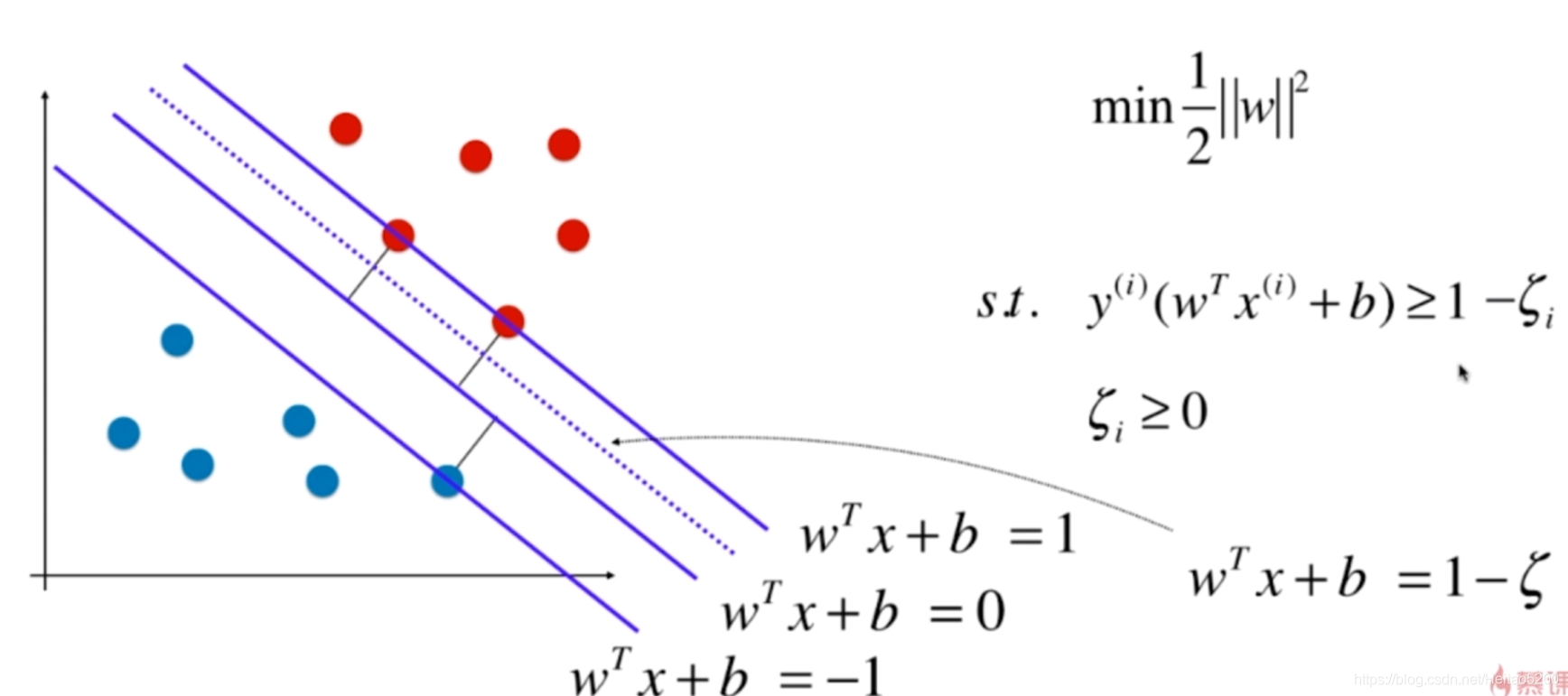

3.3 Soft Margin SVM(SVM的软间隔) 最大化

软间隔是相对于硬间隔来说的,目标函数的推导和优化的方法就是属于硬间隔最大化。

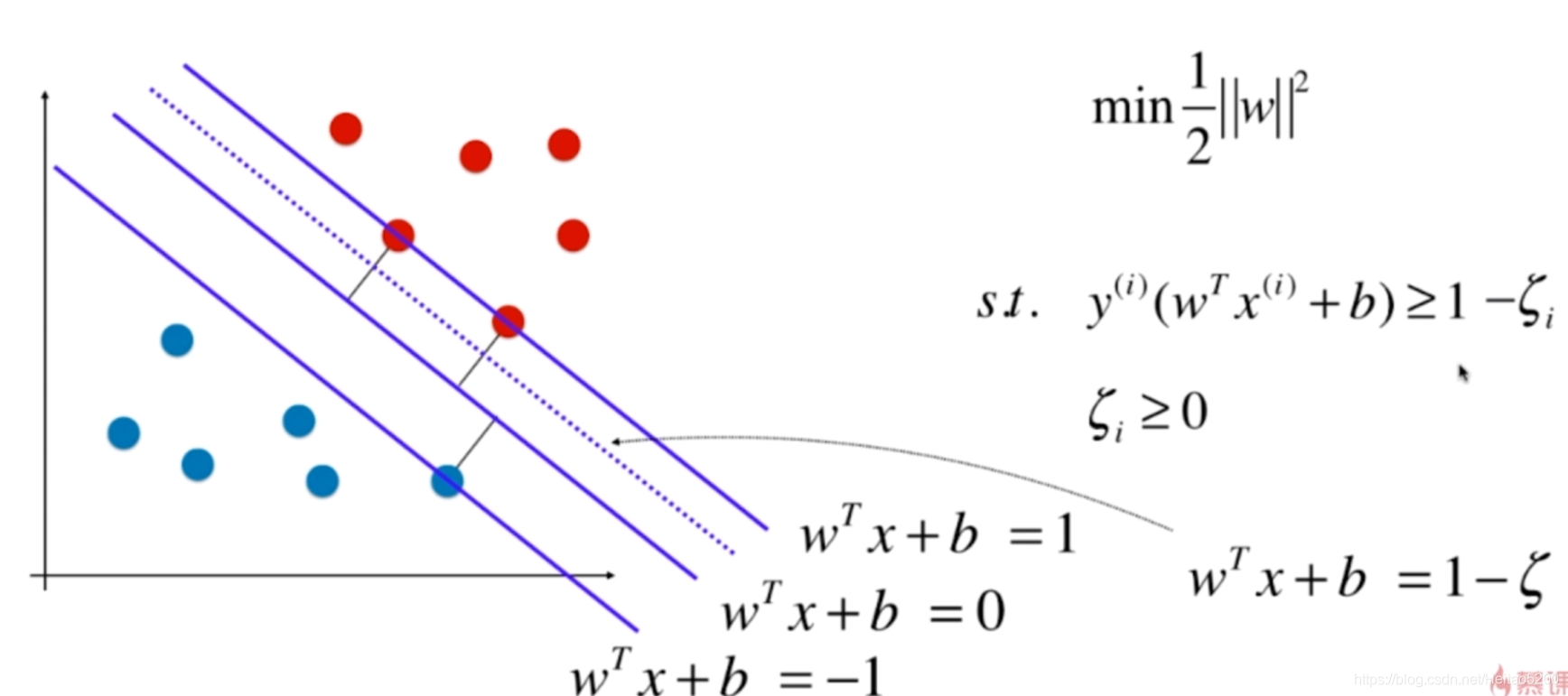

如何实现软间隔?使用松弛变量!!!

在训练集得每个样本引入一个松弛变量

ζi⩾0,使得

yi(wTxi+b)+ζi⩾1

对比硬间隔最大化,可以看到我们对样本到超平面的函数距离的要求放松了,允许有一些点在直线与虚线之间,之前是一定要大于等于1,现在只需要加上一个大于等于0的松弛变量能大于等于1就可以了。当然,松弛变量不能白加,这是有成本的,每一个松弛变量ξi, 对应了一个代价

ζi,最终,最小化的目标函数为:

min[21∣∣w∣∣2+Ci=1∑mζi]

s.t.yi(wTxi+b)⩾1−ζi

C>0为惩罚参数,可以理解为我们一般回归和分类问题正则化时候的参数。

C越大,对误分类的惩罚越大,

C越小,对误分类的惩罚越小。

C是协调两者关系的正则化惩罚系数。在实际应用中,需要调参来选择。

3.4 SVM软间隔最大化目标函数的优化

SVM软间隔最大化目标函数的优化和线性可分SVM的优化方式类似:

(1)我们首先将软间隔最大化的约束问题用拉格朗日函数转化为无约束问题如下:

L(b,w,α,ζ,μ)=21wTw+Ci=1∑mζi+i=1∑mαi[1−yi(wTxii+b)+ζi]−i=1∑mμiζiαi⩾0

其中

μi⩾0,αi⩾0均为拉格朗日系数!!!

要优化的目标函数是:(优化目标函数也满足KKT条件,因此,可以通过拉格朗日对于、偶将优化问题转化为等价的对偶问题)

w,b,ζi

minαi⩾0,μi⩾0

maxL(b,w,α,ζ,μ)⟹αi⩾0,μi⩾0

maxw,b,ζi

minL(b,w,α,ζ,μ)

先求优化函数对于

w,b,ζ的极小值, 接着再求拉格朗日乘子

α和

μ的极大值。

优化函数对于w,b,ξ的极小值,求偏导:

∂w∂L=0⟹w=i=1∑mαiyixi(1)

∂b∂L=0⟹i=1∑mαiyi=0(2)

∂ζ∂L=0⟹C−αi−μi=0(3)

消去

w和

b

L(w,b,ζ,α,μ)=i=1∑mαi−21i=1,j=1∑mαiαjyiyj(xi)Txj

现在目标函数的表达形式:

α

maxi=1∑mαi−21i=1,j=1∑mαiαjyiyj(xi)Txj⟹α

min21i=1,j=1∑mαiαjyiyj(xi)Txj−i=1∑mαi

s.ti=1∑mαiyi=0

0⩽αi⩽C

依然通过SMO算法来求上式极小化时对应的

α向量然后求出

w和

b。

3.5 软间隔最大化时的支持向量

软间隔中,对于每一个样本

(xi,yi)都引入了一个松弛变量

ζi第i个点到对应类别支持向量的距离为

2∣∣w∣∣ζi,根据软间隔最大化时KKY条件中的对偶互补条件

(αi)∗(yi(wTxi+b)−1+ζi)=0

- 如果

α=0,那么

yi(wTxi+b)−1⩾0 ,即样本已经被正确分类。

- 如果

0<α<C,那么

ζi=0,

yi(wTxi+b)−1=0,即样本在间隔边界上面。

- 如果

α=C,说明这个点是一个异常点,此时要检查

ζi

3.6 最终超平面

找出所有的支持向量

(xs,ys),

(0<αs<C)

通过

ys(∑i=1Sαiyi(xi)Txs+b)=1,计算出每个支持向量

(xs,ys)对应的

(bs)∗=ys−∑i=1Sαiyi(xi)Txs,所有的

(bs)∗对应的平均值即为最终的

(bs)∗=S1∑i=1S(bs)∗

这样最终的分类超平面为:

w∗x+b∗=0

最终的分类决策函数为:

f(x)=sign(w∗x+b∗)