给十月画个句号

最近上的很喜欢的一门课中,老师要求我们研读一篇顶会论文并进行分享,好久没能静静地坐下来写一篇博客了,接下来希望自己能够多读论文的同时把论文的思路以博客的形式输出~

论文来源

“Liar, Liar Pants on Fire”:A New Benchmark Dataset for Fake News Detection收录于ACL2017的短论文中,是加州大学-圣塔芭芭拉(University of California, Santa Barbara)的王威廉教授的作品【PS:这位老师的主要研究方向是机器学习,自然语言处理和人工智能,刚兴趣的可以看看他的个人主页哦:http://www.cs.ucsb.edu/~william/】

论文介绍

论文为虚假新闻检测领域提供了一个公开的基准数据集,个人觉得是很有价值的,数据作为基础,任何研究都离不开。所以本文提供的数据集对虚假新闻检测领域研究可以起到一个推动的作用,让基于统计和计算的方法能够发展起来,也能够应用在相关领域像谣言检测,主题模型构建等。

虚假新闻检测

刚好研读了SIGKDD数据挖掘顶会在2017年收录的一篇虚假新闻检测的论文(Fake News Detection on Social Media: A data mining perspectative),里面对该领域的阐述十分清晰,接下来从研究背景,研究难点,研究的方向较为系统地进行回顾。

一.研究背景

虚假新闻检测其实不是一个新领域,在2009的时候就有研究者开始了这方面的研究,而在近几年研究主要集中在社交媒体平台上,尤其是国外的平台如脸书和推特,其中的原因主要是社交媒体不同于传统媒体(像电视或者报纸),它的新闻制作成本低,时效性高同时易于分享传播。

二.研究难点

因为虚假新闻检测不同于传统的文本分类,仅从文本内容较难判断其真实性,在文章主题,写作风格这些特征上难以进行区别,同时虚假新闻中可能掺杂着真实的内容,导致文本特征不足。另外在社交媒体上的较多是短文本,就给研究带来更大的难度。同时,缺乏有效的标注数据导致这个领域存在瓶颈期。

三.研究方向

在这个领域上研究者主要是从以下四个方向去努力:

论文提供数据集LIAR

一.介绍

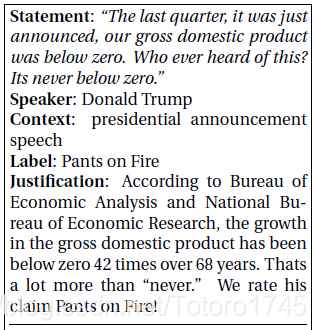

它是一个全新的公开数据集,由人工收集politifact网站上的从07-16年长达十年的不同语境的12800条数据,跟同个类型的数据集相比大了一个数量集。这是单条的数据,是特朗普的发言,我们可以看到数据中包含了文本内容,陈述人,语境,标签,以及评判的内容。

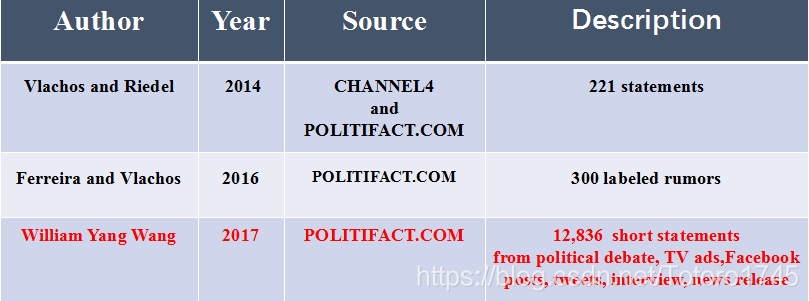

二.同类型数据集对比

可以看到14和16年的两个数据集的数量均少于1000,很难将这些数据作为基准去评判和改进模型,而LIAR数据集除了数量大,也涵盖了不同的语境类别,更加充实。

实验过程

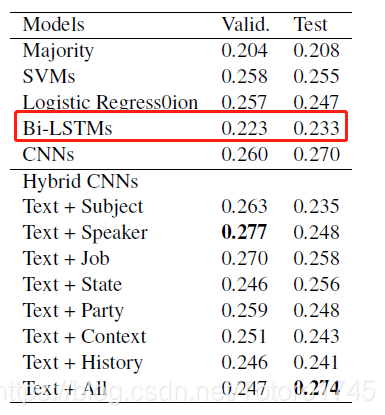

在本文中,作者也在这个数据集上进行实验,所选用的baseline方法如下:

- Majority

- SVMs (LibShortText + Grid Serach)

- Logistic Regression (LibShortText + Grid Serach)

- Bi-LSTMs (TensorFlow + Word2vec)

- CNNs (TensorFlow + Word2vec)

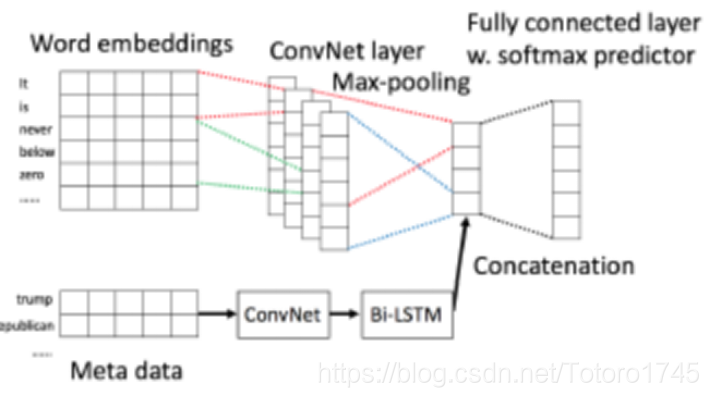

然后作者也尝试文本+元数据作为输入,主要是这个模型,对于文本是使用CNN模型,而元数据的向量表示是随机初始化生成,跟文本一样经过一层卷积层和池化层再进入一层双向的LSTM,然后对两者的向量进行合并,进入到一个全连接层得到最终的预测结果。

实验结果

在最终的实验结果中,CNN模型是表现最好的(确实CNN在文本分类上很突出),而bi-LSTM由于过拟合表现较差,同时元数据和文本的结合模型得到的结果最好。

参考论文

- “Liar, Liar Pants on Fire”:A New Benchmark Dataset for Fake News Detection

- Fake News Detection on Social Media: A data mining perspectative