简单总结一下自己对SVM的认识:有一条带区域,固定差距为1,希望最大化间隔 。SVM的特点就是这条带的引入。

SVR同样有这样的一条带,回归的时候,落入带内的点,损失为0,只记录落入带外的点的损失值。

SVR形式化表示:

其中第一项是正则化项,后面的损失函数是

-不敏感损失:

,l = 0

, l =

引入松弛变量,可以重写为:

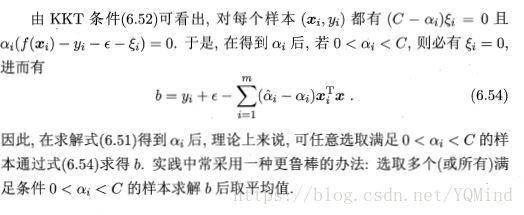

引入拉格朗日乘子,得到原问题的对偶问题:

满足的KKT条件:

其中, 的样本为支持向量,它们必然落在间隔带之外, 落在间隔带内的样本 。SVR的支持向量仅是训练样本的一部分,即其解仍具有稀疏性。