一、高可用web框架

- 1.1nginx

- 1.1.1nginx简介

Nginx是一个自由、开源、高性能及轻量级的HTTP服务器及反转代理服务器。Nginx以其高性能、稳定、功能丰富、配置简单及占用系统资源少而著称。

Nginx 超越 Apache 的高性能和稳定性,使得国内使用 Nginx 作为 Web 服务器的网站也越来越多.

- 1.1.2基础功能

反向代理加速,简单的负载均衡和容错;

- 1.1.3优势

1、Nginx专为性能优化而开发,性能是其最重要的考量, 实现上非常注重效率 。有报告表明能支持高达 50,000 个并发连接数。

2、Nginx具有很高的稳定性。其它HTTP服务器,当遇到访问的峰值,或者有人恶意发起慢速连接时,也很可能会导致服务器物理内存耗尽频繁交换,失去响应,只能重启服务器。

例如当前apache一旦上到200个以上进程,web响应速度就明显非常缓慢了。而Nginx采取了分阶段资源分配技术,使得它的CPU与内存占用率非常低。

3、nginx官方表示保持10,000个没有活动的连接,它只占2.5M内存,就稳定性而言, nginx比其他代理服务器更胜一筹。

4、Nginx支持热部署。它的启动特别容易, 并且几乎可以做到7*24不间断运行,即使运行数个月也不需要重新启动。你还能够在不间断服务的情况下,对软件版本进行进行升级。

5、Nginx采用C进行编写, 不论是系统资源开销还是CPU使用效率都高很多。

- 1.1.4安装

见下文

- 1.2keepalived

- 1.2.1简介

Keepalived的作用是检测web服务器的状态,如果有一台web服务器死机,或工作出现故障,Keepalived将检测到,并将有故障的web服务器从系统中剔除,当web服务器工作正常后Keepalived自动将web服务器加入到服务器群中,这些工作全部自动完成,不需要人工干涉,需要人工做的只是修复故障的web服务器。

主要用作RealServer的健康状态检查以及LoadBalance主机和BackUP主机之间failover的实现。

- 1.3lvs

- 1.3.1LVS是什么

1)LVS的英文全称是Linux Virtual Server,即Linux虚拟服务器。

2)它是我们国家的章文嵩博士的一个开源项目。

- 1.3.2LVS能干什么

- LVS主要用于多服务器的负载均衡。

- 它工作在网络层,可以实现高性能,高可用的服务器集群技术。

- 它可把许多低性能的服务器组合在一起形成一个超级服务器。

- 它配置非常简单,且有多种负载均衡的方法。

- 它稳定可靠,即使在集群的服务器中某台服务器无法正常工作,也不影响整体效果。

- 可扩展性也非常好。

- 1.3.3nginx和lvs作对比的结果:

1、nginx工作在网络的应用层,主要做反向代理;lvs工作在网络层,主要做负载均衡。nginx也同样能承受很高负载且稳定,但负载度和稳定度不及lvs。

2、nginx对网络的依赖较小,lvs就比较依赖于网络环境。

3、在使用上,一般最前端所采取的策略应是lvs。 nginx可作为lvs节点机器使用。

- 1.3.4负载均衡机制

前面我们说了LVS是工作在网络层。相对于其它负载均衡的解决办法,它的效率是非常高的。LVS的通过控制IP来实现负载均衡。IPVS是其具体的实现模块。IPVS的主要作用:安装在Director Server上面,在Director Server虚拟一个对外访问的IP(VIP)。用户访问VIP,到达Director Server,Director Server根据一定的规则选择一个Real Server,处理完成后然后返回给客户端数据。这些步骤产生了一些具体的问题,比如如何选择具体的Real Server,Real Server如果返回给客户端数据等等。IPVS为此有三种机制:

- 1)VS/NAT(Virtual Server via Network Address Translation),即网络地址翻转技术实现虚拟服务器。

当请求来到时,Diretor server上处理的程序将数据报文中的目标地址(即虚拟IP地址)改成具体的某台Real Server,端口也改成Real Server的端口,然后把报文发给Real Server。Real Server处理完数据后,需要返回给Diretor Server,然后Diretor server将数据包中的源地址和源端口改成VIP的地址和端口,最后把数据发送出去。由此可以看出,用户的请求和返回都要经过Diretor Server,如果数据过多,Diretor Server肯定会不堪重负。

- 2)VS/TUN(Virtual Server via IP Tunneling),即IP隧道技术实现虚拟服务器。

IP隧道(IP tunneling)是将一个IP报文封装在另一个IP报文的技术,这可以使得目标为一个IP地址的数据报文能被封装和转发到另一个IP地址。IP隧道技术亦称为IP封装技术(IP encapsulation)。它跟VS/NAT基本一样,但是Real server是直接返回数据给客户端,不需要经过Diretor server,这大大降低了Diretor server的压力。

- 3)VS/DR(Virtual Server via Direct Routing),即用直接路由技术实现虚拟服务器。

跟前面两种方式,它的报文转发方法有所不同,VS/DR通过改写请求报文的MAC地址,将请求发送到Real Server,而Real Server将响应直接返回给客户,免去了VS/TUN中的IP隧道开销。这种方式是三种负载调度机制中性能最高最好的,但是必须要求Director Server与Real Server都有一块网卡连在同一物理网段上。

- 二、nginx和keepalived教程、lvs安装

- 2.1Nginx相关概念

- 反向代理

反向代理(Reverse Proxy)方式是指以代理服务器来接受internet上的连接请求,然后将请求转发给内部网络上的服务器,并将从服务器上得到的结果返回给internet上请求连接的客户端,此时代理服务器对外就表现为一个服务器。

- 负载均衡

负载均衡,英文名称为Load Balance,是指建立在现有网络结构之上,并提供了一种廉价有效透明的方法扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。其原理就是数据流量分摊到多个服务器上执行,减轻每台服务器的压力,多台服务器共同完成工作任务,从而提高了数据的吞吐量。

- 2.2Nginx的安装

- 下载nginx

- 上传并解压nginx

tar -zxvf nginx-1.8.1.tar.gz -C /usr/local/src

- 编译nginx

#进入到nginx源码目录

cd /usr/local/src/nginx-1.8.1

#检查安装环境,并指定将来要安装的路径

./configure --prefix=/usr/local/nginx

#缺包报错 ./configure: error: C compiler cc is not found

#使用YUM安装缺少的包

yum -y install gcc pcre-devel openssl openssl-devel

#编译安装

make && make install

安装完后测试是否正常:

/usr/loca/nginx/sbin/nginx

查看端口是否有ngnix进程监听

netstat -ntlp | grep 80

- 2.3配置nginx

- 2.3.1配置反向代理

- a修改nginx配置文件

| server { listen 80; server_name nginx-01.itcast.cn; #nginx所在服务器的主机名 #反向代理的配置 location / { #拦截所有请求 root html; proxy_pass http://192.168.0.21:8080; #这里是代理走向的目标服务器:tomcat } } |

- b启动tomcat-01上的tomcat

- c启动nginx-01上的nginx

./nginx

重启:

kill -HUP `cat /usr/local/nginx/logs/nginx.pid `

参考网址:http://www.cnblogs.com/jianxie/p/3990377.html

- 2.3.2动静分离

#动态资源 index.jsp

| location ~ .*\.(jsp|do|action)$ { proxy_pass http://tomcat-01.itcast.cn:8080; } |

#静态资源

| location ~ .*\.(html|js|css|gif|jpg|jpeg|png)$ { expires 3d; } |

- 2.3.3负载均衡

在http这个节下面配置一个叫upstream的,后面的名字可以随意取,但是要和location下的proxy_pass http://后的保持一致。

| http { 是在http里面的, 已有http, 不是在server里,在server外面 upstream tomcats { server shizhan02:8080 weight=1;#weight表示多少个 server shizhan03:8080 weight=1; server shizhan04:8080 weight=1; } #卸载server里 location ~ .*\.(jsp|do|action) { proxy_pass http://tomcats; #tomcats是后面的tomcat服务器组的逻辑组号 } } |

- 2.4利用keepalived实现高可靠(HA)

- 2.4.1高可靠概念

HA(High Available), 高可用性集群,是保证业务连续性的有效解决方案,一般有两个或两个以上的节点,且分为活动节点及备用节点。

- 2.4.2高可靠软件keepalived

keepalive是一款可以实现高可靠的软件,通常部署在2台服务器上,分为一主一备。Keepalived可以对本机上的进程进行检测,一旦Master检测出某个进程出现问题,将自己切换成Backup状态,然后通知另外一个节点切换成Master状态。

- 2.4.3keepalived安装

下载keepalived官网:http://keepalived.org

将keepalived解压到/usr/local/src目录下

tar -zxvf keepalived-1.2.19.tar.gz -C /usr/local/src

进入到/usr/local/src/keepalived-1.2.19目录

cd /usr/local/src/keepalived-1.2.19

开始configure

./configure --prefix=/usr/local/keepalived

#编译并安装

make && make install

- 2.4.4将keepalived添加到系统服务中

拷贝执行文件

cp /usr/local/keepalived/sbin/keepalived /usr/sbin/

将init.d文件拷贝到etc下,加入开机启动项

cp /usr/local/keepalived/etc/rc.d/init.d/keepalived /etc/init.d/keepalived

将keepalived文件拷贝到etc下

cp /usr/local/keepalived/etc/sysconfig/keepalived /etc/sysconfig/

创建keepalived文件夹

mkdir -p /etc/keepalived

将keepalived配置文件拷贝到etc下

cp /usr/local/keepalived/etc/keepalived/keepalived.conf /etc/keepalived/keepalived.conf

添加可执行权限

chmod +x /etc/init.d/keepalived

##以上所有命令一次性执行:

| cp /usr/local/keepalived/sbin/keepalived /usr/sbin/ cp /usr/local/keepalived/etc/rc.d/init.d/keepalived /etc/init.d/keepalived cp /usr/local/keepalived/etc/sysconfig/keepalived /etc/sysconfig/ mkdir -p /etc/keepalived cp /usr/local/keepalived/etc/keepalived/keepalived.conf /etc/keepalived/keepalived.conf chmod +x /etc/init.d/keepalived chkconfig --add keepalived chkconfig keepalived on |

添加keepalived到开机启动

chkconfig --add keepalived

chkconfig keepalived on

- 2.4.5配置keepalived虚拟IP

修改配置文件: /etc/keepalived/keepalived.conf

#MASTER节点

| global_defs { } vrrp_instance VI_1 { state MASTER #指定A节点为主节点 备用节点上设置为BACKUP即可 interface eth0 #绑定虚拟IP的网络接口 virtual_router_id 51 #VRRP组名,两个节点的设置必须一样,以指明各个节点属于同一VRRP组 priority 100 #主节点的优先级(1-254之间),备用节点必须比主节点优先级低 advert_int 1 #组播信息发送间隔,两个节点设置必须一样 authentication { #设置验证信息,两个节点必须一致 auth_type PASS auth_pass 1111 } virtual_ipaddress { #指定虚拟IP, 两个节点设置必须一样 192.168.33.60/24 #如果两个nginx的ip分别是192.168.33.61,,...62,则此处的虚拟ip跟它俩同一个网段即可 } } |

#BACKUP节点

| global_defs { } vrrp_instance VI_1 { state BACKUP interface eth0 virtual_router_id 51 priority 99 advert_int 1 authentication { auth_type PASS auth_pass 1111 } virtual_ipaddress { 192.168.33.60/24 } } |

#分别启动两台机器上的keepalived

service keepalived start

测试:

杀掉master上的keepalived进程,你会发现,在slave机器上的eth0网卡多了一个ip地址

查看ip地址的命令: ip addr

- 2.4.6配置keepalived心跳检查

原理:

Keepalived并不跟nginx耦合,它俩完全不是一家人

但是keepalived提供一个机制:让用户自定义一个shell脚本去检测用户自己的程序,返回状态给keepalived就可以了

#MASTER节点

| global_defs { }

vrrp_script chk_health { script "[[ `ps -ef | grep nginx | grep -v grep | wc -l` -ge 2 ]] && exit 0 || exit 1" interval 1 #每隔1秒执行上述的脚本,去检查用户的程序ngnix weight -2 }

vrrp_instance VI_1 { state MASTER interface eth0 virtual_router_id 1 priority 100 advert_int 2 authentication { auth_type PASS auth_pass 1111 }

track_script { chk_health }

virtual_ipaddress { 10.0.0.10/24 }

notify_master "/usr/local/keepalived/sbin/notify.sh master" notify_backup "/usr/local/keepalived/sbin/notify.sh backup" notify_fault "/usr/local/keepalived/sbin/notify.sh fault" } |

#添加切换通知脚本

vi /usr/local/keepalived/sbin/notify.sh

| #!/bin/bash

case "$1" in master) /usr/local/nginx/sbin/nginx exit 0 ;; backup) /usr/local/nginx/sbin/nginx -s stop /usr/local/nginx/sbin/nginx exit 0 ;; fault) /usr/local/nginx/sbin/nginx -s stop exit 0 ;; *) echo 'Usage: notify.sh {master|backup|fault}' exit 1 ;; esac |

#添加执行权限

chmod +x /usr/local/keepalived/sbin/notify.sh

| global_defs { }

vrrp_script chk_health { script "[[ `ps -ef | grep nginx | grep -v grep | wc -l` -ge 2 ]] && exit 0 || exit 1" interval 1 weight -2 }

vrrp_instance VI_1 { state BACKUP interface eth0 virtual_router_id 1 priority 99 advert_int 1 authentication { auth_type PASS auth_pass 1111 }

track_script { chk_health }

virtual_ipaddress { 10.0.0.10/24 }

notify_master "/usr/local/keepalived/sbin/notify.sh master" notify_backup "/usr/local/keepalived/sbin/notify.sh backup" notify_fault "/usr/local/keepalived/sbin/notify.sh fault" } |

#在第二台机器上添加notify.sh脚本

#分别在两台机器上启动keepalived

service keepalived start

chkconfig keepalived on

- 2.5lvs安装

- 2.5.1安装lvs应用模块

1、安装依赖包:

yum -y install ipvs*

2、验证本机ip_vs模块是否加载

[root@client lvs]# grep -i 'ip_vs' /boot/config-2.6.32-431.el6.x86_64

CONFIG_IP_VS=m

CONFIG_IP_VS_IPV6=y

# CONFIG_IP_VS_DEBUG is not set

CONFIG_IP_VS_TAB_BITS=12

CONFIG_IP_VS_PROTO_TCP=y

CONFIG_IP_VS_PROTO_UDP=y

CONFIG_IP_VS_PROTO_AH_ESP=y

CONFIG_IP_VS_PROTO_ESP=y

CONFIG_IP_VS_PROTO_AH=y

CONFIG_IP_VS_PROTO_SCTP=y

CONFIG_IP_VS_RR=m

CONFIG_IP_VS_WRR=m

CONFIG_IP_VS_LC=m

CONFIG_IP_VS_WLC=m

CONFIG_IP_VS_LBLC=m

CONFIG_IP_VS_LBLCR=m

CONFIG_IP_VS_DH=m

CONFIG_IP_VS_SH=m

CONFIG_IP_VS_SED=m

CONFIG_IP_VS_NQ=m

CONFIG_IP_VS_FTP=m

CONFIG_IP_VS_PE_SIP=m

- 2.5.2安装lvs

- a)编写lvs drsrever脚本:

- a.1)修改functions权限:

(functions这个脚本是给/etc/init.d里边的文件使用的(可理解为全局文件)。)

chmod 755 /etc/rc.d/init.d/functions

- a.2)创建lvs文件夹

cd /usr/local

mkdir –m 755 lvs

cd /lvs

- a.3)编写脚本

vi lvs_dr.sh

| #!/bin/bash #description:start lvs server echo "1" >/proc/sys/net/ipv4/ip_forward #开启ip转发 WEB1=192.168.56.200 #真实的webip WEB2=192.168.56.201 #真实的webip VIP1=192.168.56.80 #虚拟lvs的ip /etc/rc.d/init.d/functions #初始化function case "$1" in #第一个参数 start) #第一个参数是start echo "start LVS of directorServer" #打印 /sbin/ifconfig eth0:0 $VIP1 broadcast $VIP1 netmask 255.255.255.255 up #设置虚拟网络 /sbin/ipvsadm –C #清除内核虚拟服务器表中的所有记录,清除lvs设置 /sbin/ipvsadm -A -t $VIP1:8080 -s rr #设置rr模式,轮询模式 /sbin/ipvsadm -a -t $VIP1:8080 -r $WEB1:8080 –g #轮询的机器,-g采用DR模式 /sbin/ipvsadm -a -t $VIP1:8080 -r $WEB2:8080 –g /sbin/ipvsadm #启动lvs ;; stop) #如果第一个参数是stop echo "close LVS directorserver" #打印 echo "0" >/proc/sys/net/ipv4/ip_forward #关闭ip转发 /sbin/ipvsadm –C #清除内核虚拟服务器表中的所有记录 /sbin/ipvsadm –Z #虚拟服务表计数器清零(清空当前的连接数量等) ;; *) #如果第一个参数是其他任何值 echo "usage:$0 {start|stop}" #打印:提示输入start或者stop exit 1 #退出 esac #循环结束 |

- a.4)执行脚本

chmod 755 lvs_dr.sh

./lvs-dr.sh start

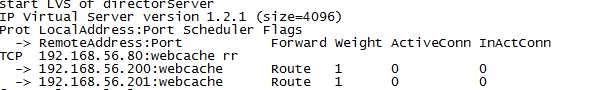

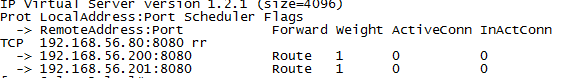

- a.5)查看:

ipvsadm –ln

看到上面信息说明ipvsadm启动成功。

- b)编写lvs realserver脚本

- b.1)在web1 和web2机器上修改functions权限:

(functions这个脚本是给/etc/init.d里边的文件使用的(可理解为全局文件)。)

chmod 755 /etc/rc.d/init.d/functions

- b.2)在分别在web1 和web2服务器上创建lvs文件夹:

cd /usr/local

mkdir –m 755 lvs

cd lvs

rz –y

- b.3)编写监本

vi lvs-rs.sh

| #!/bin/sh VIP1=192.168.56.80 #虚拟ip /etc/rc.d/init.d/functions #初始化function case "$1" in #第一个参数 start) #如果第一个参数是start echo "start LVS of realserver" #打印 /sbin/ifconfig lo:0 $VIP1 broadcast $VIP1 netmask 255.255.255.255 up #设置虚拟网络 echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore #定义接收到ARP请求时的响应级别 echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce #定义将自己的地址向外通告时的级别 echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce ;; stop) #如果第一个参数是stop /sbin/ifconfig lo:0 down #停止网卡 echo "close lvs dirctorserver" #打印 echo "0" >/proc/sys/net/ipv4/conf/lo/arp_ignore #定义接收到ARP请求时的响应级别 echo "0" >/proc/sys/net/ipv4/conf/lo/arp_announce #定义将自己的地址向外通告时的级别 echo "0" >/proc/sys/net/ipv4/conf/all/arp_ignore echo "0" >/proc/sys/net/ipv4/conf/all/arp_announce ;; *) echo "usage:$0{start|stop}" exit 1 esac |

- b.4)启动在web1 和web2机器上lvs:

chmod 755 lvs-rs.sh

./lvs-rs.sh start

- 2.5.4设置dr机器上设置连接超时值(秒)

ipvsadm --set 1 1 1

- 2.5.5关闭

./lvs-rs.sh stop

./lvs-dr.sh stop

三、iptables教程

- 3.1iptables防火墙简介

Iptables也叫netfilter是Linux下自带的一款免费且优秀的基于包过滤的防火墙工具,它的功能十分强大,使用非常灵活,可以对流入、流出、流经服务器的数据包进行精细的控制。iptables是Linux2.4及2.6内核中集成的模块。

- 3.2Iptables服务相关命令

- 1)查看iptables状态

service iptables status

- 2)开启/关闭iptables

service iptables start

service iptables stop

- 3)查看iptables是否开机启动

chkconfig iptables --list

- 4)设置iptables开机启动/不启动

chkconfig iptables on

chkconfig iptables off

- 3.3iptables原理简介

- iptables的结构

在iptables中有四张表,分别是filter、nat、mangle和raw每一个表中都包含了各自不同的链,最常用的是filter表。

- filter表:

filter是iptables默认使用的表,负责对流入、流出本机的数据包进行过滤,该表中定义了3个链:

INPOUT 负责过滤所有目标地址是本机地址的数据包,就是过滤进入主机的数据包。

FORWARD 负责转发流经本机但不进入本机的数据包,起到转发的作用。

OUTPUT 负责处理所有源地址是本机地址的数据包,就是处理从主机发出去的数据包。

3.4iptables练习

#查看帮助

iptables -h

man iptables

列出iptables规则

iptables -L -n

列出iptables规则并显示规则编号

iptables -L -n --line-numbers

列出iptables nat表规则(默认是filter表)

iptables -L -n -t nat

清除默认规则(注意默认是filter表,如果对nat表操作要加-t nat)

#清楚所有规则

iptables -F

#重启iptables发现规则依然存在,因为没有保存

service iptables restart

#保存配置

service iptables save

#禁止ssh登陆(若果服务器在机房,一定要小心)

iptables -A INPUT -p tcp --dport 22 -j DROP

#删除规则

iptables -D INPUT -p tcp --dport 22 -j DROP

-A, --append chain 追加到规则的最后一条

-D, --delete chain [rulenum] Delete rule rulenum (1 = first) from chain

-I, --insert chain [rulenum] Insert in chain as rulenum (default 1=first) 添加到规则的第一条

-p, --proto proto protocol: by number or name, eg. 'tcp',常用协议有tcp、udp、icmp、all

-j, --jump target 常见的行为有ACCEPT、DROP和REJECT三种,但一般不用REJECT,会带来安全隐患

注意:INPUT和DROP这样的关键字需要大写

#禁止192.168.33.0网段从eth0网卡接入

iptables -A INPUT -p tcp -i eth0 -s 192.168.33.0 -j DROP

iptables -A INPUT -p tcp --dport 22 -i eth0 -s 192.168.33.61 -j ACCEPT

#禁止ip地址非192.168.10.10的所有类型数据接入

iptables -A INPUT ! -s 192.168.10.10 -j DROP

#禁止ip地址非192.168.10.10的ping请求

iptables -I INPUT -p icmp --icmp-type 8 -s 192.168.50.100 -j DROP

#扩展匹配:1.隐式扩展 2.显示扩展

#隐式扩展

-p tcp

--sport PORT 源端口

--dport PORT 目标端口

#显示扩展:使用额外的匹配规则

-m EXTENSTION --SUB-OPT

-p tcp --dport 22 与 -p tcp -m tcp --dport 22功能相同

state:状态扩展,接口ip_contrack追踪会话状态

NEW:新的连接请求

ESTABLISHED:已建立的连接请求

INVALID:非法连接

RELATED:相关联的连接

#匹配端口范围

iptables -I INPUT -p tcp --dport 22:80 -j DROP

#匹配多个端口

iptables -I INPUT -p tcp -m multiport --dport 22,80,3306 -j ACCEPT

#不允许源端口为80的数据流出

iptables -I OUTPUT -p tcp --sport 80 -j DROP