根据书籍《从零开始学Python网络爬虫》P41,综合案例2—爬取酷狗TOP500的数据修改而来.

使用模块requests和模块BeautifukSoup进行爬取.

不得不说,酷狗拿来跑爬虫真是好,不ban不限制IP~

要爬取的页面信息

酷狗TOP500

需要爬取的信息很少:1.排名 2.标题(歌名-歌手) 3.时长

每页22条信息,需要爬取500/22≈23页

虽然没有手动翻页下一步浏览,但是只要修改网页:

http://www.kugou.com/yy/rank/home/1-8888.html?from=rank 为

http://www.kugou.com/yy/rank/home/2-8888.html?from=rank

就得到第二页的信息.

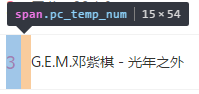

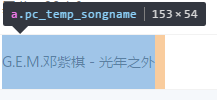

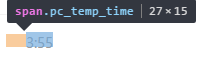

使用浏览器中审查元素功能,得到: 信息对应的标签属性,使用soup.select()获取标签,再使用tag.get_text()获取文本即可

代码实现

知道了要爬的标签,写起来就很轻松了,确定流程如下:

1.设置Headers的User-Agent伪装浏览器访问

2.获取酷狗主站的编码格式<meta charset=xxx>,并设置到request中res.encoding,对应的res.text就会重新编码.这样soup在使用lxml解析器时就不会出现乱码了.

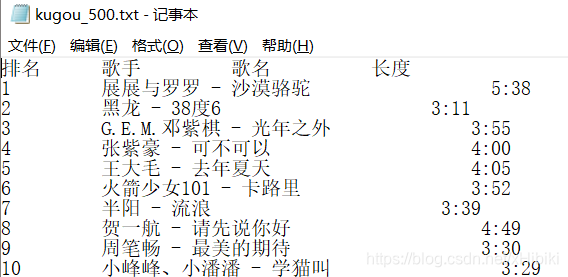

3.打开文件kugou_500.txt,设置为写入方式,f.encoding=res.encoding,统一编码格式

4.对23个网页中,每个网页执行一次get_info()获取信息,然后按格式写入到文件kugou_500.txt中.

5.等待爬虫结束,然后查看爬取结果.

from bs4 import BeautifulSoup

import requests

import time

import re

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/56.0.2924.87 Safari/537.36'

}

def get_info(url, file):

res = requests.get(url, headers=headers)

res.encoding = file.encoding # 同样读取和写入的编码格式

soup = BeautifulSoup(res.text, 'lxml')

ranks = soup.select('span.pc_temp_num')

titles = soup.select('a.pc_temp_songname')

times = soup.select('span.pc_temp_time')

for rank, title, time in zip(ranks, titles, times):

data = {

'rank': rank.get_text().strip(),

'title': title.get_text().strip(),

'time': time.get_text().strip()

}

string="{: <10}{: <30}{: <10}\n".format(data['rank'],data['title'],data['time'])#格式化输出

file.write(string)

def get_website_encoding(url): # 一般每个网站自己的网页编码都是一致的,所以只需要搜索一次主页确定

res = requests.get(url, headers=headers)

charset = re.search("charset=(.*?)>", res.text)

if charset is not None:

blocked = ['\'', ' ', '\"', '/']

filter = [c for c in charset.group(1) if c not in blocked]

return ''.join(filter) # 修改res编码格式为源网页的格式,防止出现乱码

else:

return res.encoding # 没有找到编码格式,返回res的默认编码

if __name__ == '__main__':

encoding = get_website_encoding('http://www.kugou.com')

urls = ['http://www.kugou.com/yy/rank/home/{}-8888.html?from=rank'.format(str(i)) for i in range(1, 23)]

with open(r'd:\kugou_500.txt', 'w', encoding=encoding) as f:

f.write("排名 歌手 歌名 长度\n")

for url in urls:

get_info(url, f)

time.sleep(1) #缓冲一秒,防止请求频率过快

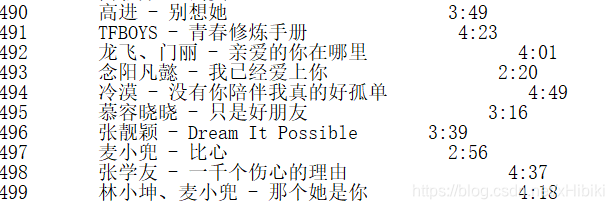

数据展示

…

写在后面

这里只是展示一个基本的爬虫实例作为练手,就不做改进了.

可改进如下:

1.保存和显示的格式可以更美观

2.将标题分割为歌手和歌名

3.将数据存入数据库,然后进行相关的数学分析和统计等…