版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/chapterchou/article/details/53839864

在上网浏览网页的时候,经常会看到一些好看的图片,我们就希望把这些图片保存下载,或者用户用来做桌面壁纸,或者用来做设计的素材。

我们最常规的做法就是通过鼠标右键,选择另存为。但有些图片鼠标右键的时候并没有另存为选项,还有办法就通过就是通过截图工具截取下来,但这样就降低图片的清晰度。如何批量的保存图片呢,Python几行代码就能搞定。

获取页面数据

到http://tieba.baidu.com/p/2460150866 去查看

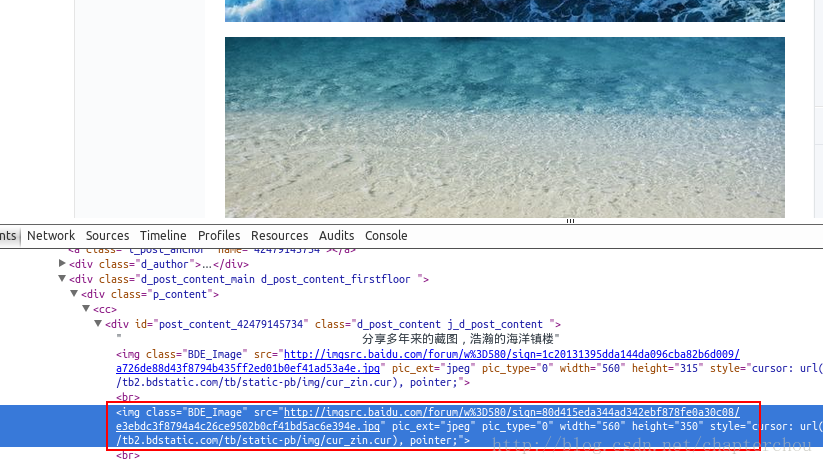

通过到前段查看工具。找到了图片的地址,如:src=”http://imgsrc.baidu.com/forum……jpg”pic_ext=”jpeg”

代码

# coding=utf-8

import urllib.request

import re

def downloadPage(url):

h = urllib.request.urlopen(url)

return h.read().decode('utf-8')

def downloadImg(content):

pattern = r'src="(.+?\.jpg)" pic_ext'

m = re.compile(pattern)

urls = re.findall(m, content)

for i, url in enumerate(urls):

urllib.request.urlretrieve(url, "%s.jpg" % (i,))

content = downloadPage("http://tieba.baidu.com/p/2460150866")

downloadImg(content)