版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/cuicanxingchen123456/article/details/83343329

开发环境:hadoop2.6.5, jdk1.8. ubuntu14系统

1.在本地写好代码(eclipse写的,当时没用maven,直接把jar引到程序里了)

2.打成jar包(eclipse右键项目,点击export,选择jar包类型),打jar包的时候记得引入程序入口类,以及不加入代码依赖的jar包

3.在集群的master节点上,使用hadoop fs -ls -R /查看hdfs中的文件列表

4.在hdfs上新建文件夹data,hadoop fs -mkdir -p /user/data

5.将数据传到data文件夹中,hadoop fs -put ddd /user/data

6.将程序打好的jar包(hadoopDemo.jar)上传到master节点上

7.执行hadoop jar hadoopDemo.jar /user/data /user/out1(out1是输出文件的目录)

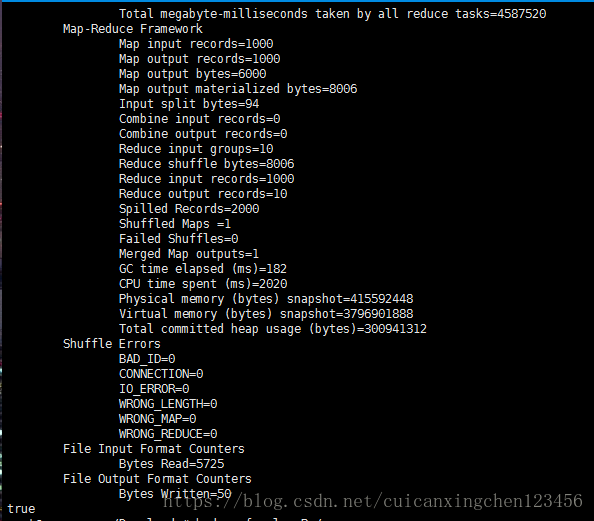

程序执行成功之后的结果:

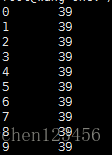

8.命令hadoop fs -cat /user/out1/part-r*查看代码执行结果

这个例子是key是0-9的随机数,value是0-40的随机数(用random随机生成的)。然后找出来每个key对应的value的最大值

代码和数据:https://download.csdn.net/download/cuicanxingchen123456/10741216