版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/u012829611/article/details/77679219

前言:本文案例测试所需环境都是在前面几篇blog的基础上进行的,具体内容请查看:

http://blog.csdn.net/u012829611/article/details/77678609

http://blog.csdn.net/u012829611/article/details/77651855

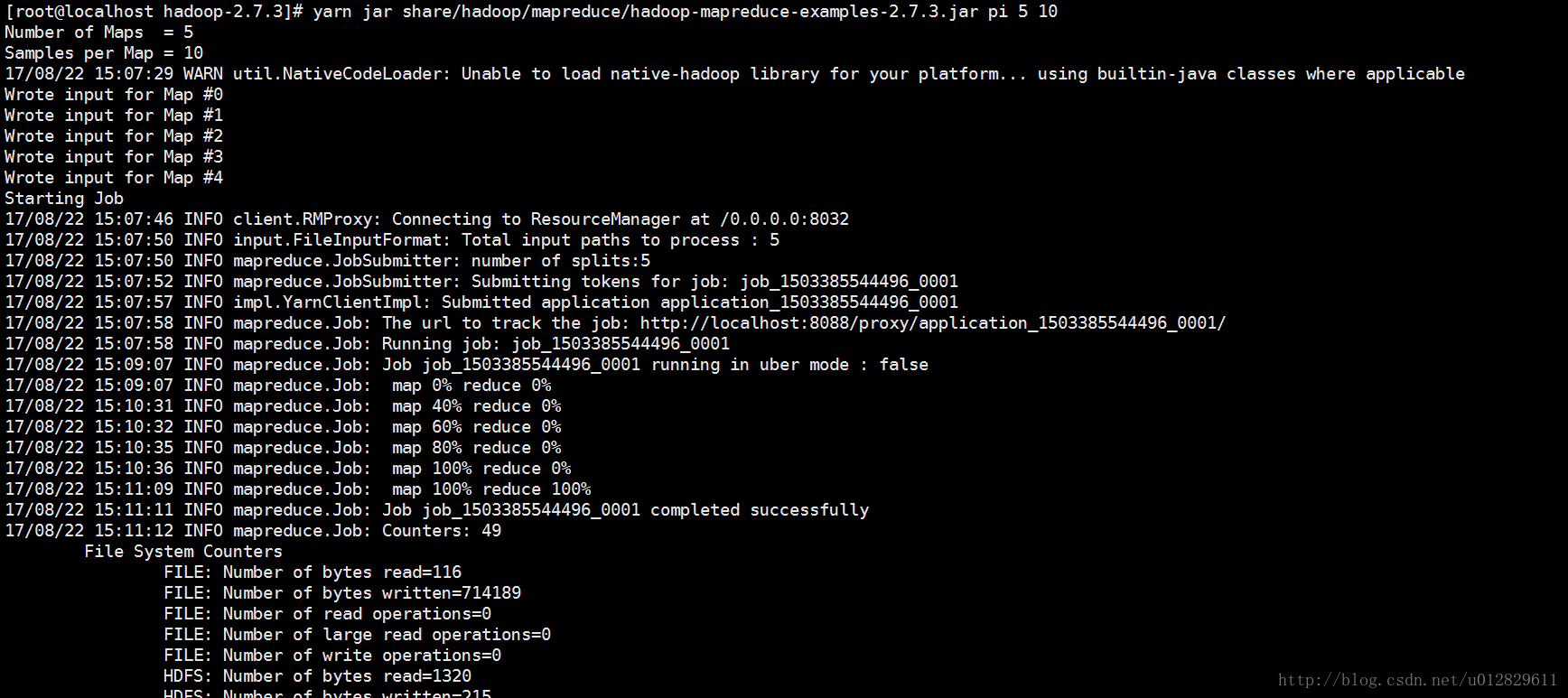

1.使用hadoop估算pi的值

[hadoop@localhost hadoop-2.7.3]# yarn jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar pi 5 10注:命令中,“5”表示map进行5次,“10”表示每次map投掷10次(相当于扔飞镖10次计算出pi的值)

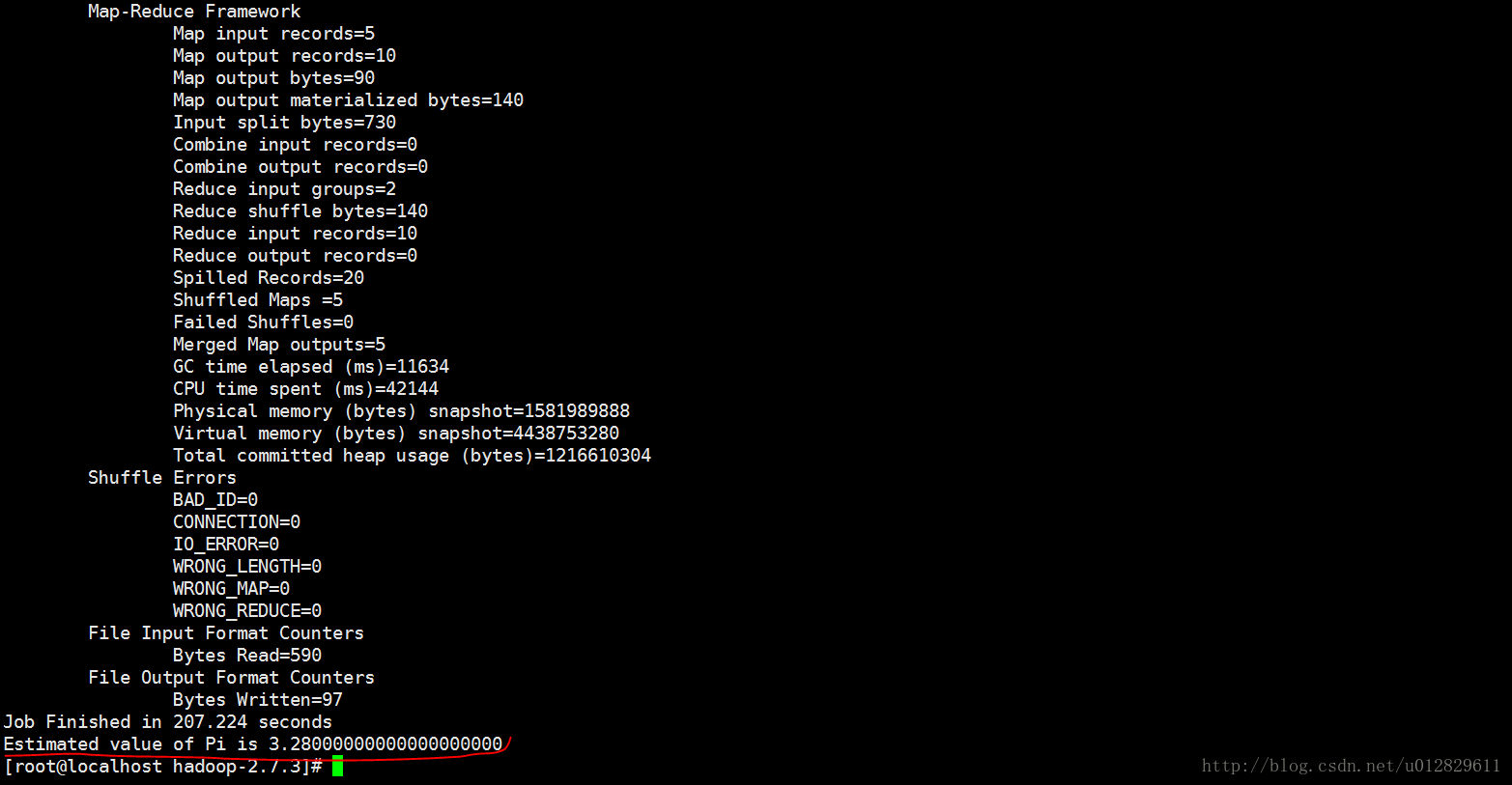

最终计算结果:

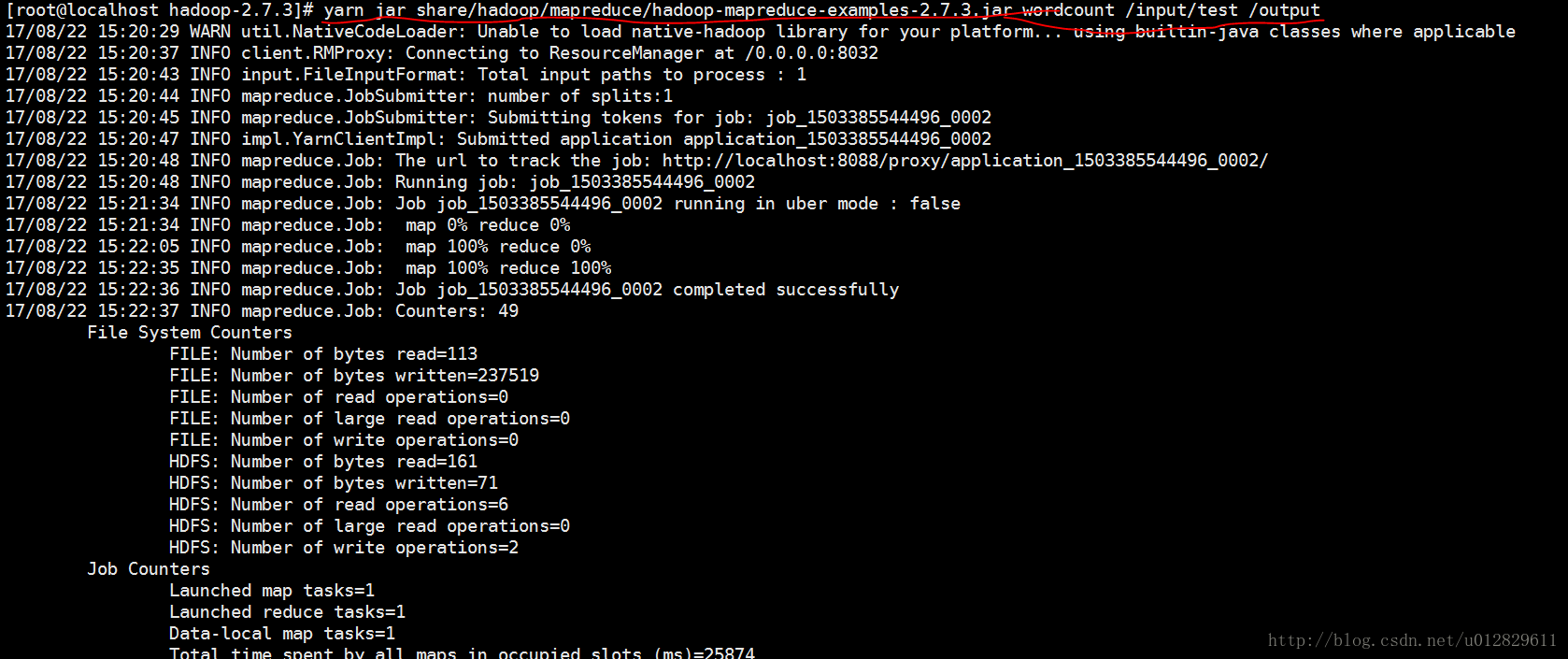

2.使用mapreduce中wordcount函数计算/input目录下test文件中单词出现的次数,结果输出到/output目录下

//hdfs上创建文件夹input

[hadoop@localhost hadoop-2.7.3]# hdfs dfs -mkdir /input

[hadoop@localhost hadoop-2.7.3]# hdfs dfs -ls ///新建test文件,输入一些字符串

[hadoop@localhost hadoop-2.7.3]# vim test//将test文件put到hdfs的input目录下

[hadoop@localhost hadoop-2.7.3]# hdfs dfs -put test /input//执行命令

[hadoop@localhost hadoop-2.7.3]# yarn jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar wordcount /input/test /output//查看output目录下的文件

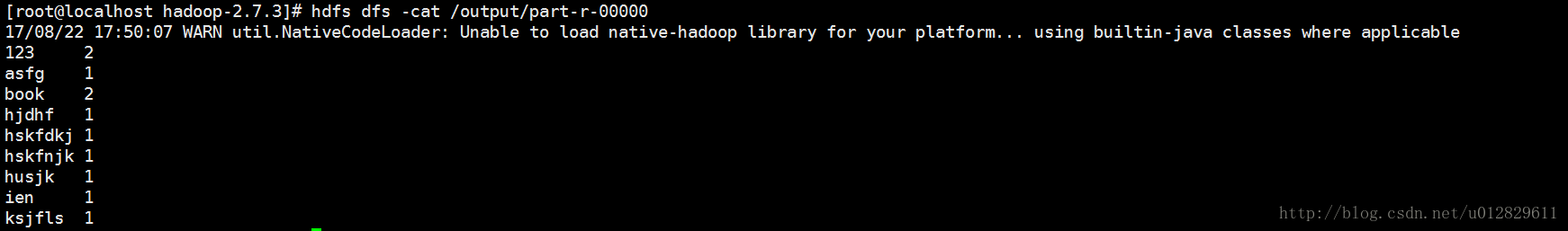

[hadoop@localhost hadoop-2.7.3]# hdfs dfs -ls /output//查看统计结果

[hadoop@localhost hadoop-2.7.3]# hdfs dfs -cat /output/part-r-00000附:

①hdfs dfs -rm -r /output //删除hdfs上的output文件夹

关于hadoop不支持本地库问题

问题描述:hadoop安装完后,使用”hadoop checknative”命令查看是否支持本地库时,发现不支持hadoop、zlib、snappy等一些本地库。

解决方法:执行以下命令

[hadoop@localhost bin]# export HADOOP_OPTS="-Djava.library.path=./../lib/native/"参考文档:

http://blog.csdn.net/ligt0610/article/details/47757013

https://zhidao.baidu.com/question/1766673293716469500.html