Scrapy的基本用法

1.在cmd里面输入pip install scrapy:

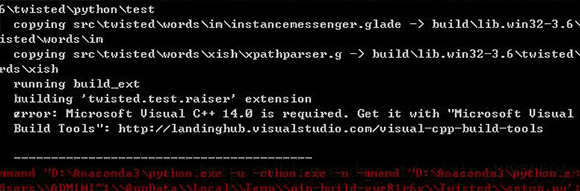

如果没有安装scrapy就出现错误,如下图:

2.Scrapy的安装

Anaconda

这种方法是一种比较简单的安装Scrapy的方法(尤其是对Windows来说),你可以使用该方法安装,也可以选用下文中专用平台的安装方法。

Anaconda是包含了常用的数据科学库的Python发行版本,如果没有安装,可以到https://www.continuum.io/downloads下载对应平台的包安装。

如果已经安装,那么可以打开cmd轻松地通过conda命令安装Scrapy。

安装命令如下:

conda install Scrapy

检测scrapy是否安装成功

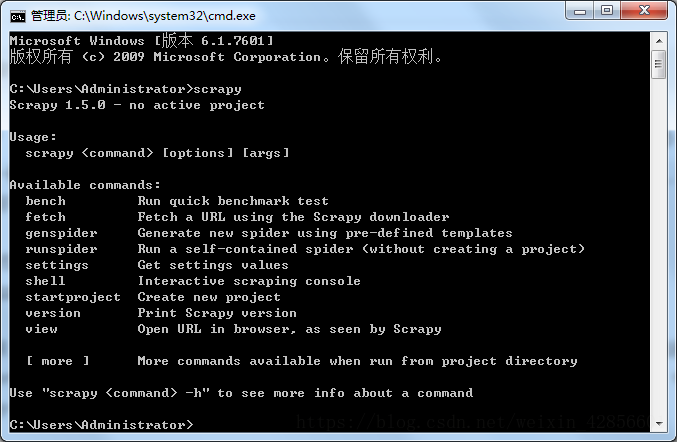

在cmd中输入scrapy,如果安装成功,如下图:

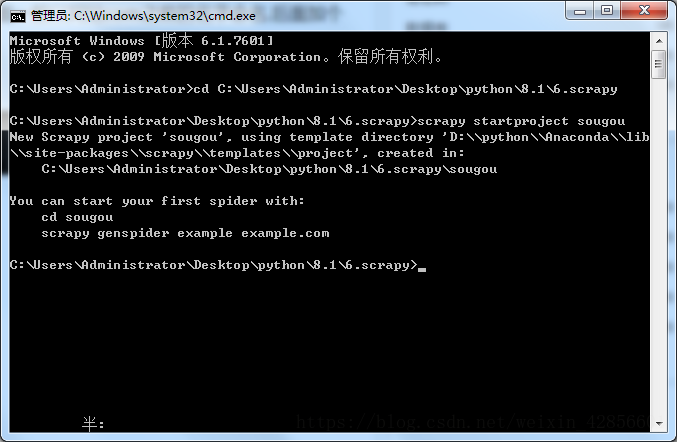

3.通过命令创建项目

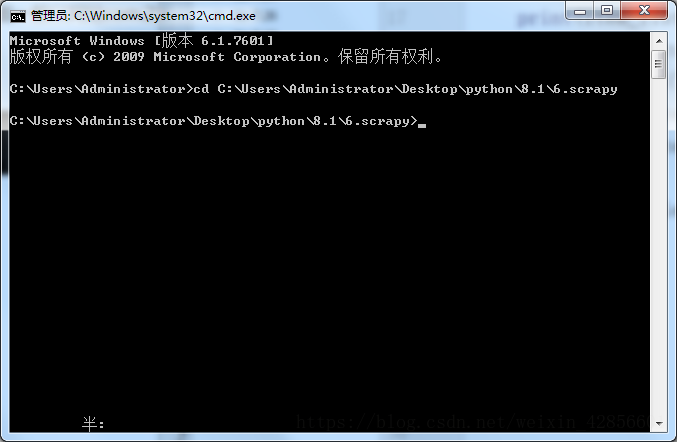

在cmd中输入cd 然后将想要放的位置的路径或者主文件夹拖进来,系统会自动生成文件路径,如下图:

之后输入scrapy startproject sougou (前面两个单词是固定格式,后面一般以网站com之前的名字命名)按下回车键,如下图:

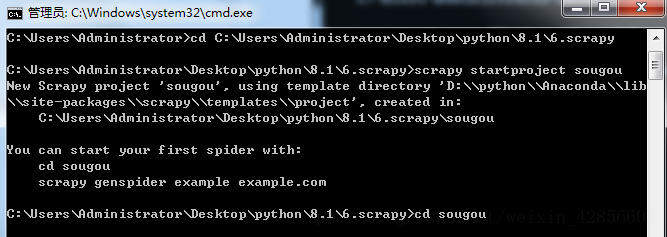

4.进入生成的工程目录

输入cd sougou ,如下图:

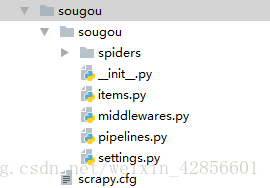

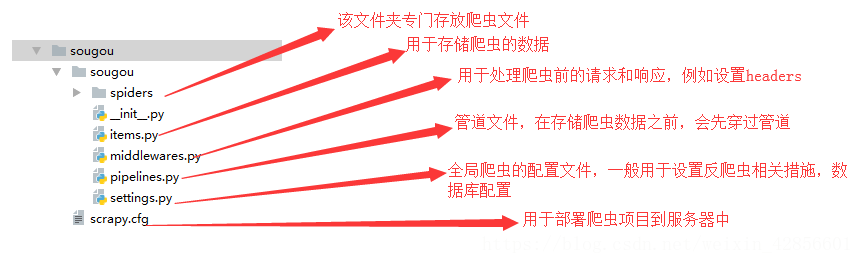

5.用pycharm打开项目

打开之后一般就是这样的形式 , 如下图

这里面的各个.py文件所包含的功能和作用都是不一样的!

以下是它们之间的分工:

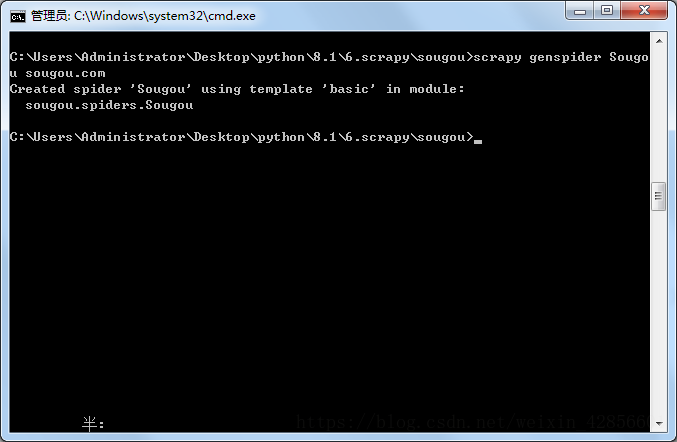

6.通过命令创建爬虫

7.运行

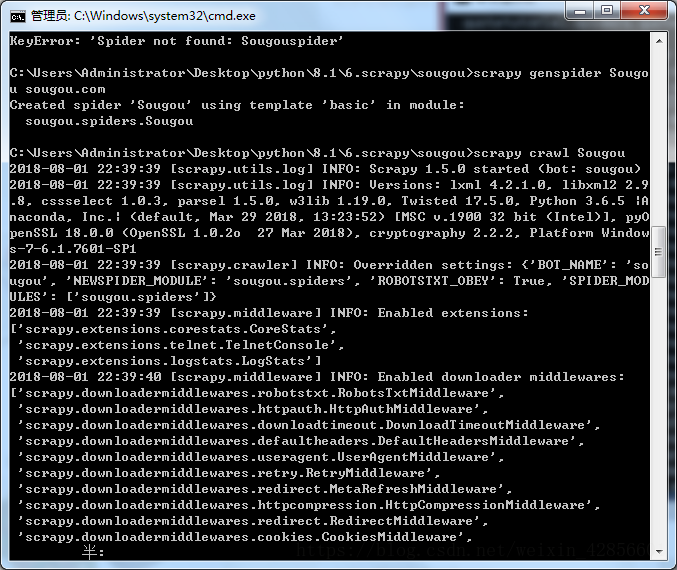

运行命令:输入scrapy crawl Sougou ,运行结果如下: