今天进行了机器学习第一章的学习,我觉得首先你可以认清这些概念

(1)模型、策略、算法

(2)分类与回归的概念

(3)监督、无监督、半监督问题

(2)过拟合、欠拟合

下面是拓展的一些概念:

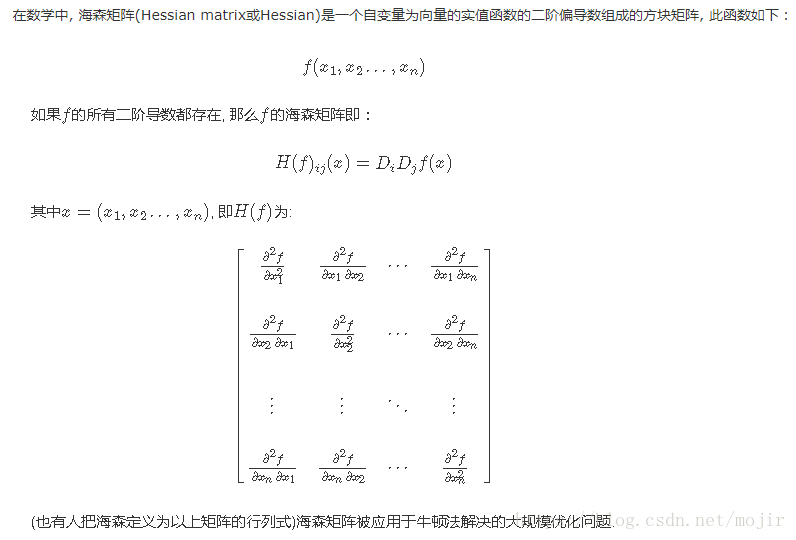

海森矩阵:

黑塞矩阵(Hessian Matrix),又译作海森矩阵、海瑟矩阵、海塞矩阵等,是一个多元函数的二阶偏导数构成的方阵,描述了函数的局部曲率。黑塞矩阵常用于牛顿法解决优化问题,利用黑塞矩阵可判定多元函数的极值问题。在工程实际问题的优化设计中,所列的目标函数往往很复杂,为了使问题简化,常常将目标函数在某点邻域展开成泰勒多项式来逼近原函数,此时函数在某点泰勒展开式的矩阵形式中会涉及到黑塞矩阵。

雅可比矩阵

在向量分析中, 雅可比矩阵是一阶偏导数以一定方式排列成的矩阵, 其行列式称为雅可比行列式. 还有, 在代数几何中, 代数曲线的雅可比量表示雅可比簇:伴随该曲线的一个代数群, 曲线可以嵌入其中. 它们全部都以数学家卡尔·雅可比(Carl Jacob, 1804年10月4日-1851年2月18日)命名;英文雅可比量”Jacobian”可以发音为[ja ˈko bi ən]或者[ʤə ˈko bi ən].

雅可比矩阵的重要性在于它体现了一个可微方程与给出点的最优线性逼近. 因此, 雅可比矩阵类似于多元函数的导数.

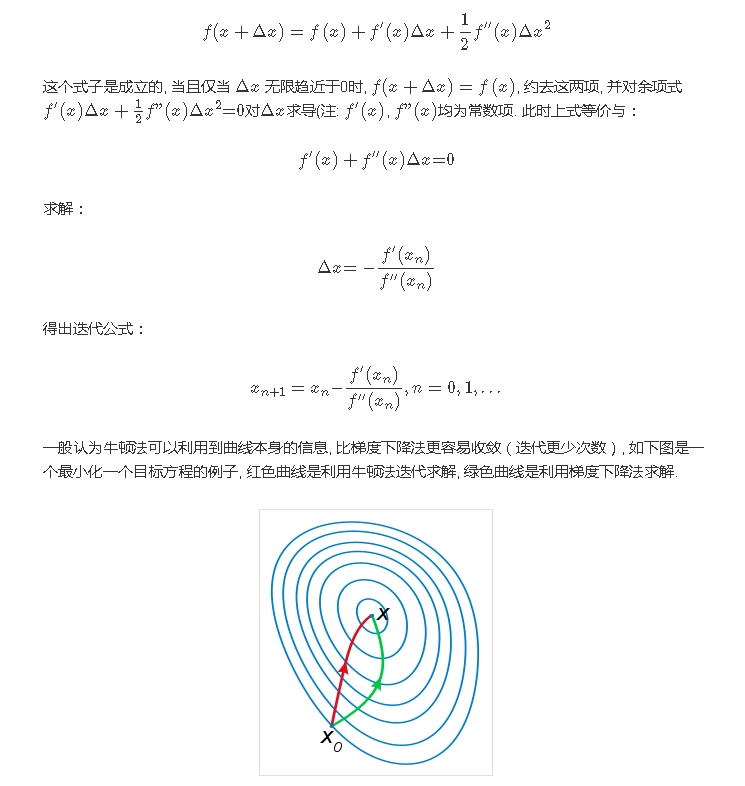

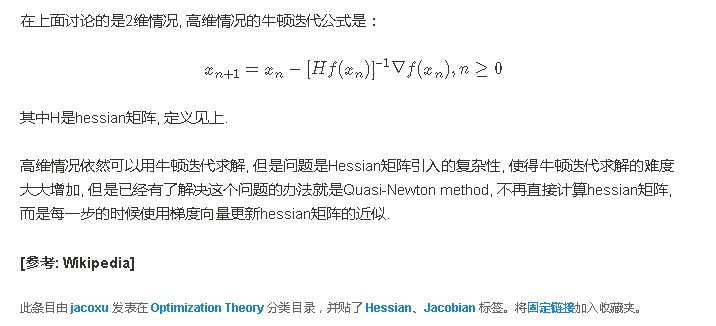

牛顿法最优化问题:

在最优化的问题中, 线性最优化至少可以使用单纯形法(或称不动点算法)求解, 但对于非线性优化问题, 牛顿法提供了一种求解的办法. 假设任务是优化一个目标函数ff, 求函数ff的极大极小问题, 可以转化为求解函数ff的导数f′=0f′=0的问题, 这样求可以把优化问题看成方程求解问题(f′=0f′=0). 剩下的问题就和第一部分提到的牛顿法求解很相似了.

这次为了求解f′=0f′=0的根, 把f(x)f(x)的泰勒展开, 展开到2阶形式:

梯度下降只是数值求解的具体操作,和最小二乘准则下面的最优化问题都可以用随机梯度下降求解