绪论

转载请标明出处,本篇文章允许转载,禁止抄袭

前言

随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。

一、什么是机器学习?

简单来说,给定一堆数据,通过设定的代码,获得一个函数F(x),当给定未学习过的数据时,获得我们想要的预测结果。

比如说,给了一个小孩一堆水果(10个苹果,10个梨,8个李子,12个桃子),小孩就可以看做一个学习器,通过学习这一堆水果,再给一个苹果,虽然这个苹果他没见过,但是他能较大概率判定为苹果。

概念:一般地,预测任务是希望通过对训练集{(x1,y1),(x2,y2),……,(xm,ym)}进行学习,建立一个从输入空间X到输出空间Y的映射f:X->Y。(本句话结合上面两句和第二点理解会更容易)

目标:使学得的模型能很好地适用于“新样本”。

对于二分类任务,通常令Y={-1,+1}或{0,1};对于多分类任务,|Y|>2(大于两个类别);对于回归任务,Y∈R,R为实数集。(分类任务的结果是将数据进行分类,回归任务一般来说是输出一个值)

二、基本术语

数据:

- 形式: (x1,x2,……,xn)——一个拥有n个属性的数据

例如:(姓名 = 张三,性别 = 男,专业 = 法外狂徒)括号内是一条记录, “ = ”意思为 “ 取值为 ”

每条记录是关于一个事件或对象的描述,称为一个“示例”或“样本”。反应事件或对象在某方面的表现或性质的事项,例如“姓名”,“性别”等等,都称为“属性”或“特征”,属性上的取值称为属性值。

数据集:

- 多条记录的集合称为一个“数据集”,常用D表示。

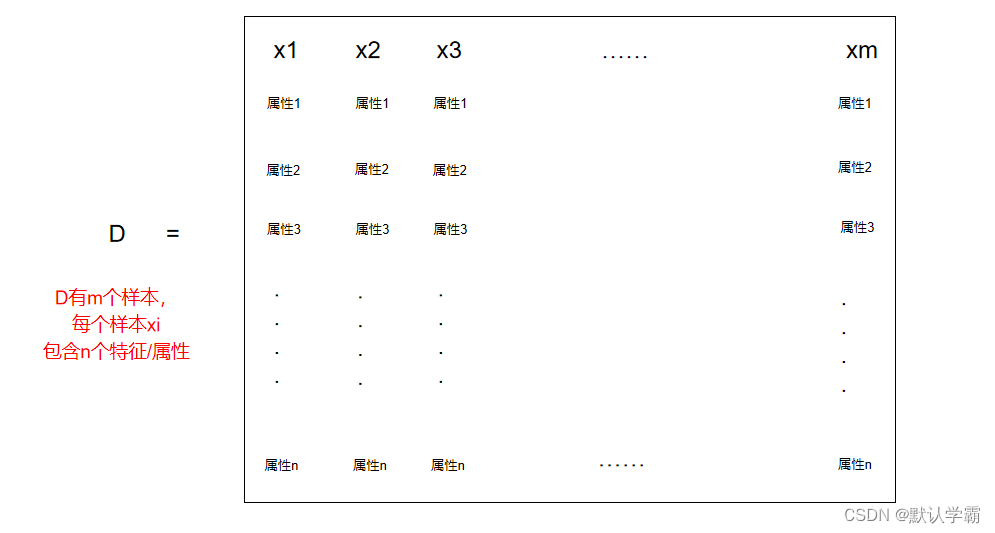

- D={x1,x2,……,xm},D有m条记录,每条记录具有n个特征,可将其理解为一个列向量,将数据和特征均展开是一个矩阵形式。

标记:

- 样本的结果信息,有时也称为真实值,常用y表示

如:一个西瓜 ((色泽 = 青绿;根蒂 = 蜷缩; 敲声 = 浊响),好瓜),其中好瓜就是标记

样例:

- 有了标记信息的示例

- 形式:数据 (x,y)

如:一个西瓜 ((色泽 = 青绿;根蒂 = 蜷缩; 敲声 = 浊响),好瓜)

样本空间:

- 属性形成的空间称为属性空间、样本空间、或输入空间。

一个属性对应一个维度,比如把姓名作为x轴,性别作为y轴,专业形成z轴,就形成了一个描述人的样本空间。每个人都可以在这个空间中找到自己的坐标位置

标记空间

标记空间、输出空间:

一般地,用(xi,yi)表示第i个样例,其中 yi∈ Y 是示例xi的标记,Y是所有标记的集合,也称为标记空间或输出空间。

特征向量:

- 空间中的每个点对应一个坐标向量,因此我们也把一个示例称为一个特征向量。

维数:

- 每个示例或样本的属性的个数。

例如:张三的例子,有三个属性,维度就是3。

学习、训练:

- 从数据中学得模型的过程,这个过程通过执行某个学习算法来完成。

训练数据:

- 训练过程中使用的数据。

训练样本:

- 训练过程中使用的每个样本都称为一个训练样本

训练集:

训练样本组成的集合

假设

学得模型对应了关于数据的某种潜在的规律,这种潜在规律自身,则称为“真相”或“真实”,学习过程就是为了找出或逼近真相

学习器:

模型,也可看作算法咋给定数据和参数空间上的实例化

分类:

- 学习任务想要预测的是离散值,比如好瓜、坏瓜,则此分类任务称为分类

- 二分类任务:

只涉及两个类别的分类任务,通常称其中一个为正例,另一个为反例 - 多分类任务:

涉及多个类别的分类任务

回归:

- 学习任务将要预测的是连续值,比如西瓜的甜度,0.92,0.84,0.48等等。

测试:

- 学得模型之后,使用该模型进行预测的过程即为测试

测试样本:

- 在测试过程中,被预测的样本称为测试样本

聚类:

- 将训练集中的西瓜分成若干组,每组称为一个“簇”;这些自动形成的簇可能对应一些潜在的概念划分,例如对西瓜来说,出现的浅色瓜、深色瓜,本地瓜,外地瓜等未在样本的属性中出现的概念。

- 在聚类学习中,潜在的概念我们事先未知,学习过程中使用的训练样本通常不具有标记信息。

学习任务分类:(大致可分为两大类)

- 监督学习:

代表:分类和回归 - 无监督学习:

代表:聚类

泛化能力:

- 学得模型适用于新样本的能力

三、假设空间

假设空间:

顾名思义,就是所有假设组成的空间。

假设的表示一旦确定,假设空间及其规模大小就确定了。

我们可以把学习过程看做一个在所有假设组成的空间中进行搜索的过程,搜索目标是找到与训练集“匹配”的假设,既能够将训练集中的样本判断正确的假设。

在一个样本训练集中,一个西瓜样本的形式如下

西瓜 ((色泽 ;根蒂; 敲声),好瓜)

假如每个属性有三种取值,则假设空间大小=3x3x3

但是要考虑到一个属性无论取何值都可以的可能,这里用通配符 “ * ” 表示,此时大小等于4x4x4

还要考虑到,没有好瓜这个概念,即为空集,用∅表示,则大小共为 4x4x4+1

很多策略都可以对这个假设空间进行搜索,如自顶向下、从一般到特殊、或是自底向上、从特殊到一般,搜索过程中可以不断删除与正例不一致的假设、和与反例一致的假设。最终将会获得与训练集一致(即能够对所有训练样本能够进行正确判断)的假设,这就是我们学得的结果。

需要注意的是:

在现实问题中我们经常面临很大的假设空间,但是学习过程是基于有限样本训练集进行的,因此可能有多个假设与训练集一致,即存在着一个与训练集一致的“假设集合”,我们称之为“版本空间”。

四、归纳偏好

归纳偏好:

机器学习算法在学习过程中,对某种类型假设的偏好,称为“归纳偏好”,或简称为“偏好”。

对于某些训练样本,无法断定哪个假设“更好”。然而对一个具体的算法而言,必须产生一个具体的模型。此时学习算法本身的“偏好”就会起到关键作用。

任何一个有效的机器学习算法必有其归纳偏好,否则他将被假设空假中看似在训练集上“等效”的假设所迷惑,从而无法产生确定的学习效果。

归纳偏好可看做学习算法自身在一个可能很庞大的假设空间中对假设进行选择的启发式或“价值观”。

- 其中,“奥卡姆剃刀”是一种常用的、自然科学研究中最基本的原则,即“若有多个假设与观察一致,则选择最简单的那个”。

- 然而,奥卡姆剃刀并未唯一可行的原则。而且,奥卡姆剃刀本身存在不同的诠释,使用原则并不平凡。如:对于某个问题的两个假设,其中哪个假设更简单?这个问题本身就不简单。需要借助其他的机制才能解决。

事实上,归纳偏好对应了学习算法本身所做出的关于“什么样的模型更好的假设”。在具体的现实问题中,这个假设是否成立,即算法的归纳偏好是否与问题本身匹配,大多数时候直接决定了算法能否取得好的性能。

给出两个学习算法(一个聪明,一个笨拙),根据数学推导(此处省略,详见《机器学习》周志华,p8),其训练集外的所有样本的总误差与学习算法无关。即:无论两个学习算法差距多大,他们的期望性能相同。这就是“没有免费的午餐”定理(NoFree Lunch Theorem,简称NFL定理)。

没有免费的午餐”定理有一个重要前提:所有问题出现的计划相同、或所有问题同等重要。但是实际情形并不是这样,很多事候,我们只关注自己正在试图解决的问题,至于这个问题在其他方面是否为好方案,我们并不关心。

“没有免费的午餐”定理最重要的寓意,让我们认识到,脱离具体问题去谈“什么学习算法更好”毫无意义。要谈论算法的相对优劣,必须针对具体的学习问题。学习算法自身的归纳偏好与问题是否相匹配,往往会起到决定作用。

总结

本章主要讲解了一些机器学习中基础的概念,其中基本术语需要注意,以及数据集的格式,在以后理解和编写代码时会更容易。

转载请标明出处,本篇文章允许转载,禁止抄袭