首先,去Flume官网下载最新的版本

这里我使用的是apache-flume-1.6.0-bin.tar.gz

开发环境

系统:window7

Jdk:1.7

Flume:1.6.0

Hadoop:2.5.2

一、下载flume并解压安装配置

下载解压到你想要的目录

配置环境变量

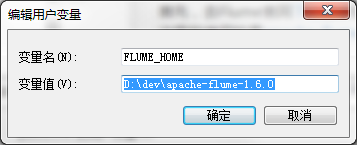

新建FLUME_HOME变量,填写flume安装目录,如图

然后编辑系统变量path,追加%FLUME_HOME%\conf; %FLUME_HOME%\bin;修改flume下conf文件夹中的flume-env.sh(如果没有就复制一份flume-env.sh.template,改名为flume-env.sh)

中的JAVA_HOME,指定jdk安装路径

如:export JAVA_HOME=D:\java\jdk测试是否安装成功

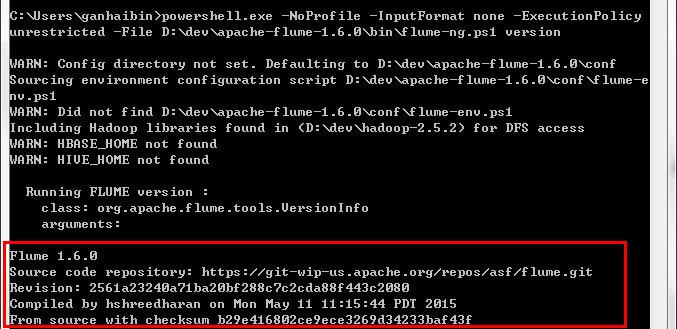

cmd进入命令窗口,输入

flume-ng version如果安装成功,会出现如图的版本号。

二、测试实例

1. 数据源为avro ,使用telnet连接source写入数据,产生日志数据输出控制台。

①在conf文件夹中创建example.conf文件,写入

# example.conf: A single-node Flume configuration

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost

a1.sources.r1.port = 44444

# Describe the sink

a1.sinks.k1.type = logger

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1②打开cmd,切到conf目录下,输入命令启动flume

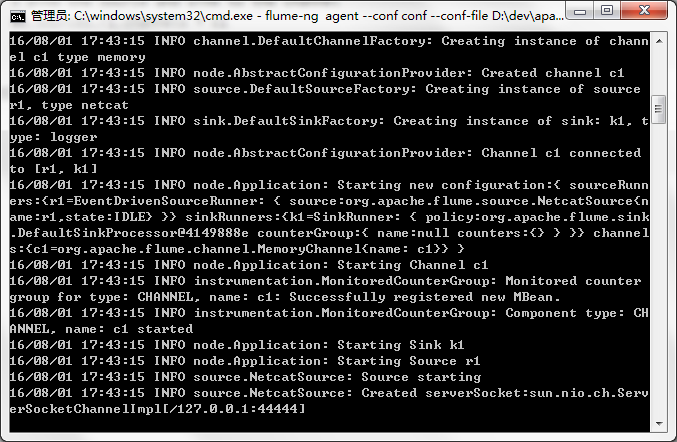

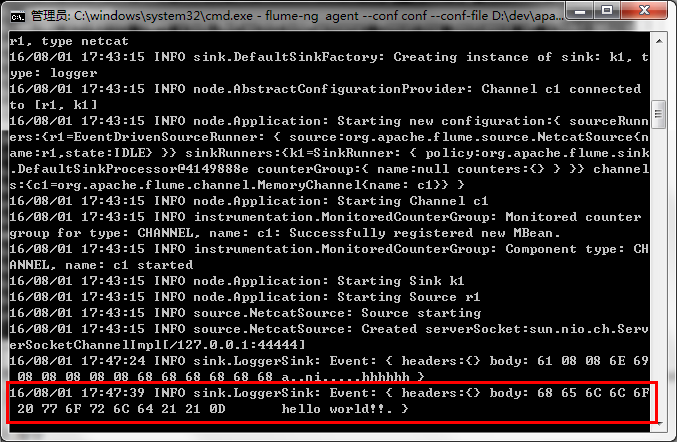

flume-ng agent --conf conf --conf-file example.conf --name a1 启动成功,如图所示,弹出一个小黑框

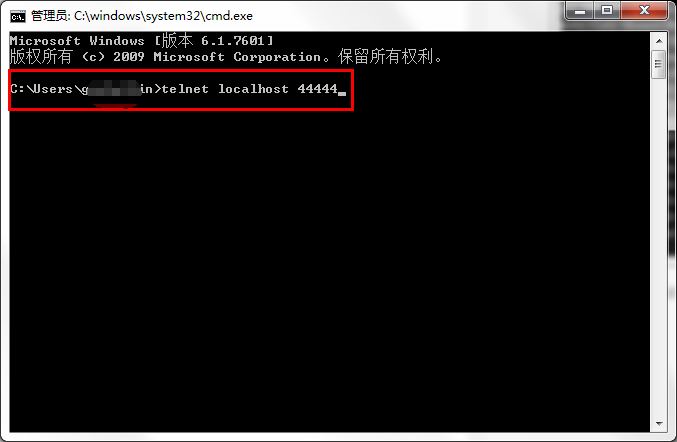

③再打开一个cmd命令窗口,使用telnet命令,写入些数据,让flume检测。(如果windows还没开启telnet服务,请戳这开启服务)

输入指令

输入helloworld

观察flume的小黑窗,已经监控到有数据访问,并输出。

2. 数据源为avro ,监控log4j日志输出,并写入hdfs当中

①启动hadoop服务,如果还没搭建的小伙伴可以点击这查看windows如何搭建hadoop服务。

②新建Java Project项目,我这里使用maven构建项目,为了方便引入log4j依赖。

③引入log4j.jar包依赖和flume相关依赖

pom.xml

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.17</version>

</dependency>

<dependency>

<groupId>org.apache.flume</groupId>

<artifactId>flume-ng-core</artifactId>

<version>1.5.0</version>

</dependency>

<dependency>

<groupId>org.apache.flume.flume-ng-clients</groupId>

<artifactId>flume-ng-log4jappender</artifactId>

<version>1.6.0</version>

</dependency> ④配置log4j.properties,如下

### set log levels ###

log4j.rootLogger=INFO, stdout, file, flume

log4j.logger.per.flume=INFO

### flume ###

log4j.appender.flume=org.apache.flume.clients.log4jappender.Log4jAppender

log4j.appender.flume.layout=org.apache.log4j.PatternLayout

log4j.appender.flume.Hostname=localhost

log4j.appender.flume.Port=44444

### stdout ###

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.Threshold=INFO

log4j.appender.stdout.Target=System.out

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %c{1} [%p] %m%n

### file ###

log4j.appender.file=org.apache.log4j.DailyRollingFileAppender

log4j.appender.file.Threshold=INFO

log4j.appender.file.Append=true

log4j.appender.file.DatePattern='.'yyyy-MM-dd

log4j.appender.file.layout=org.apache.log4j.PatternLayout

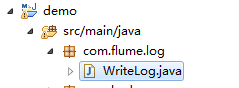

log4j.appender.file.layout.ConversionPattern=%d{yyyy-MM-dd HH:mm:ss} %c{1} [%p] %m%n⑤新建WriteLog.java 类

package com.flume.log;

import java.util.Date;

import org.apache.log4j.Logger;

public class WriteLog {

protected static final Logger logger = Logger.getLogger(WriteLog.class);

public static void main(String[] args) throws Exception {

while (true) {

logger.info("hello world:"+ String.valueOf(new Date().getTime()));

Thread.sleep(2000);

}

}

}⑥在flume安装目录下的conf新建example-hdfs.conf,如下

a1.sources=source1

a1.channels=channel1

a1.sinks=sink1

a1.sources.source1.type=avro

a1.sources.source1.bind=0.0.0.0

a1.sources.source1.port=44444

a1.sources.source1.channels=channel1

a1.channels.channel1.type=memory

a1.channels.channel1.capacity=10000

a1.channels.channel1.transactionCapacity=1000

a1.channels.channel1.keep-alive=30

a1.sinks.sink1.type=hdfs

a1.sinks.sink1.channel=channel1

# 指定了我的flume日志目录,还没创建请先行创建

a1.sinks.sink1.hdfs.path=hdfs://localhost:9000/user/flume

a1.sinks.sink1.hdfs.fileType=DataStream

a1.sinks.sink1.hdfs.writeFormat=Text

a1.sinks.sink1.hdfs.rollInterval=0

a1.sinks.sink1.hdfs.rollSize=10240

a1.sinks.sink1.hdfs.rollCount=0

a1.sinks.sink1.hdfs.idleTimeout=60 ⑦运行flume服务

cmd切到conf目录下,运行指令

flume-ng agent --conf conf --conf-file example-hdfs.conf --name a1 ⑧运行WriteLog.java

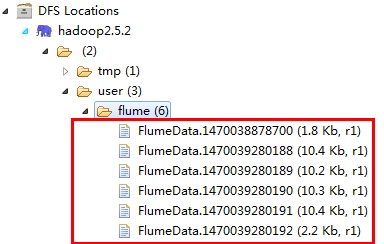

当日志写满10k,flume自动新建另一个日志文件继续写入,最终效果图。

完毕。