常见的矩阵范数有L1,L2,

L0

,

L1

向量范数

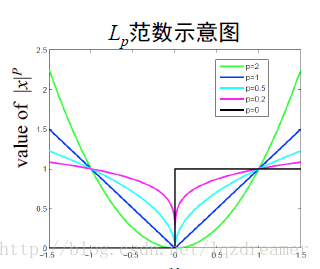

L0 范数L0 范数是指向量v 中的非0的个数,是一种度量向量稀疏性的表示方法。例如:v=[0,1,1,0,0,1] ,那么∥v∥0=3 。L1 范数

L1 范数是向量中元素的绝对值之和,即∥v∥1=∑ni=1|vi| ,也描述了向量的稀疏性。

从图中可以看出,

矩阵的

L1

范数

为了度量稀疏矩阵的稀疏性,则定义矩阵的一种范数,为:

即为矩阵所有元素的绝对值之和,能够描述接矩阵的稀疏性,但是在优化时,难度较大,是将情况向矩阵中元素尽可能是0的方向优化。

矩阵的

L2,1

范数

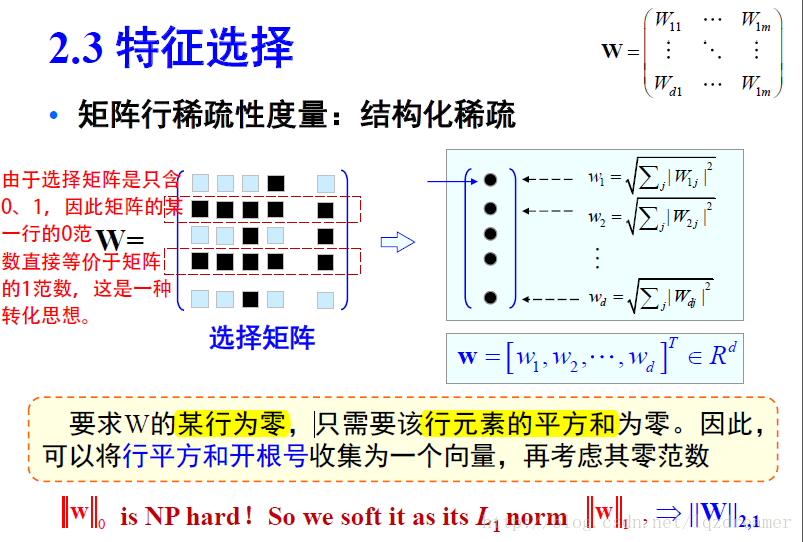

而为了进一步说明矩阵的稀疏性,来说明特征选择中矩阵

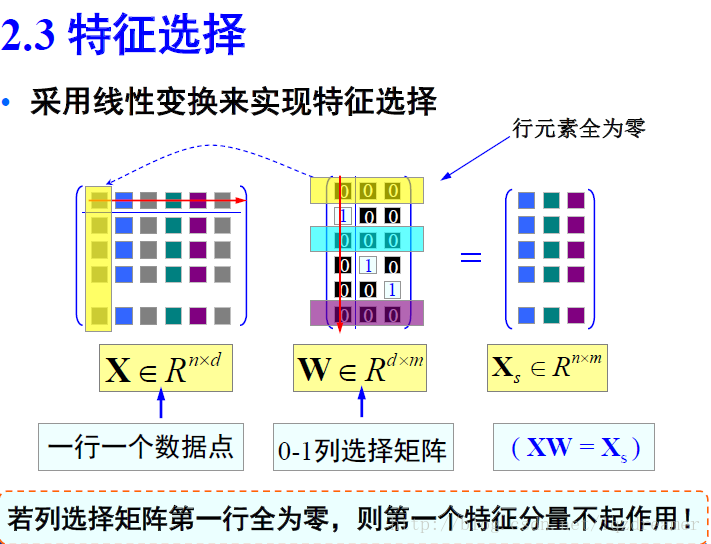

在特征选择中,通过稀疏化的特征选择矩阵来选取特征,即相当于是一种线性变换。

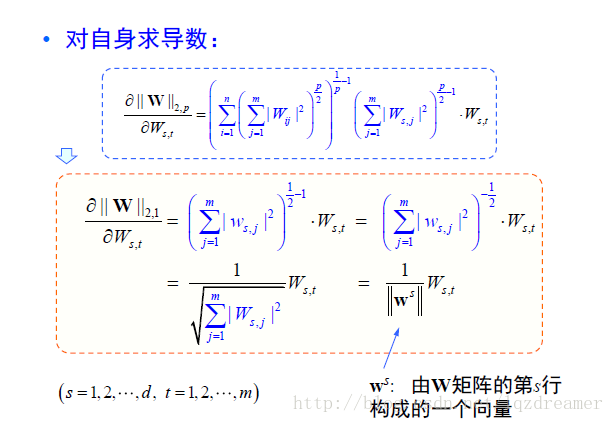

矩阵

L2,1

范数的求导

对于特征选择矩阵

这便是矩阵的

那么,在线性学习模型,损失函数如:

在优化中,矩阵的范数该如何求导?关于矩阵的F范数求导,可以参考 矩阵的 Frobenius 范数及其求偏导法则。而矩阵

首先,先证明一个向量求导的问题,其中

那么,可得向量的求导为

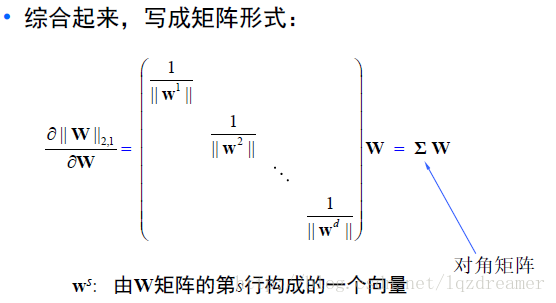

而对于一个矩阵

那么:

这即是矩阵

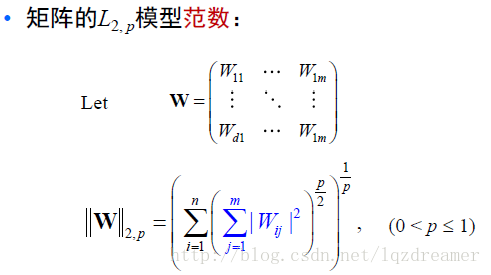

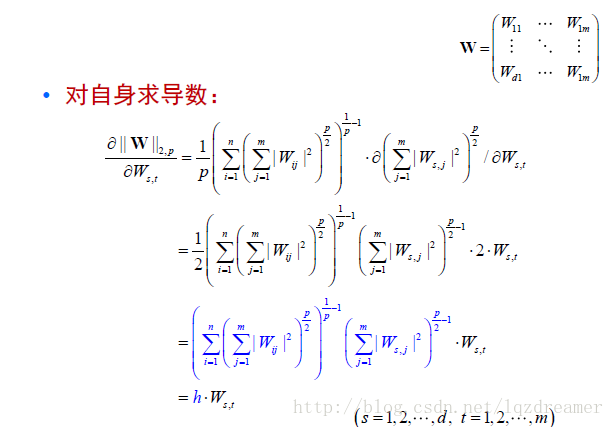

矩阵一般化

L2,P

范数的求导

而向老师就矩阵一般化

关于矩阵的求导,是机器学习的一个数学难点,需要好好积累数学理论知识!