文章链接:http://papers.nips.cc/paper/5423-generative-adversarial-nets.pdf

这是Goodfellow的scholar主页,没看过的可以去膜拜一下。https://scholar.google.ca/citations?user=iYN86KEAAAAJ

与GAN相关的最新的推荐文章:

Unsupervised and Semi-supervised Learning with Categorical Generative Adversarial Networks

Semi-Supervised Learning with Generative Adversarial Networks

Semi-supervised Knowledge Transfer for Deep Learning from Private Training Data

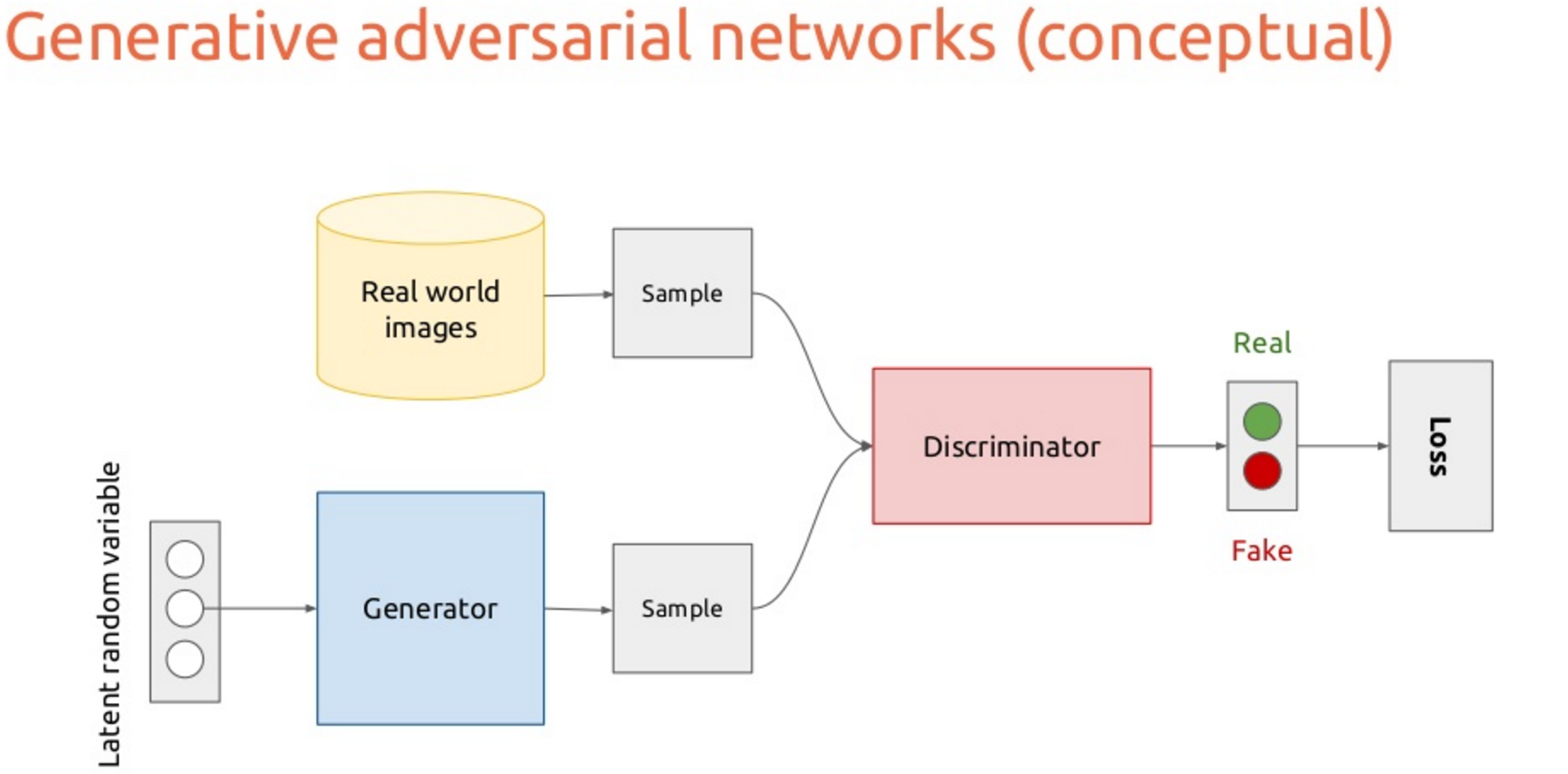

在这篇文章中,作者提出了一种新的生成模型的计算过程,从而能够回避一些生成模型所面临的困境。所提出的生成对抗网络同时训练两个模型:生成模型G和判别模型D。对G的训练的目标是 使得D犯错的概率最大。对D的训练目标是使得其能够判别一个样本是来自生成模型还是真实数据。稍微有点绕,文中作者做了一个比喻,有助于理解。生成模型G存在一个对手,即判别模型D,可将G类比为一个伪造货币的团队,他们试图生产假的货币,并且使用这些货币而不被警察发现,而D则可类比为警察,他们要查出这些伪造的货币。最后的竞争结果直到伪造者(G)造出警察(D)无法判别真假的货币为止。当G和D两者都是多层感知机的时候,即称为对抗网络(adversarial nets)。

图1 训练过程理解

图一是对 对抗网络训练过程的通俗理解。图中的蓝色虚线是判别器D,绿色实现是生成模型G的分布P(G),黑色点画线是真实数据生成分布Px,下方的两个横线表示x=G(z)这个将噪声映射到x的趋势。从(a)到(d)可以看到,随着训练迭代,G的分布越来越接近真实数据,而D最后无法区分G和真实数据,变成一个定值0.5。训练目标是:

第一项是D的训练目标,最大化正确分类的判别概率,第二项是G的最小化训练目标。在实际操作的时候,G训练为最大化

转自 https://blog.csdn.net/zixiximm/article/details/53284559