问题的提出

现要实现一个简单的线性回归:

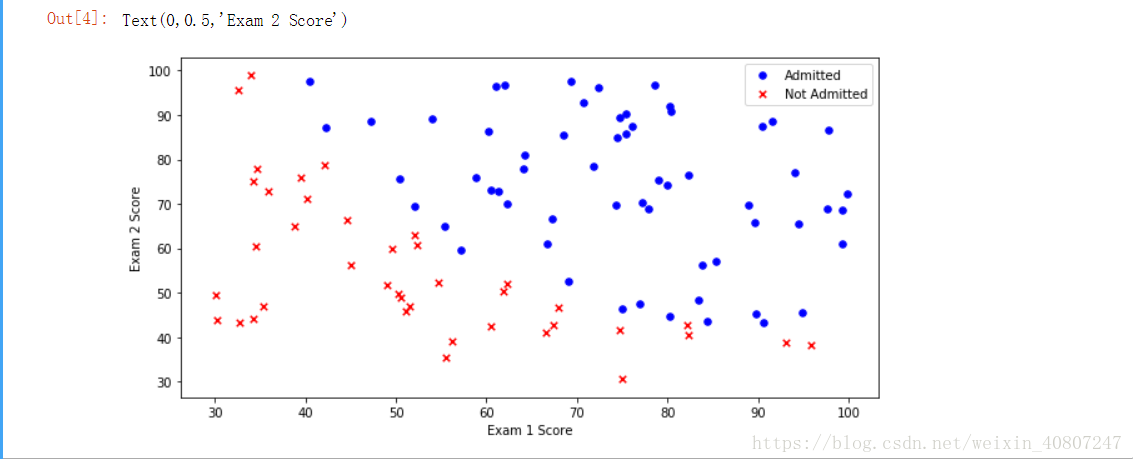

我们将建立一个逻辑回归模型来预测一个学生是否被大学录取。假设你是一个大学系的管理员,你想根据两次考试的结果来决定每个申请人的录取机会。你有以前的申请人的历史数据,你可以用它作为逻辑回归的训练集。对于每一个培训例子,你有两个考试的申请人的分数和录取决定。为了做到这一点,我们将建立一个分类模型,根据考试成绩估计入学概率。

即要求我们通过一些数据集来训练电脑,能实现输入两门考试成绩从而得到是否录取的结果。

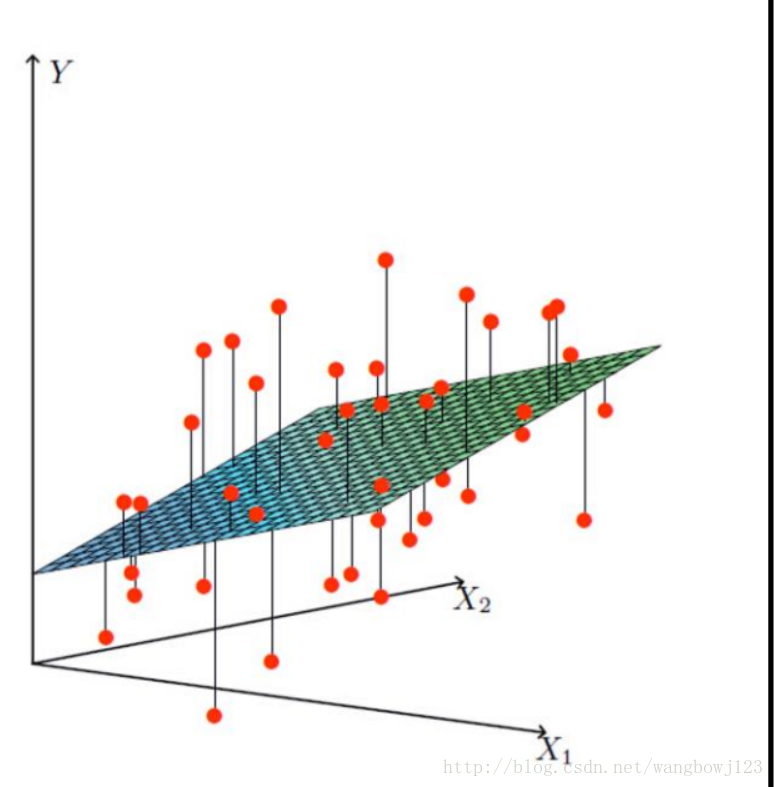

设X1为exam1的成绩,X2为exam2的成绩,X1、X2就是我们的两个特征,我们的目标便是求得一条曲线,能最大程度拟合我们的数据点(X1、X2轴),而曲线的Y值便是我们的预测值。其实就是个立体的曲线,图例如下:

载入数据集

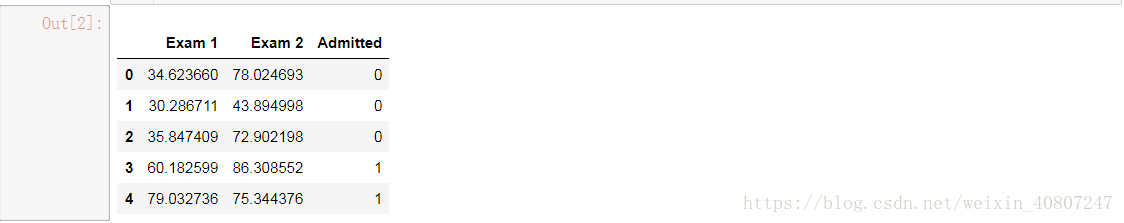

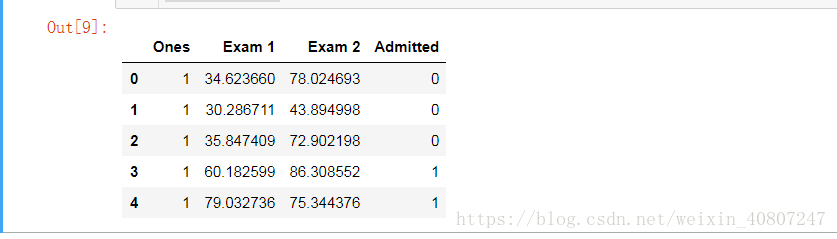

我们首先载入数据集看看数据特征与数据项:

#导入数据分析的三大件

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

%matplotlib inlineimport os

# 相对路径

# # 在 Windows 上,文件的路径分割符号是 '\' ,

# 在 Linux 上 是 ‘/’为了让你的代码在不同的平台上都能运行,那么你写路径的时候是写 ‘/’ 还是写 '\' 呢?

# 为了让你的代码在不同的平台上都能运行,那么你写路径的时候是写 ‘/’ 还是写 '\' 呢?

# 使用 os.sep 的话,你就不用去考虑这个了,os.sep 根据你所处的平台,自动地采用相应的分割符号

path = 'data' + os.sep + 'LogiReg_data.txt'

pdData = pd.read_csv(path, header=None, names=['Exam 1', 'Exam 2', 'Admitted'])

pdData.head()结果如图:

可以看到学生有两门成绩,学校是通过两门成绩来决定是否录取。

之后我们可以利用python的绘图包通过散点图的绘制来将数据更直接的表现出来。

# 画出正例 负例的散点图

positive = pdData[pdData['Admitted'] == 1]

negative = pdData[pdData['Admitted'] == 0]

# 画图区域的长和宽

# fig代表绘图窗口(Figure),ax代表这个绘图窗口上的坐标系(axes)。后面的ax.xxx则是表示对ax坐标系进行xxx操作

#调用subplots函数

#指定图像分辨率、大小和长宽比例

#创建一个800*600像素、100dpi(每英寸100点)分辨率的图形

#返回一个画布对象和一个轴数组

# fig,axe=plt.subplots(figsize=(8,6),dpi=100)

fig, ax = plt.subplots(figsize=(10,5))

# 画散点图

ax.scatter(positive['Exam 1'], positive['Exam 2'], s=30, c='b', marker='o', label='Admitted')

ax.scatter(negative['Exam 1'], negative['Exam 2'], s=30, c='r', marker='x', label='Not Admitted')

ax.legend()

#设置X轴标记为Exam 1 Score

ax.set_xlabel('Exam 1 Score')

#设置Y轴标记为Exam 1 Score

ax.set_ylabel('Exam 2 Score')

#设置图标题

# axe.set_title("y=x**2")

#显示绘制的图片

# plt.show()

# 画图区域的长和宽

# fig代表绘图窗口(Figure),ax代表这个绘图窗口上的坐标系(axes)。后面的ax.xxx则是表示对ax坐标系进行xxx操作

#调用subplots函数

#指定图像分辨率、大小和长宽比例

#创建一个800*600像素、100dpi(每英寸100点)分辨率的图形

#返回一个画布对象和一个轴数组

# fig,axe=plt.subplots(figsize=(8,6),dpi=100)

fig, ax = plt.subplots(figsize=(10,5))#coding=utf8

'''

matplotlib.pyplot.subplots(nrows=1, ncols=1, sharex=False,

sharey=False, squeeze=True, subplot_kw=None,

gridspec_kw=None, **fig_kw)

创建一个画像(figure)和一组子图(subplots)。

这个实用程序包装器可以方便地在单个调用中创建子图的公共布局,包括封闭的图形对象。

输入参数说明:

nrows,ncols:整型,可选参数,默认为1。表示子图网格(grid)的行数与列数。

sharex,sharey:布尔值或者{'none','all','row','col'},默认:False

控制x(sharex)或y(sharey)轴之间的属性共享:

1.True或者'all':x或y轴属性将在所有子图(subplots)中共享.

2.False或'none':每个子图的x或y轴都是独立的部分

3.'row':每个子图在一个x或y轴共享行(row)

4.'col':每个子图在一个x或y轴共享列(column)

当子图在x轴有一个共享列时('col'),只有底部子图的x tick标记是可视的。

同理,当子图在y轴有一个共享行时('row'),只有第一列子图的y tick标记是可视的。

squeeze:布尔类型,可选参数,默认:True。

* 如果是True,额外的维度从返回的Axes(轴)对象中挤出。

》如果只有一个子图被构建(nrows=ncols=1),结果是单个Axes对象作为标量被返回。

》对于N*1或1*N个子图,返回一个1维数组。

》对于N*M,N>1和M>1返回一个2维数组。

*如果是False,不进行挤压操作:返回一个元素为Axes实例的2维数组,即使它最终是1x1。

subplot_kw:字典类型,可选参数。把字典的关键字传递给add_subplot()来创建每个子图。

gridspec_kw字典类型,可选参数。把字典的关键字传递给GridSpec构造函数创建子图放在网格里(grid)。

**fig_kw:把所有详细的关键字参数传给figure()函数

返回结果:

fig:matplotlib.figure.Figure对象

ax:Axes(轴)对象或Axes(轴)对象数组。

matplotlib.pyplot.figure(num=None, figsize=None, dpi=None,

facecolor=None, edgecolor=None, frameon=True,

FigureClass=<class 'matplotlib.figure.Figure'>, clear=False, **kwargs)

创建一个新的画布(figure)。

输入参数:

num:整型或者字符串,可选参数,默认:None。

如果不提供该参数,一个新的画布(figure)将被创建而且画布数量将会增加。

如果提供该参数,带有id的画布是已经存在的,激活该画布并返回该画布的引用。

如果这个画布不存在,创建并返回画布实例。

如果num是字符串,窗口标题将被设置为该图的数字。

figsize:整型元组,可选参数 ,默认:None。

每英寸的宽度和高度。如果不提供,默认值是figure.figsize。

dpi:整型,可选参数,默认:None。每英寸像素点。如果不提供,默认是figure.dpi。

facecolor:背景色。如果不提供,默认值:figure.facecolor。

edgecolor:边界颜色。如果不提供,默认值:figure.edgecolor。

framemon:布尔类型,可选参数,默认值:True。如果是False,禁止绘制画图框。

FigureClass:源于matplotlib.figure.Figure的类。(可选)使用自定义图实例。

clear:布尔类型,可选参数,默认值:False。如果为True和figure已经存在时,这是清理掉改图。

返回值:

figure:Figure。返回的Figure实例也将被传递给后端的new_figure_manager,这允许将自定义的图类挂接到pylab接口中。

附加的kwarg将被传递给图形init函数。

'''

import numpy as np

import matplotlib.pyplot as plt

#创建一个数组0-100,数据间隔是0.1

x=np.arange(0,100,0.1)

y=x**2

#调用subplots函数

#指定图像分辨率、大小和长宽比例

#创建一个800*600像素、100dpi(每英寸100点)分辨率的图形

#返回一个画布对象和一个轴数组

fig,axe=plt.subplots(figsize=(8,6),dpi=100)

#在axe上绘制一条抛物线,红色 点

axe.plot(x,y,"r:")

#设置y轴标记为X

axe.set_xlabel("X")

#设置x轴标记为Y

axe.set_ylabel("Y")

#设置图标题

axe.set_title("y=x**2")

#显示绘制的图片

plt.show()

Python有很多可视化工具,matplotlib是其中重要的一个。

matplotlib API函数都位于matplotlib.pyplot模块中,其通常的引入约定是:

import matplotlib.pyplot as plt

matplotlib的图像都位于Figure对象中,创建新的Figure方法为:

fig = plt.figure()

绘图不能直接在空Figure上,需要用add_subplot创建一个或多个subplot:

ax1 = fig.add_subplot(2,2,1)

ax2 = fig.add_subplot(2,2,2)

ax3 = fig.add_subplot(2,2,3)

参数的意思是图像是 2x2 的,当前选中的是4个subplot中的第n个

当需要创建多个subplot时,有更为简单方便的方法,参数sharex,sharey表示制定的多个subplot具有相同的X轴和Y轴:

fig, axes = plt.subplots(2,3,sharex=True,sharey = True)

调整subplot周围的间距:

plt.subplots_adjust(wspace = 0,hspace = 0)

设置绘图的颜色、线型和标记(数据点):plot函数接收一组x和y坐标,还可以接收一个表示线型、颜色和标记的字符串缩写

ax.plot(x,y,'go--')

上面的例子中:g表示颜色,o表示标记,--表示线型,标记类型和线型必须放在颜色后面

设置刻度、标签和图例:设置x轴刻度

ax.set_xticks([0,250,500,750,1000])

设置x轴名称:

ax.set_xlabel('Stage')

设置图片标题:

ax.set_title('My first matplotlib plot')

添加图例:传入label参数

复制代码

ax.plot(randn(1000).cumsum(),'k',label = 'one')

ax.plot(randn(1000).cumsum(),'k--',label = 'two')

ax.plot(randn(1000).cumsum(),'k.',label = 'three')

ax.legend()

复制代码

最后,需要将图片显示出来:

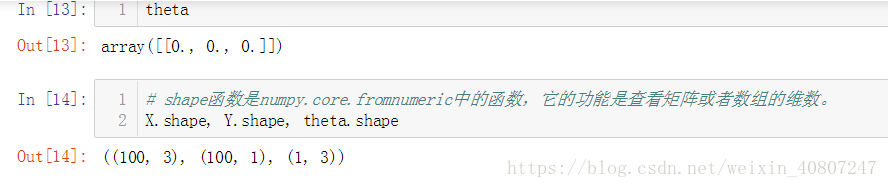

plt.show()python: numpy--函数 shape用法

建立一个3×3的单位矩阵e, e.shape为(3,3),表示3行3列,第一维的长度为3,第二维的长度也为3

>>> e = eye(3)

>>> e

array([[ 1., 0., 0.],

[ 0., 1., 0.],

[ 0., 0., 1.]])

>>> e.shape

(3, 3)

建立一个一维矩阵b, b.shape 为矩阵的长度

>>> b =array([1,2,3,4])

>>> b.shape

(4,)

#可以简写

>>> shape([1,2,3,4])

(4,)

>>>

建立一个4×2的矩阵c, c.shape[1] 为第一维的长度(也就是行数),c.shape[0] 为第二维的长度(列数)。

>>> c = array([[1,1],[1,2],[1,3],[1,4]])

>>> c.shape

(4, 2)

>>> c.shape[0]

4

>>> c.shape[1]

2

一个单独的数值,返回值为空

>>> shape(3)

()

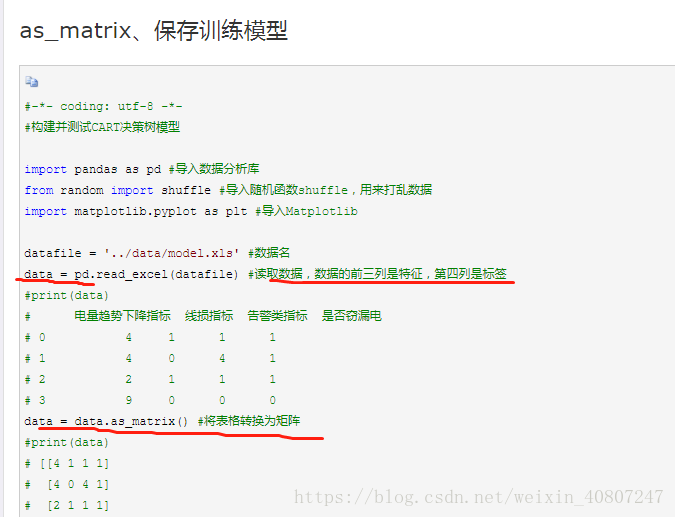

python: numpy--函数 as_matrix用法

zip()函数用法

zip()是Python的一个内建函数,它接受一系列可迭代的对象作为参数,将对象中对应的元素打包成一个个tuple(元组),然后返回由这些tuples组成的list(列表)。若传入参数的长度不等,则返回list的长度和参数中长度最短的对象相同。利用*号操作符,可以将list unzip(解压),看下面的例子就明白了:

|

|

初步求解

我们求解的线性关系一定是有参数的,因为我们有两个特征值,而我们需要通过两个特征值求得预测值,但是两个特征值对结果的影响又不尽相同,所以我们需要两个参数来度量两个特征值对结果影响程度,以及一个参数来充当偏置项(曲线会上下浮动,且偏置项对结果作用较小):

θ1、θ2、θ0

所以我们的预测结果可以表示为:

=θ0+θ1x1+θ2x2

整合之后:

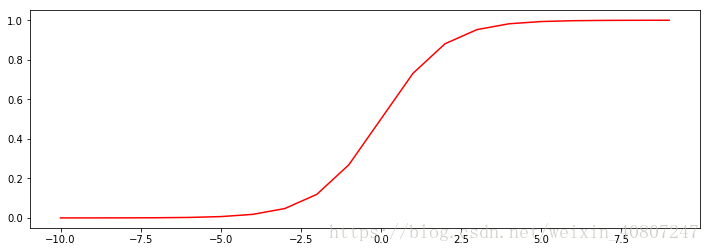

ef sigmoid(z):

return 1 / (1 + np.exp(-z))#注意e的指数次形式的写法

#creates a vector containing 20 equally spaced values from -10 to 10

nums = np.arange(-10,10,step=1)

fig, ax = plt.subplots(figsize=(12,4))

# ax.plot(x,y,'go--')

# 上面的例子中:g表示颜色,o表示标记,--表示线型,标记类型和线型必须放在颜色后面

ax.plot(nums,sigmoid(nums), 'r')

-

Python 基础——range() 与 np.arange()

-

range()返回的是range object,而np.arange()返回的是numpy.ndarray()range尽可用于迭代,而np.nrange作用远不止于此,它是一个序列,可被当做向量使用。 -

range()不支持步长为小数,np.arange()支持步长为小数 -

两者都可用于迭代

-

两者都有三个参数,以第一个参数为起点,第三个参数为步长,截止到第二个参数之前的不包括第二个参数的数据序列

某种意义上,和STL中由迭代器组成的区间是一样的,即左闭右开的区间。[first, last)或者不加严谨地写作[first:step:last) -

range(1,5) # range(1,5) tuple(range(1, 5)) # (1, 2, 3, 4) list(range(1, 5)) # [1, 2, 3, 4] r = range(1, 5) type(r) # range for i in range(1, 5): print(i) # 1 # 2 # 3 # 4 np.arange(1, 5) # array([1, 2, 3, 4]) # 'float' object cannot be interpreted as an integer range()不支持步长为小数 # range(1, 5, .1) # np.arange()支持步长为小数 np.arange(1, 5, .5) # array([1. , 1.5, 2. , 2.5, 3. , 3.5, 4. , 4.5]) range(1, 5, 2) # range(1, 5, 2) for i in range(1, 5, 2): print(i) # 1 3 for i in np.arange(1, 5): print(i)# 1 2 3 4

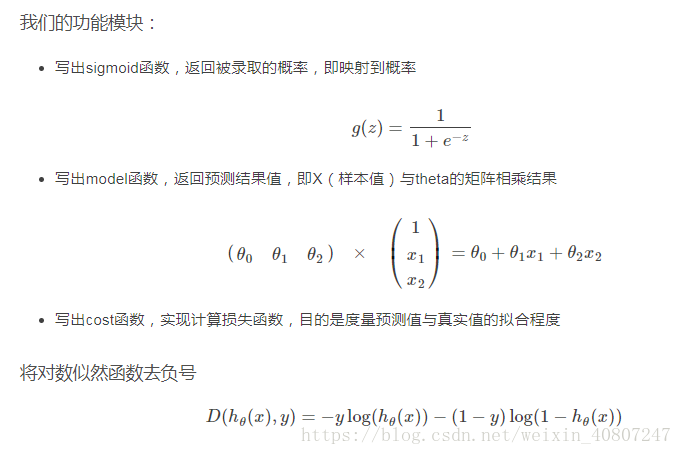

而所谓的逻辑回归便是将任意的输入值映射到[0,1]区间上,将我们通过线性回归得到的预测值转化为概率,完成分类任务。

初步求解

我们载入数据,大体明白了预测结果长什么样,以及值概率的转化,但我们的模型还完全没有建立起来!

我们知道所谓机器学习便是我们交给机器一堆数据,然后告诉它什么样的学习方式是对的(目标函数),叫它朝着这个方向走,然后还要规定每次走的步长(学习率),一口吃不了大胖子,要一步一步来(每次的迭代)。

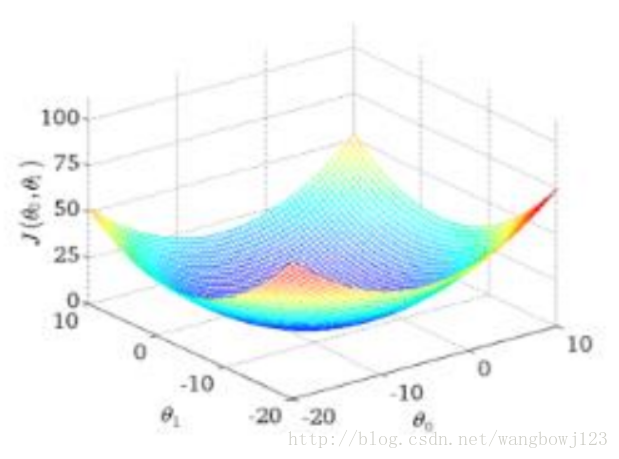

如同这样一个山谷,我们要达到山谷的最低点,利用梯度下降的方法,每经过一个数据点,便运行更新函数更新下一步的方向(梯度,求偏导)。

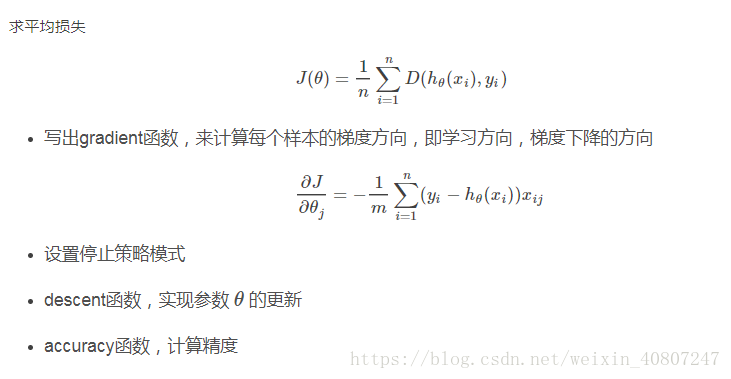

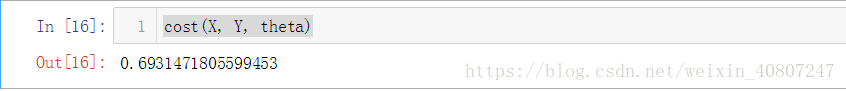

所以我们还要做损失函数(目标函数)、更新函数。

何为损失函数?

我们通过X来估计Y的值,预测值可能符合真实值,也可能不符合真实值,所以我们引入损失函数来度量拟合的程度,损失函数越小代表拟合的越好。

在此处我们暂时将损失函数视为目标函数。

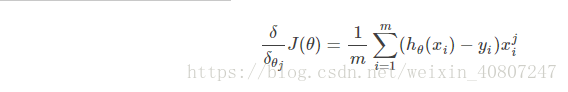

关于梯度下降

梯度下降便是在凸函数中沿着梯度下降的方向不断更新参数,一般情况下我们通过加负号实现。

梯度下降有三种方式实现:

-

1 批量梯度下降法(Batch Gradient Descent)

批量梯度下降法,是梯度下降法最常用的形式,具体做法也就是在更新参数时使用所有的样本来进行更新: -

-

由于我们有m个样本,这里求梯度的时候就用了所有m个样本的梯度数据。

-

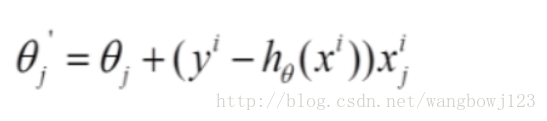

2 随机梯度下降法(Stochastic Gradient Descent)

随机梯度下降法,其实和批量梯度下降法原理类似,区别在与求梯度时没有用所有的m个样本的数据,而是仅仅选取一个样本j来求梯度。对应的更新公式是: -

-

随机梯度下降法,和批量梯度下降法是两个极端,一个采用所有数据来梯度下降,一个用一个样本来梯度下降。自然各自的优缺点都非常突出。对于训练速度来说,随机梯度下降法由于每次仅仅采用一个样本来迭代,训练速度很快,而批量梯度下降法在样本量很大的时候,训练速度不能让人满意。对于准确度来说,随机梯度下降法用于仅仅用一个样本决定梯度方向,导致解很有可能不是最优。对于收敛速度来说,由于随机梯度下降法一次迭代一个样本,导致迭代方向变化很大,不能很快的收敛到局部最优解。

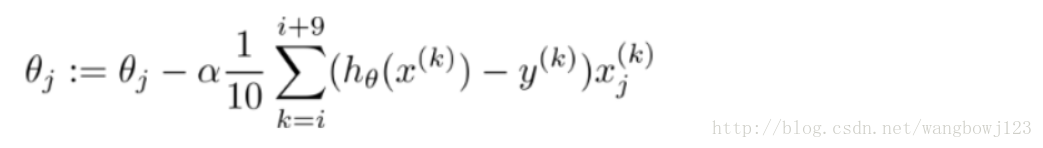

那么,有没有一个中庸的办法能够结合两种方法的优点呢?有!这就是小批量梯度下降法。 -

3 小批量梯度下降法(Mini-batch Gradient Descent)

小批量梯度下降法是批量梯度下降法和随机梯度下降法的折衷,也就是对于m个样本,我们采用x个样子来迭代。一般可以取x=10,当然根据样本的数据,可以调整这个x的值。对应的更新公式是: -

逻辑回归

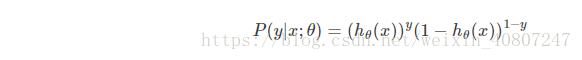

预测函数(完成值到概率的转化):

将分类任务整合进去:

即当我们的y取值为0或1时,可以得到较为精简的式子。

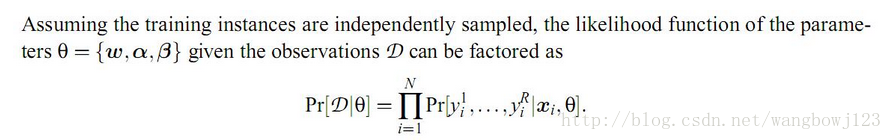

有了概率,我们便可以求似然函数了。

何为似然函数?

官方解释如下:

常说的概率是指给定参数后,预测即将发生的事件的可能性。而似然概率正好与这个过程相反,我们关注的量不再是事件的发生概率,而是已知发生了某些事件,我们希望知道参数应该是多少。

我们的似然函数定义如下:

即表示我们预测的参数满足所有样本值这一事件的概率,接下来要做的就是极大似然估计,即令参数的取值无限拟合我们的真实数据。

我们取对数似然,此时应用梯度上升求最大值,再引入目标函数转换为梯度下降求最小值(加负号,除以样本总数,考虑整体样本),求偏导,令其等于零。目标函数如下:

求偏导过程不再给出,结果如下:

代码如下:

#导入数据分析的三大件

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

%matplotlib inlineimport os

# 相对路径

# # 在 Windows 上,文件的路径分割符号是 '\' ,

# 在 Linux 上 是 ‘/’为了让你的代码在不同的平台上都能运行,那么你写路径的时候是写 ‘/’ 还是写 '\' 呢?

# 为了让你的代码在不同的平台上都能运行,那么你写路径的时候是写 ‘/’ 还是写 '\' 呢?

# 使用 os.sep 的话,你就不用去考虑这个了,os.sep 根据你所处的平台,自动地采用相应的分割符号

path = 'data' + os.sep + 'LogiReg_data.txt'

pdData = pd.read_csv(path, header=None, names=['Exam 1', 'Exam 2', 'Admitted'])

pdData.head()

# 画出正例 负例的散点图

positive = pdData[pdData['Admitted'] == 1]

negative = pdData[pdData['Admitted'] == 0]

# 画图区域的长和宽

# fig代表绘图窗口(Figure),ax代表这个绘图窗口上的坐标系(axes)。后面的ax.xxx则是表示对ax坐标系进行xxx操作

#调用subplots函数

#指定图像分辨率、大小和长宽比例

#创建一个800*600像素、100dpi(每英寸100点)分辨率的图形

#返回一个画布对象和一个轴数组

# fig,axe=plt.subplots(figsize=(8,6),dpi=100)

fig, ax = plt.subplots(figsize=(10,5))

# 画散点图

ax.scatter(positive['Exam 1'], positive['Exam 2'], s=30, c='b', marker='o', label='Admitted')

ax.scatter(negative['Exam 1'], negative['Exam 2'], s=30, c='r', marker='x', label='Not Admitted')

ax.legend()

#设置X轴标记为Exam 1 Score

ax.set_xlabel('Exam 1 Score')

#设置Y轴标记为Exam 1 Score

ax.set_ylabel('Exam 2 Score')

#设置图标题

# axe.set_title("y=x**2")

#显示绘制的图片

# plt.show()## The logistic regression

def sigmoid(z):

return 1 / (1 + np.exp(-z))#注意e的指数次形式的写法

#creates a vector containing 20 equally spaced values from -10 to 10

nums = np.arange(-10,10,step=1)

fig, ax = plt.subplots(figsize=(12,4))

# ax.plot(x,y,'go--')

# 上面的例子中:g表示颜色,o表示标记,--表示线型,标记类型和线型必须放在颜色后面

ax.plot(nums,sigmoid(nums), 'r')

# 预测函数模型

def model(X, theta):

return sigmoid(np.dot(X,theta.T))

# in a try / except structure so as not to return an error if the block si executed several times

# 给输入特征变量添加一列全1

pdData.insert(0, 'Ones', 1)

# pdData.head()

# 打印出来是原始表格里的数据

# print(pdData)

# 将数据的Pandas表示转换为可用于进一步计算的数组

# set X (training data) and y (target variable)

# 表格转换为矩阵

orig_data = pdData.as_matrix()

# 打印出来是矩阵形式

pdData.head()

# 样本维度

cols = orig_data.shape[1]

X = orig_data[:,0:cols-1]

Y = orig_data[:,cols-1:cols]

# 给参数占位

theta = np.zeros([1, 3])# 观察五个训练样本

X[:5]

# 平均损失 损失函数

def cost(X, Y, theta):

left = np.multiply(-Y, np.log(model(X, theta)))

right = np.multiply(1 - Y, np.log(1 - model(X, theta)))

return np.sum(left - right) / (len(X))cost(X, Y, theta)

# 计算梯度

def gradient(X, Y, theta):

# 进行一个占位 初始化grad

# 一维矩阵b, b.shape 为矩阵的长度

grad = np.zeros(theta.shape)

# 把H(0) - y

error = (model(X, theta) - Y).ravel()

for j in range(len(theta.ravel())):

term = np.multiply(error, X[:,j])

grad[0, j] = np.sum(term) / len(X)

return grad# Gradient descent

# 比较3中不同梯度下降方法

STOP_ITER = 0 #

STOP_COST = 1 # 根据损失函数

STOP_GRAD = 2 # 根据梯度

def stopCriterion(type, value, threshold):

# 设定三种不同的停止策略

if type == STOP_ITER: return value > threshold

# 最近两次损失值差别不大

elif type == STOP_COST: return abs(value[-1] - value[-2]) < threshold

elif type == STOP_GRAD: return np.linalg.norm(value) < thresholdimport numpy.random

# 数据要进行洗牌

def shuffleData(data):

np.random.shuffle(data)

cols = data.shape[1]

X = data[:, 0:cols - 1]

y = data[:, cols-1:]

return X, yimport time

def descent(data, theta, batchSize, stopType, thresh, alpha):

# 梯度下降求解

init_time = time.time()

# 迭代次数

i = 0

# batch

k = 0

X, y = shuffleData(data)

# 计算梯度

grad = np.zeros(theta.shape)

# 损失值

costs = [cost(X, y, theta)]

while True:

grad = gradient(X[k : k + batchSize], y[k : k + batchSize], theta)

# 取batch数量个数据

k += batchSize

#大于总数据

if k >= n:

k = 0

# 重新洗牌

X, y = shuffleData(data)

# 参数更新

theta = theta - alpha * grad

# 计算新的损失

costs.append(cost(X, y, theta))

i += 1

if stopType == STOP_ITER: value = i

elif stopType == STOP_COST: value = costs

elif stopType == STOP_GRAD: value = grad

if stopCriterion(stopType, value,thresh): break

return theta, i-1, costs, grad, time.time() - init_timedef runExpe(data, theta, batchSize, stopType, thresh, alpha):

# 总数据

n = 100

#import pdb; pdb.set_trace();

theta, iter, costs, grad, dur = descent(data, theta, batchSize, stopType, thresh, alpha)

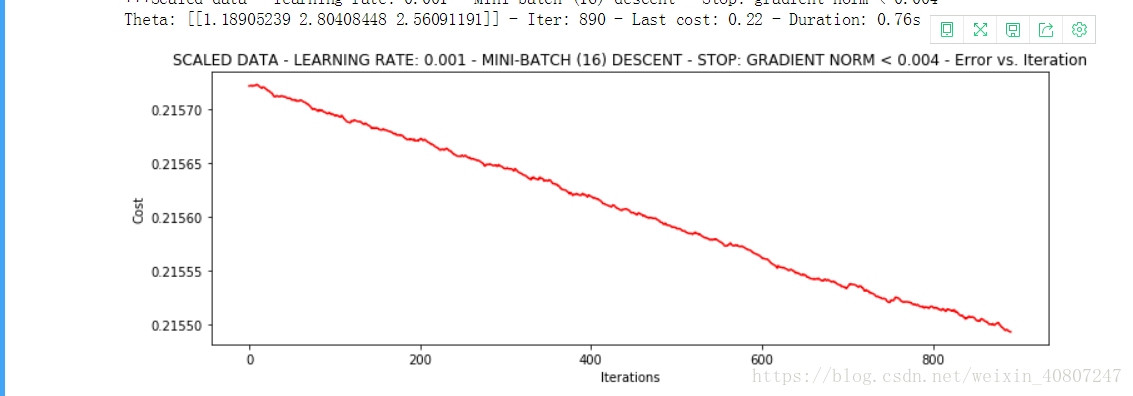

name = "Original" if (data[:,1]>2).sum() > 1 else "Scaled"

name += " data - learning rate: {} - ".format(alpha)

if batchSize == n: strDescType = "Gradient"

elif batchSize==1: strDescType = "Stochastic"

else: strDescType = "Mini-batch ({})".format(batchSize)

name += strDescType + " descent - Stop: "

if stopType == STOP_ITER: strStop = "{} iterations".format(thresh)

elif stopType == STOP_COST: strStop = "costs change < {}".format(thresh)

else: strStop = "gradient norm < {}".format(thresh)

name += strStop

print ("***{}\nTheta: {} - Iter: {} - Last cost: {:03.2f} - Duration: {:03.2f}s".format(

name, theta, iter, costs[-1], dur))

fig, ax = plt.subplots(figsize=(12,4))

ax.plot(np.arange(len(costs)), costs, 'r')

ax.set_xlabel('Iterations')

ax.set_ylabel('Cost')

ax.set_title(name.upper() + ' - Error vs. Iteration')

return theta# 不同的停止策略

# 设定迭代次数

#选择的梯度下降方法是基于所有样本的

n=100 # 数据总共100行

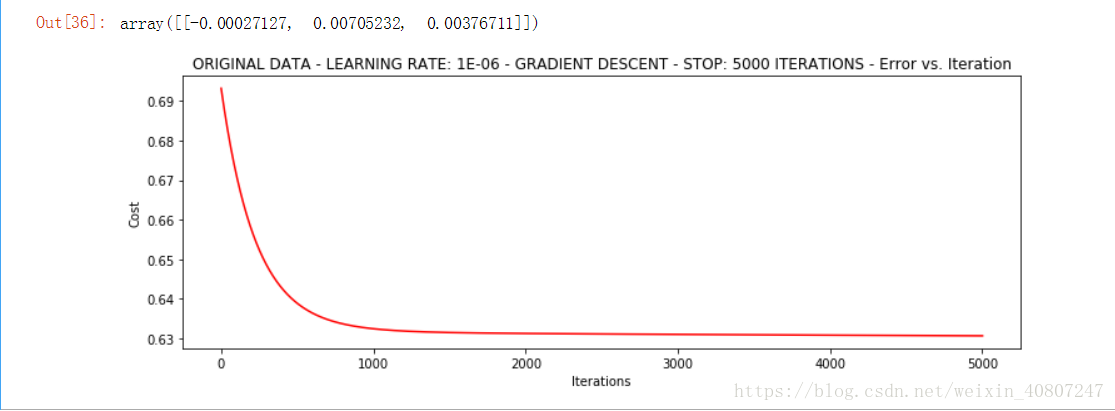

runExpe(orig_data, theta, n, STOP_ITER, thresh=5000, alpha=0.000001)# 根据损失值停止 按照损失函数的精度

# 设定阈值 1E-6, 差不多需要110 000次迭代

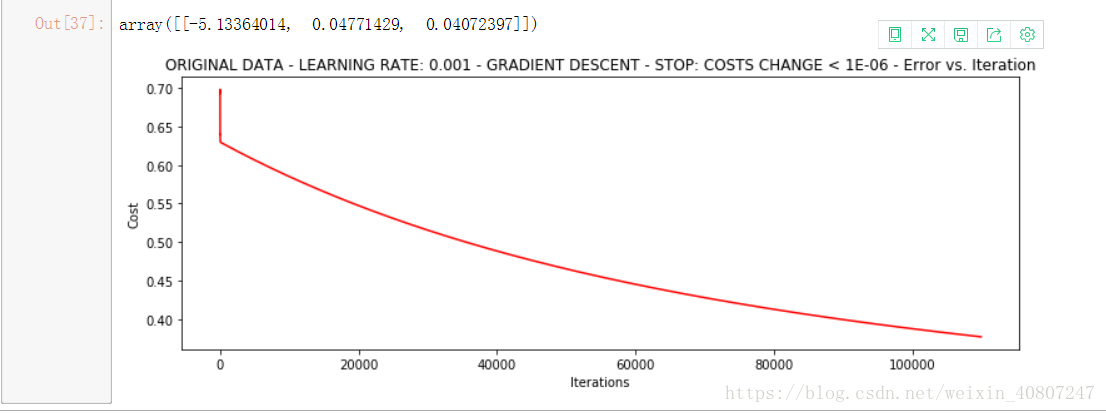

runExpe(orig_data, theta, n, STOP_COST, thresh=0.000001, alpha=0.001)# 根据梯度变化停止

# 设定阈值 0.05,差不多需要40 000次迭代

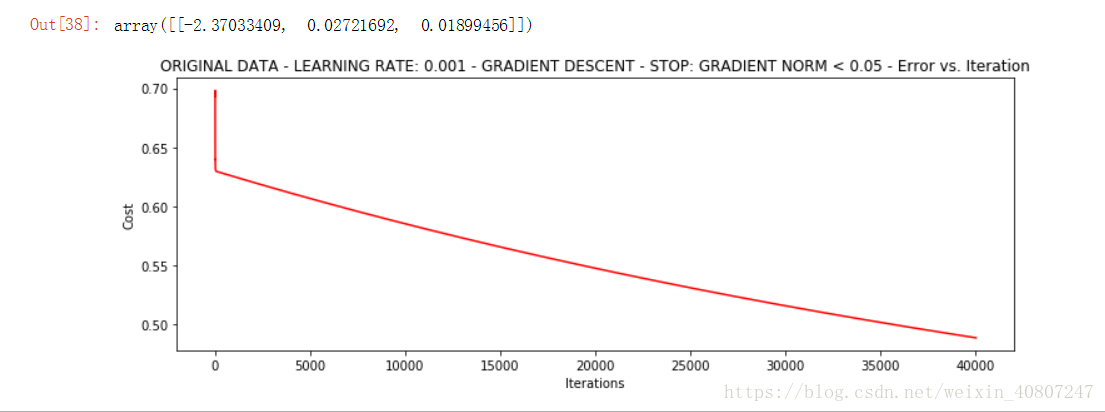

runExpe(orig_data, theta, n, STOP_GRAD, thresh=0.05, alpha=0.001)# 对比不同的梯度下降方法

# Stochastic descent

# 随机梯度下降(每次找一个样本,迭代速度快 但不一定每次朝着收敛的方向)

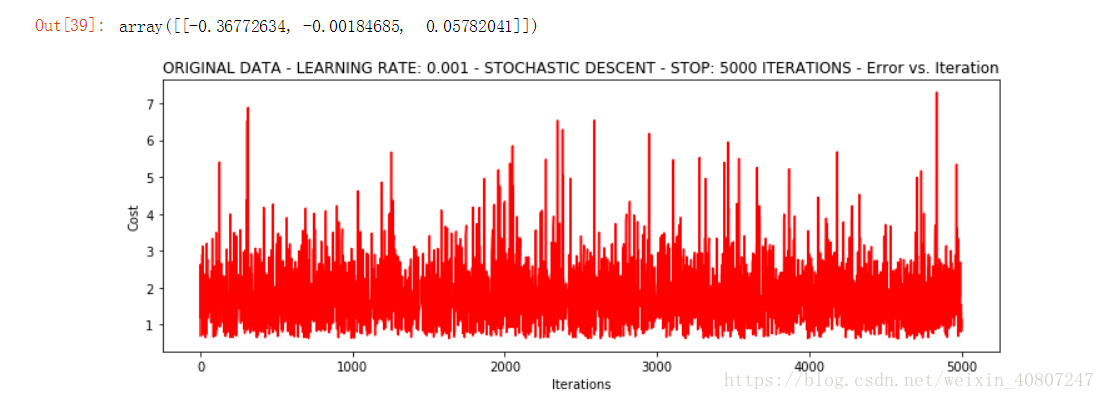

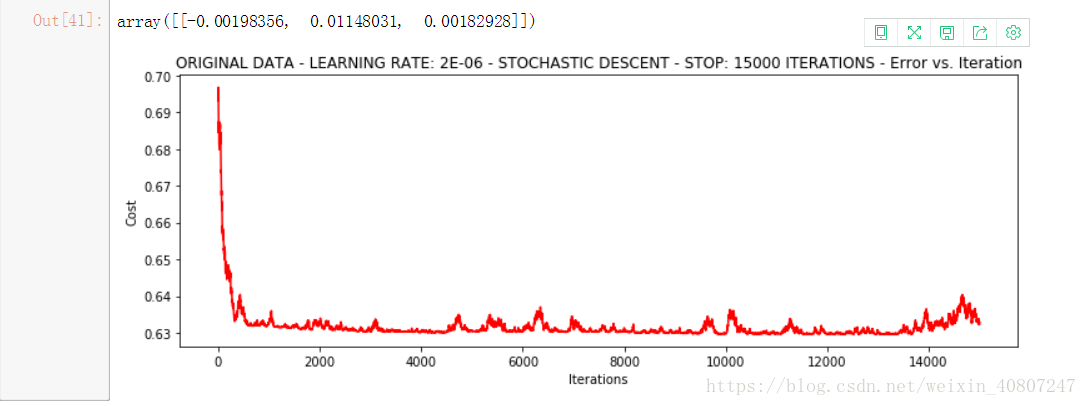

runExpe(orig_data, theta, 1, STOP_ITER, thresh=5000, alpha=0.001)# 有点爆炸。。。很不稳定,再来试试把学习率调小一些

# 速度快,但稳定性差,需要很小的学习率

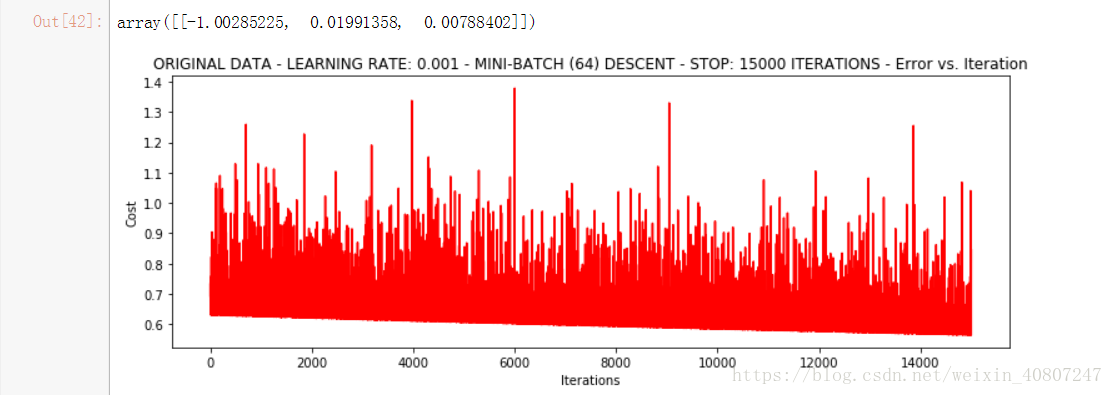

runExpe(orig_data, theta, 1, STOP_ITER, thresh=15000, alpha=0.000002)# Mini-batch descent

# 批量梯度下降

runExpe(orig_data, theta, 64, STOP_ITER, thresh=15000, alpha=0.001)# 浮动仍然比较大,我们来尝试下对数据进行标准化 将数据按其属性(按列进行)减去其均值,然后除以其方差。最后得到的结果是,对每个属性/每列来说所有数据都聚集在0附近,方差值为1

from sklearn import preprocessing as pp

import numpy as np

from sklearn.preprocessing import PolynomialFeatures

# 对数据进行标准化 将数据按其属性(按列进行)减去其均值,然后除以其方差

scaled_data = orig_data.copy()

# 将每一列特征标准化为标准正太分布,注意,标准化是针对每一列而言的

scaled_data[:,1:3] = pp.scale(orig_data[:,1:3])

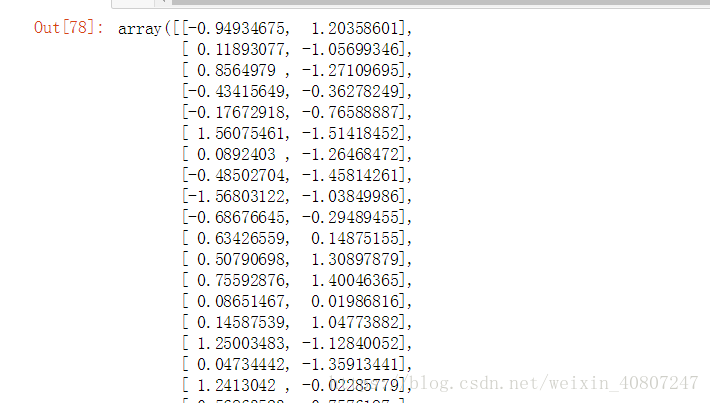

scaled_data[:,1:3]

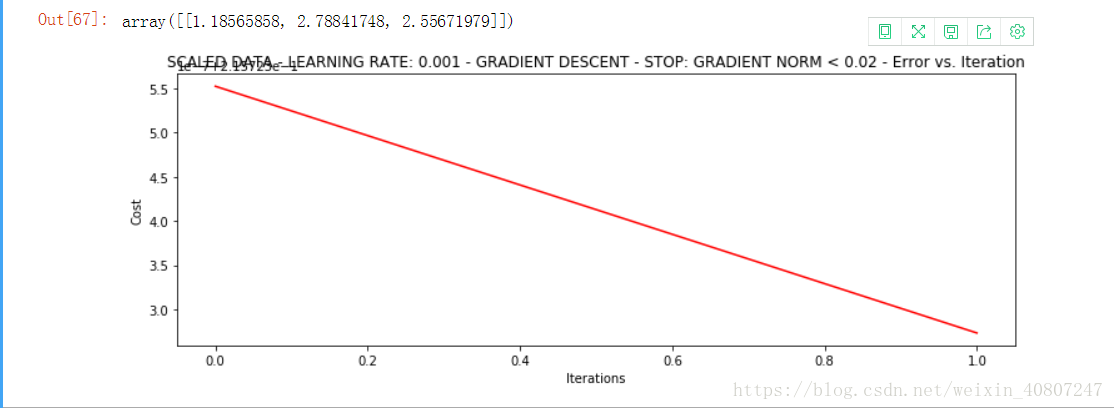

runExpe(scaled_data, theta, n, STOP_ITER, thresh = 5000, alpha = 0.001)# 它好多了!原始数据,只能达到达到0.61,而我们得到了0.38个在这里! 所以对数据做预处理是非常重要的

# 更多的迭代次数会使得损失下降的更多!

runExpe(scaled_data, theta, n, STOP_GRAD, thresh=0.02, alpha=0.001)# 随机梯度下降更快,但是我们需要迭代的次数也需要更多,所以还是用batch的比较合适!!!

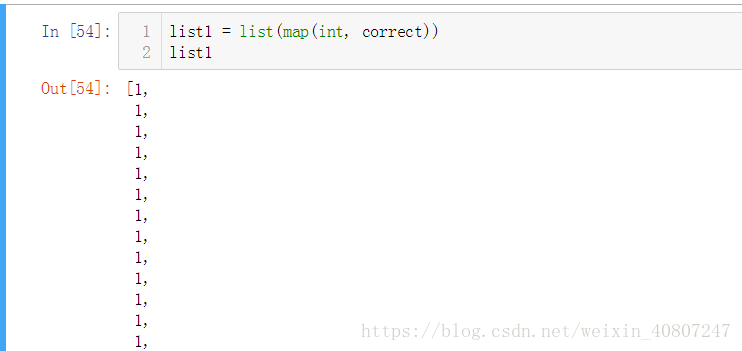

theta = runExpe(scaled_data, theta, 1, STOP_GRAD, thresh=0.002/5, alpha=0.001)theta = runExpe(scaled_data, theta, 16, STOP_GRAD, thresh=0.002*2, alpha=0.001)# 精度

#设定阈值0.5 大于0.5能录取 小于0.5pass

def predict(X,theta):

return [1 if x >= 0.5 else 0 for x in model(X, theta)]

scaled_X = scaled_data[:,:3]

y = scaled_data[:,3]

predictions = predict(scaled_X, theta)

correct = [1 if ((a == 1 and b == 1) or (a == 0 and b == 0)) else 0 for (a, b) in zip(predictions, y)]

accuracy = (sum(map(int, correct)) % len(correct))

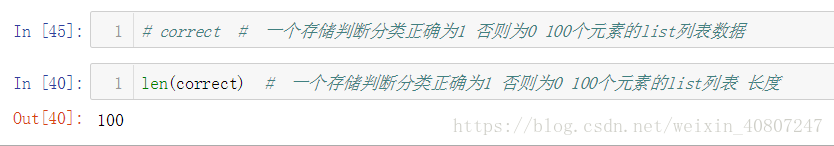

print('accuracy = {0}%'.format(accuracy))