我们之前学习了线性回归和logistic regression,为什么还要学习神经网络呢,首先给你一个直观的概念:

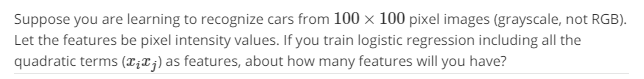

当特征变量过多时,使用线性回归(如二次多项式)可能会导致过拟合现象,同时随着特征变量项的增多(机器学习的n特征量一般都是很大的),计算量会逐渐增大。(如果你只考虑二次项,就会忽略很多相关项,拟合出来的边界线一般为椭圆什么的,不会符合想要的结果)。综上,我们需要从不同的角度来寻找新的算法。

一般机器学习的特征量很大,这里给出了一个直观的感受:比如说你要对汽车和非汽车分类,我们一般会提取图像的像素矩阵,其中如果是灰度矩阵的话,就有n=50*50=2500个特征值这里有一个选择题可供深入思考。

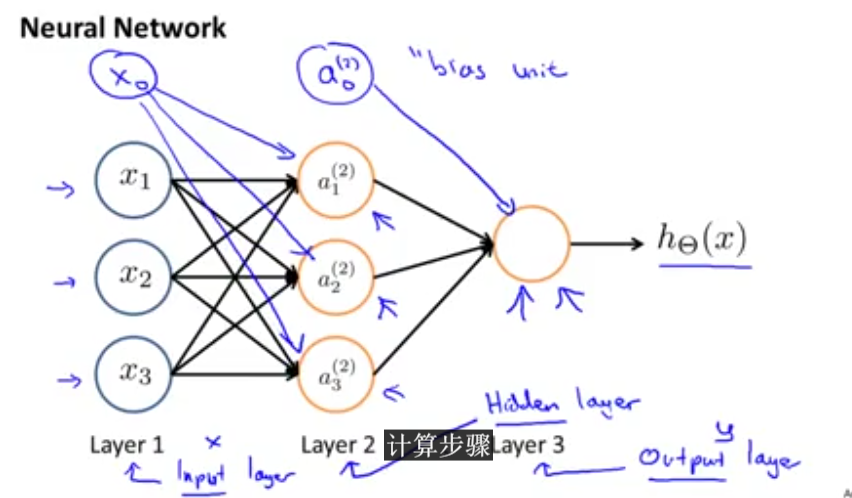

1.非线性分类器之神经网络

(1)背景

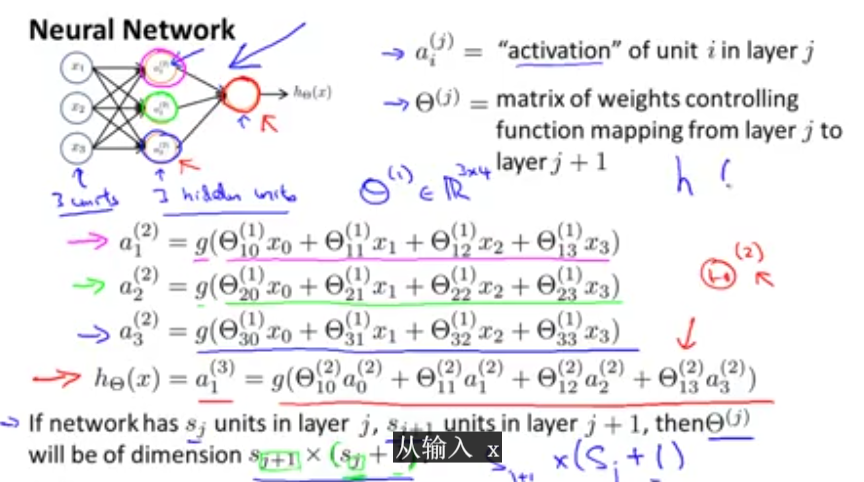

(2)计算

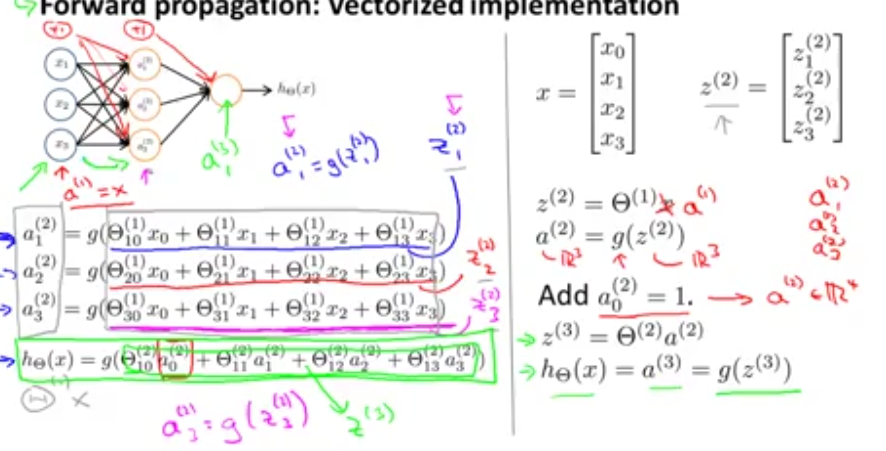

向量化:

计算过程计算实例

- 实例背景

二、神经网络系统介绍

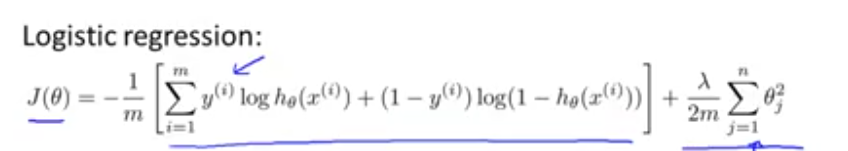

1.神经网络系统代价函数(cost function)

其中K表示输出的总数

神经网络的代价函数和逻辑回归的代价函数很相似,如下是逻辑回归函数的表达式:

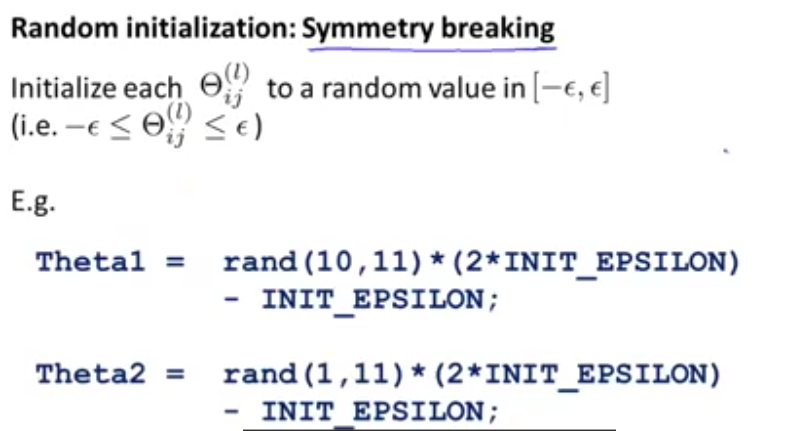

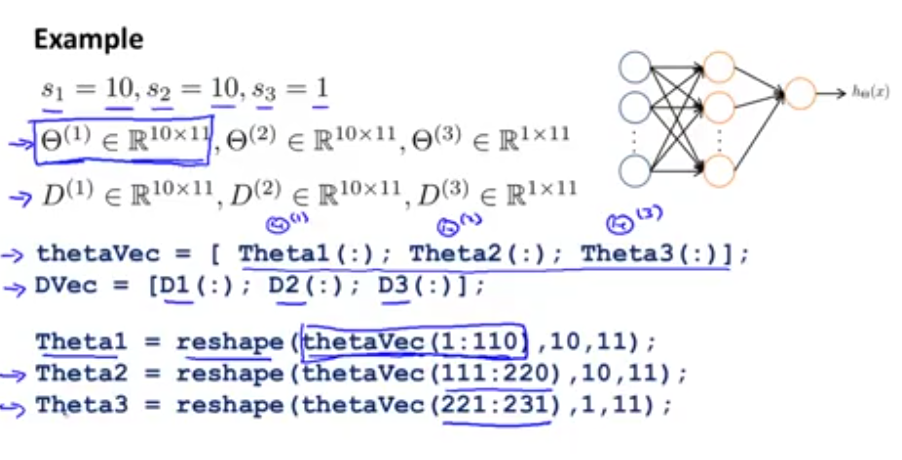

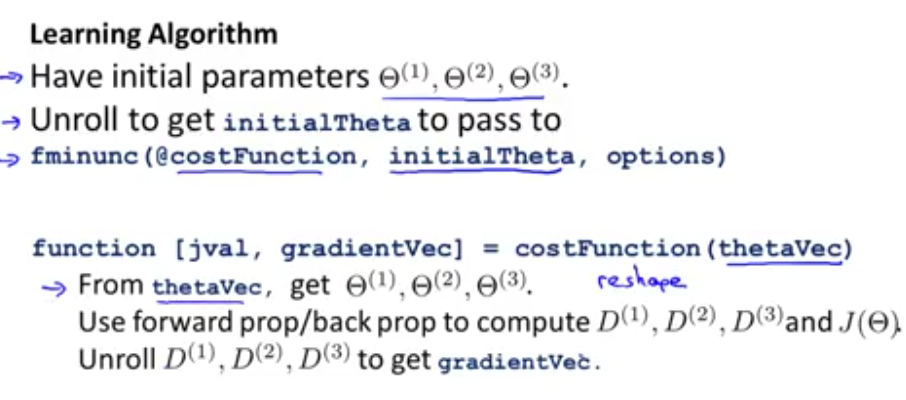

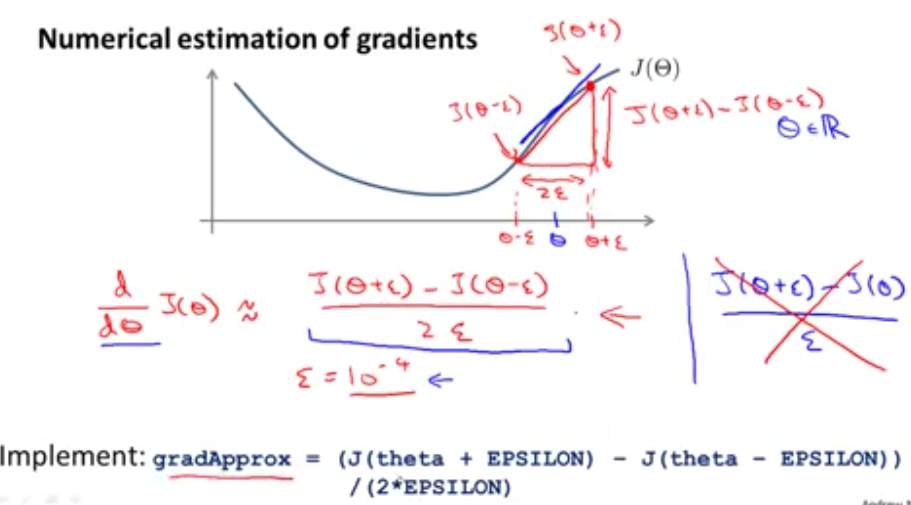

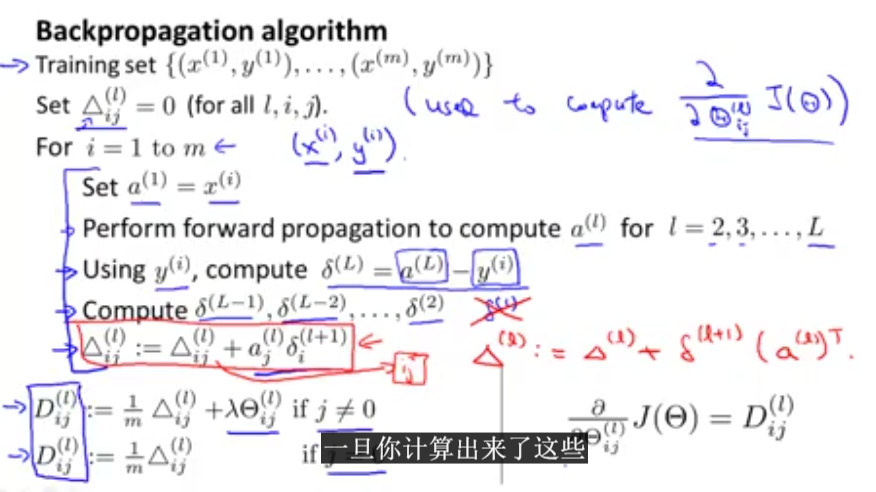

2.代价函数最小化的算法

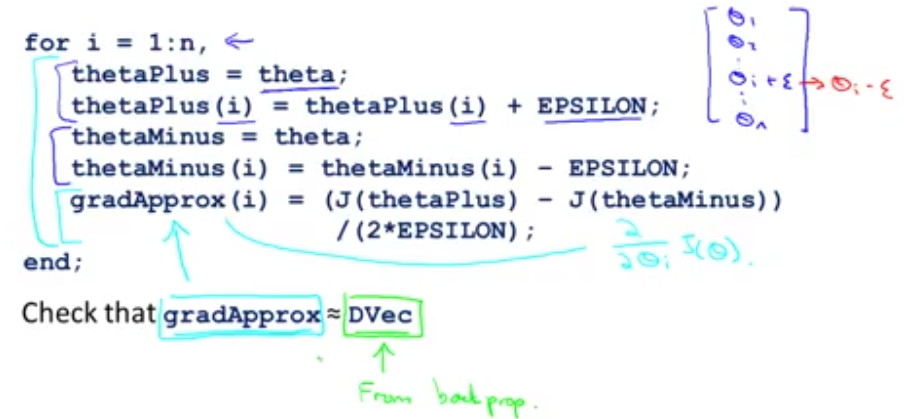

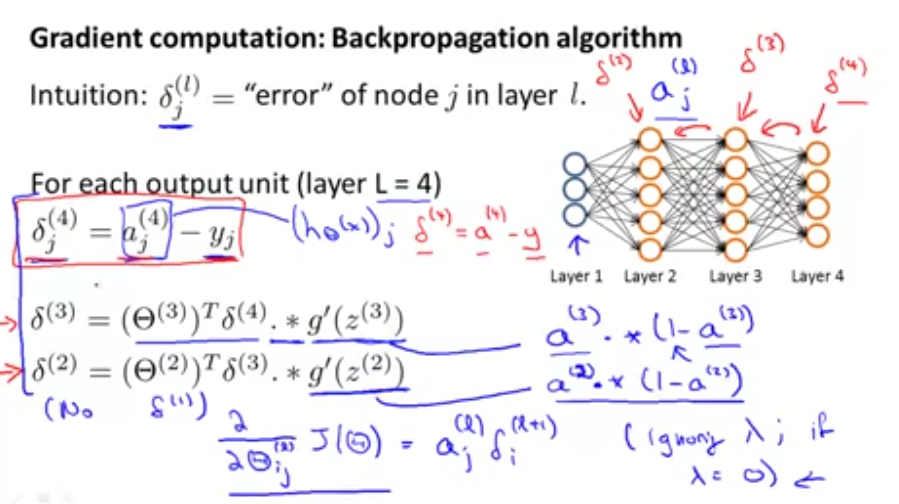

(1)gradient computation

说到gradient computation我们并不陌生,主要是对代价函数求导。

这里我们先要引入反向传播算法的概念,下面是反向传播算法的表达式:

上面的推导过程很复杂,这里老师也没有详细的介绍,不过我们能对推导结果进行应用