文章目录

深度学习之神经网络(二)

一、神经网络起源:线性回归

正向就是计算结果,反向就是训练

(一)概念

(二)一个线性回归问题

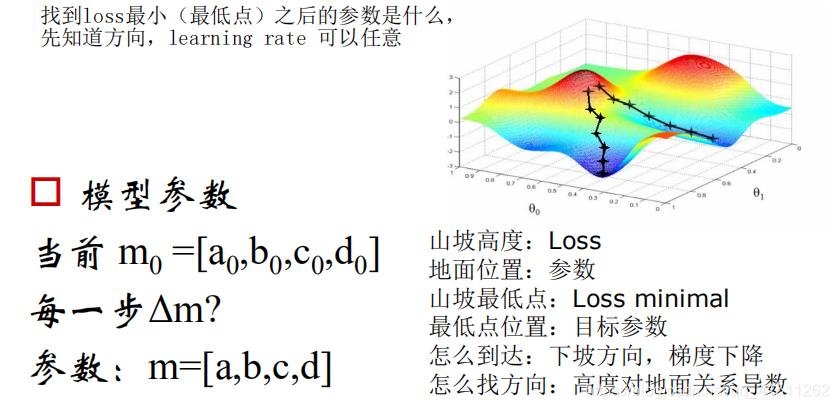

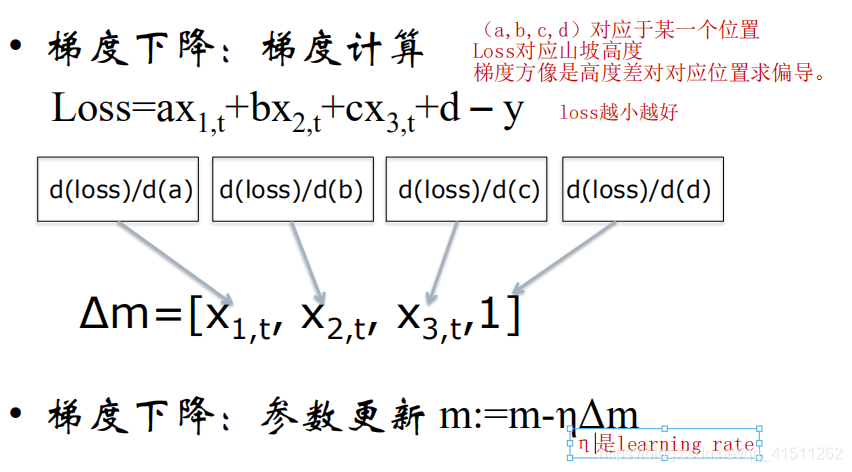

(三)优化方法:梯度下降

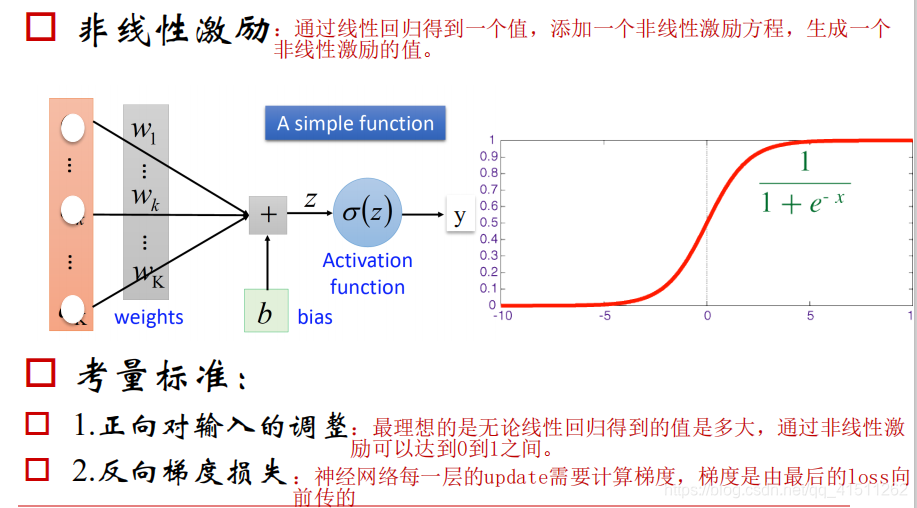

二、从线性到非线性

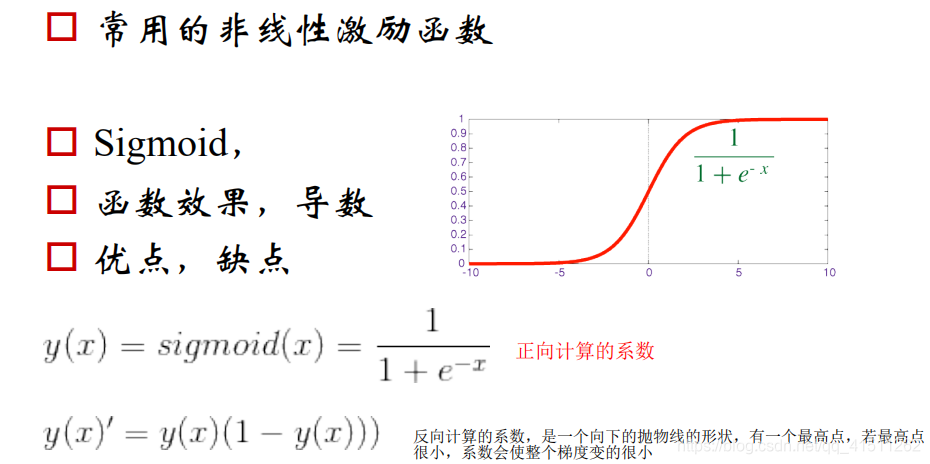

(一)常用的非线性激励函数:Sigmoid

(二)tahn函数

(三)ReLU函数

三、神经网络的构建

(一)神经元的“并联”和“串联”

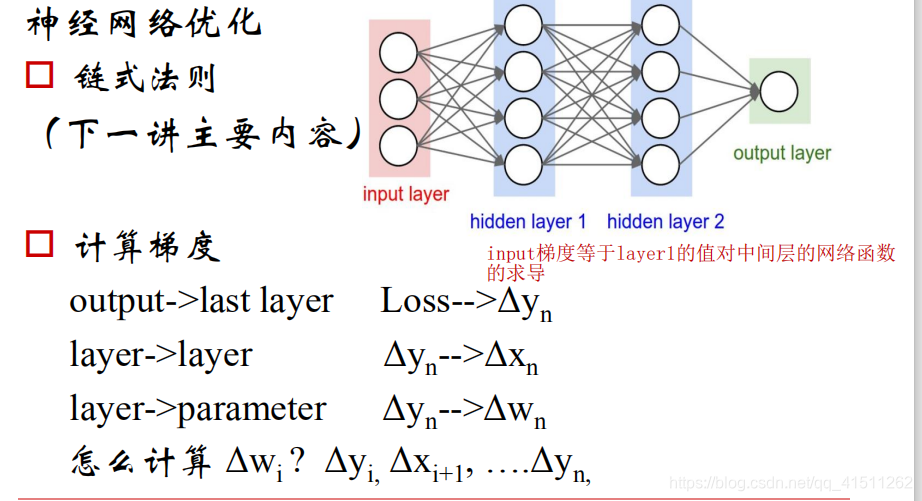

(二)神经网络优化

四、神经网络的“配件”

(一)损失函数

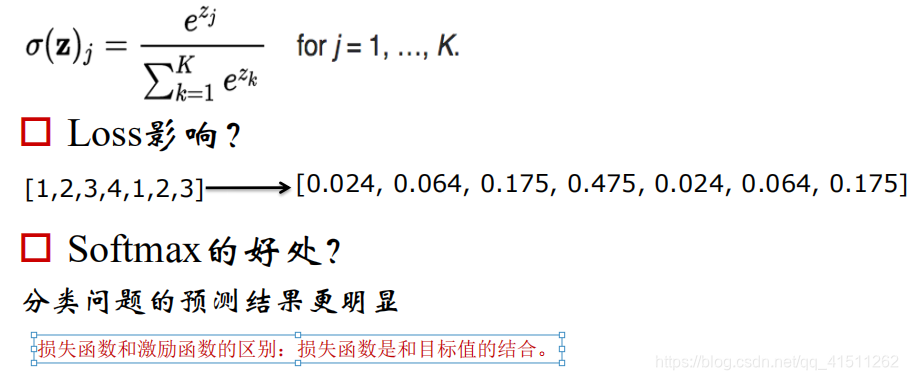

(1)Softmax

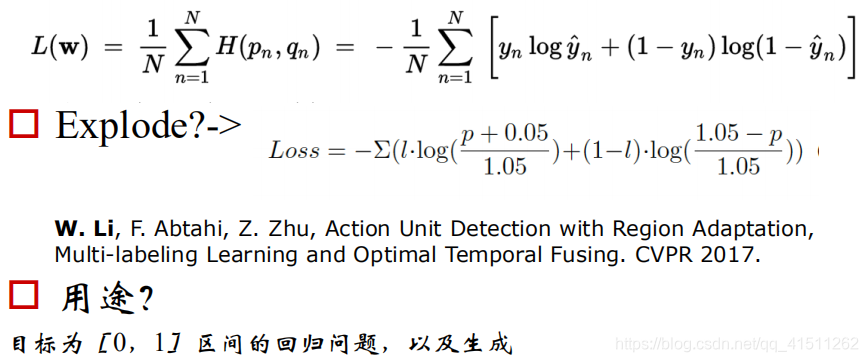

(2)Cross entropy

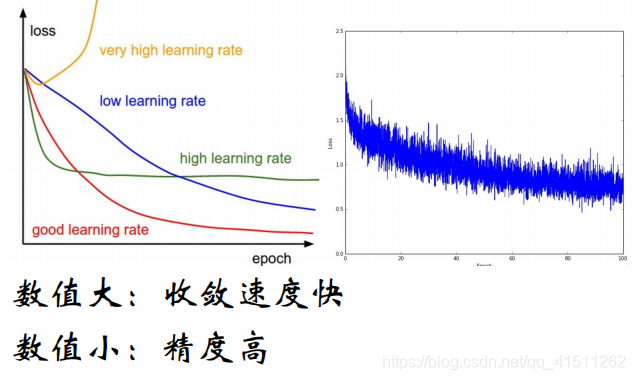

(二)学习率Learning rate

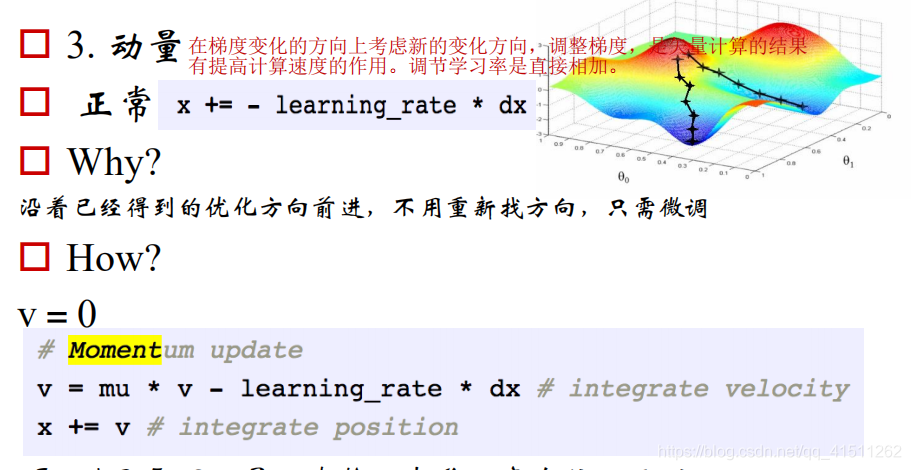

(三)动量

(四)过拟合应对

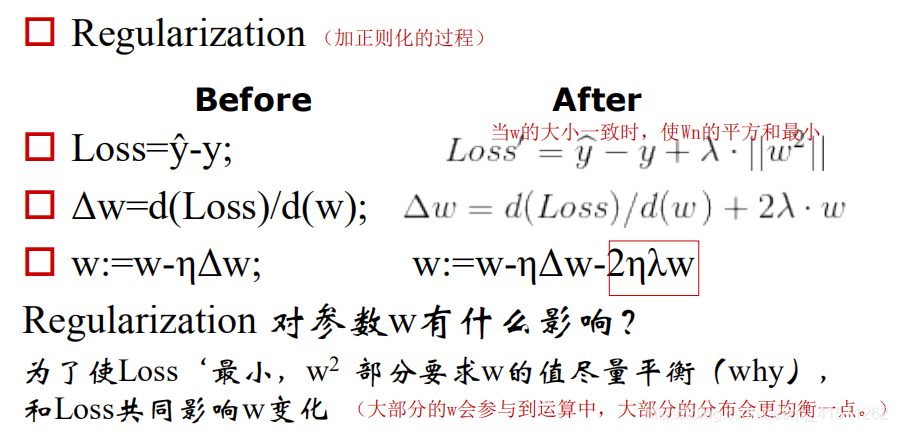

(1)正则化

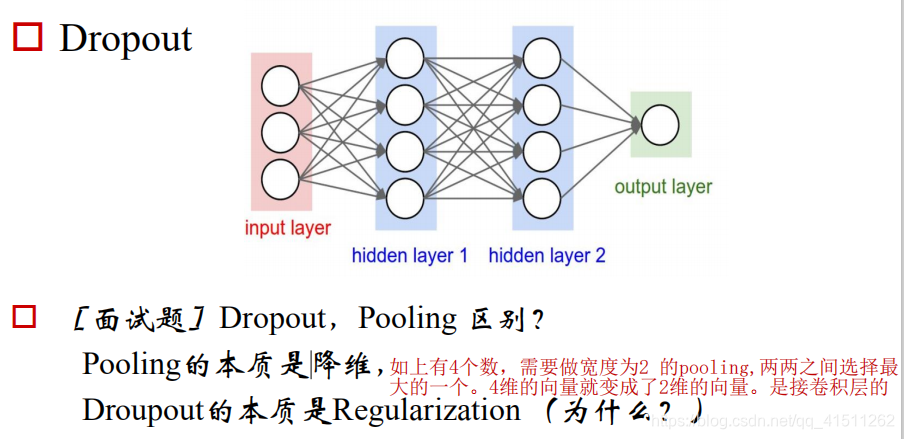

(2)Dropout和pooling

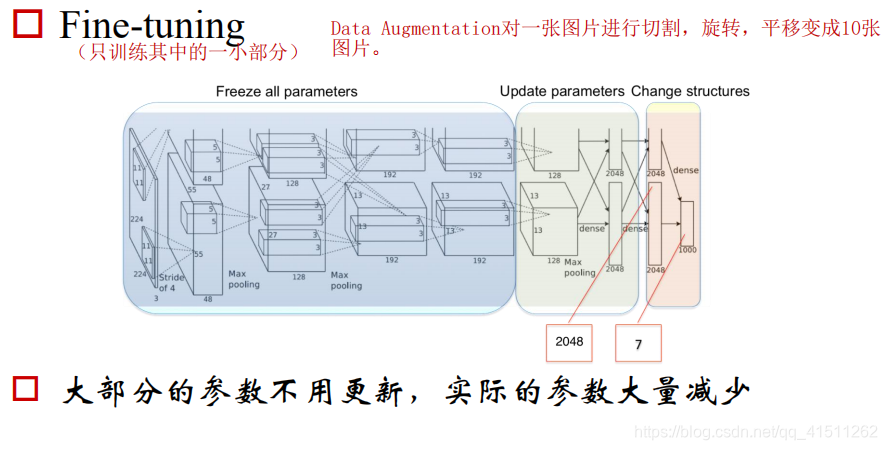

(3)Fine-tuning/Data Augmentation