《Deep Residual Learning for Image Recognition》论文解读。

本文来自于MSRA,作者是大神何凯明。

概述

本文提出了一种Residual learning的框架,和以前的深层模型比起来,层数要深很多。在ImageNet2015的比赛中,作者使用了152层的网络取得了第一名。

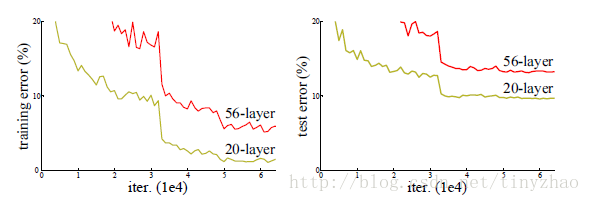

随着网络结构的加深,带来了两个问题:一是vanishing/exploding gradient,导致了训练十分难收敛,这类问题能够通过normalized initialization 和intermediate normalization layers解决;另一个是被称为degradation的退化现象。对合适的深度模型继续增加层数,模型准确率会下滑(不是overfit造成),training error和test error都会很高,相应的现象在CIFAR-10和ImageNet都有出现。

结构

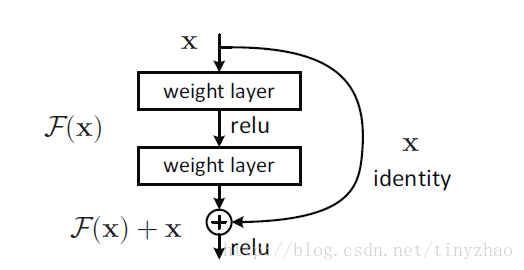

作者提出了residual learning的网络结构。

假设潜在映射为H(x),结构中的非线性层拟合残差

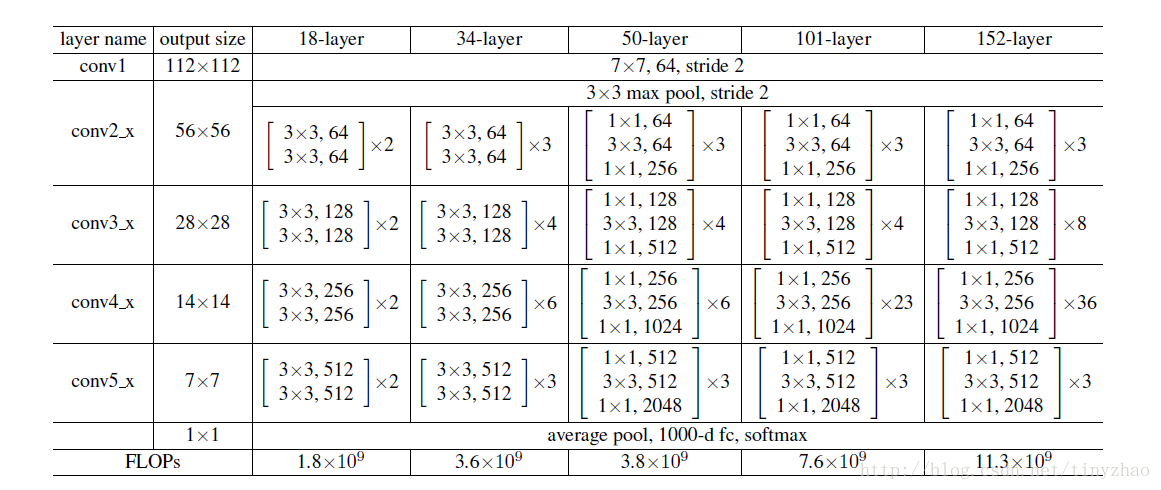

ImageNet中152层的残差网络如下所示:

和之前的论文相比,1*1卷积在网络中有着大量的使用,在网络最后也是使用了average pooling。

总结

残差网络结构简单,解决了极深度条件下深度卷积神经网络性能退化的问题,分类性能表现出色。从ILSVRC 2015至今半年多的时间里,残差网络的广泛使用已推进计算机视觉各任务的性能升入新的高度。