scrapy初识

scrapy介绍就不啰嗦了,直接进入正题。

scrapy的安装

说实话,刚开始安装的时候费了好大力气,最后还是问了下度娘,才安装成功,现在给大家分享下我安装scrapy的心路历程;

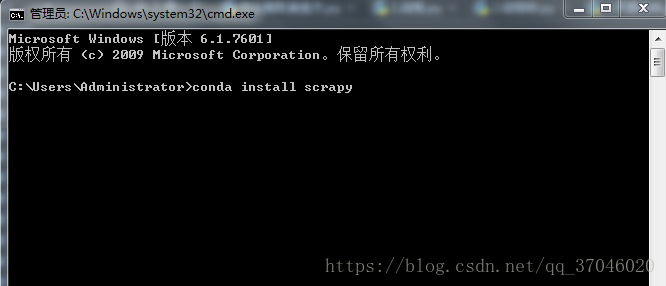

首先,电脑上必须安装的有Anaconda,然后只需要在终端输入 conda install scrapy ,一句话OK,简单粗暴;

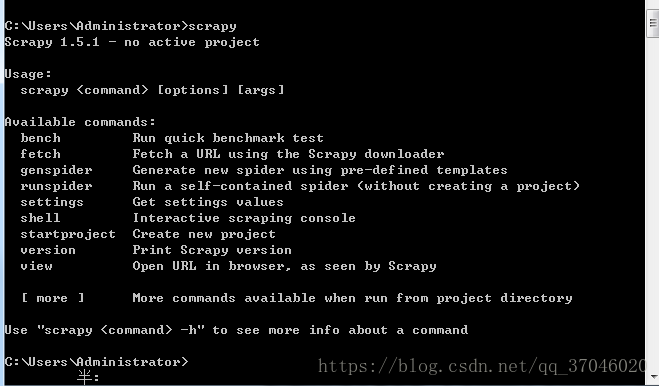

测试scrapy是否安装成功,在终端中直接输入scrapy,如果安装成功会显示如下图:

安装成功之后就可以开始撸代码了。

scrapy的使用

首先让我们在桌面创建一个爬取百度首页的项目;

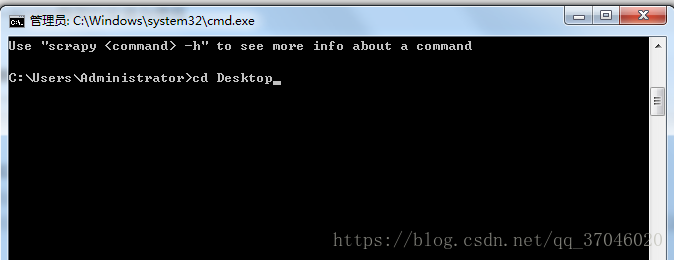

第一步,先把路径移动到爬虫创建的目录下(如下图)这里我是直接在桌面直接创建的:

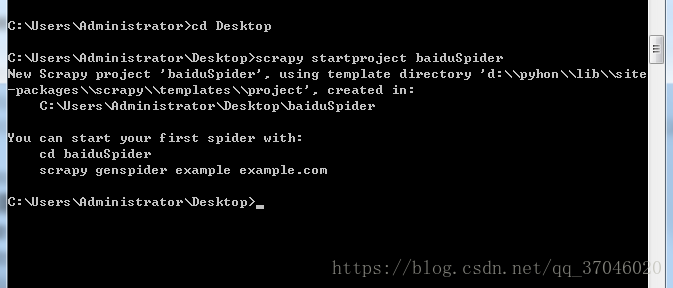

然后使用命令“ scrapy startproject 项目名称 ” 创建项目:

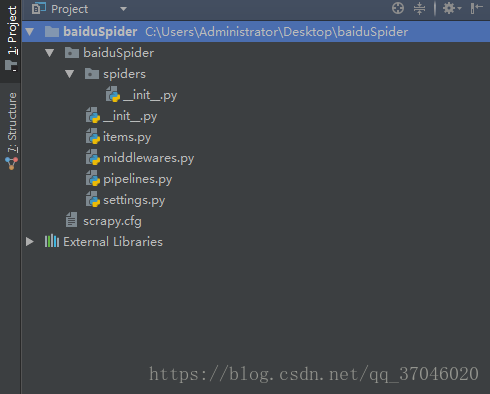

完成项目创建后使用PyCharm打开这个项目,会发现项目里面的目录结构如下图:

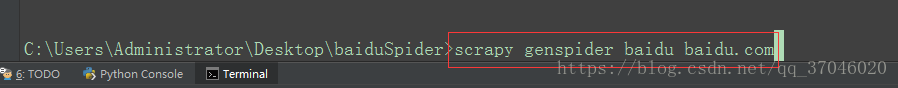

然后打开PyCharm自带的终端,输入“ scrapy genspider baidu baidu.com” 来创建一个爬取域名baidu.com的baidu文件:

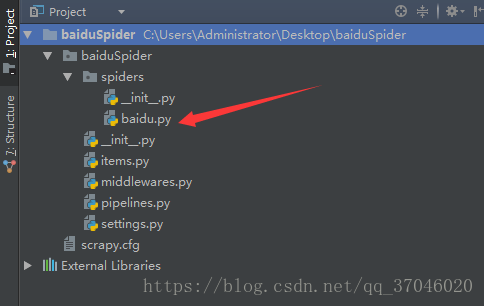

创建后目录结构下spiders文件夹内会出现所创建的文件:

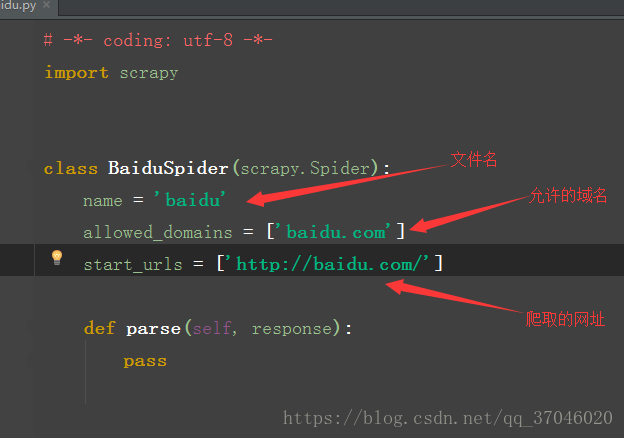

打开这个文件,显示如下图:

之后就可以尽情的撸代码了!!!