-

第一章 统计学习方法概论

目录

统计学习

-

统计学习特点

1.平 台:计算机及网络

2.研究对象:数据,是数据驱动的学科

3.目 的:对数据进行预测和分析

4.中 心:方法,构建模型并应用模型进行预测和分析

5.交叉学科:概率论、统计学、信息论、计算理论、最优化理论及计算机科学等多个领域的交叉学科。

-

统计学习对象

1.面向的对象是数据(离散和连续)

2.数据-----提取数据特征-----抽象数据模型-----发现数据中的知识-----对数据进行分析和预测

-

统计学习目的

1.对数据-尤其是未知数据 进行预测和分析

2. 通过构建概论统计模型

3.考虑学习什么样的模型和如何学习模型

-

统计学习分类

1.监督学习(supervised leaning)

2.无监督学习(unsupervised leaning)

3.半监督学习(semi-supervised leaning)

4.强化学习(reinfoucement leaning)

-

统计学习方法三要素

1.统计学习方法=模型+策略+算法

2.模型(model):找到一个能够解决问题的条件概率或者决策函数。

3.策略(strategy):找到一个能够可以优化模型(或者衡量模型的)损失函数(比如0-1损失)

4.算法(algorithm):找到一种可以优化损失函数的方法(比如:梯度下降法)

-

统计学方法步骤

1 得到一个有限的训练数据集

2 确定假设空间(即所有可能的模型)

3 确定选择模型的准则(即策略)

4 实现求解最优化模型的算法(即算法)

5 选择最优模型

6 利用最优模型对新来的数据进行预测和分析

监督学习

1.监督学习是本书的主要学习内容

2.监督学习从训练数据(traning data)集合中学习模型,对测试数据(test data)进行预测

训练数据由输入(特征向量)输出对组成,通常表示为

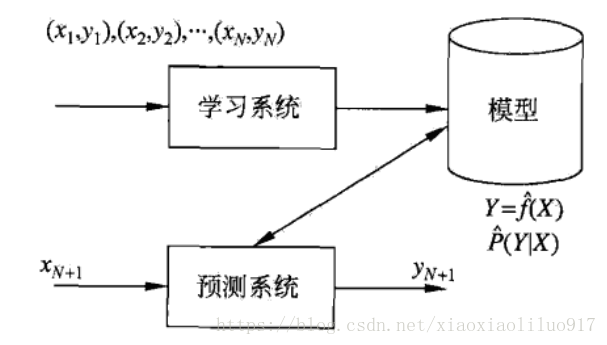

假设输入变量用X表示,输出变量用Y表示,并假设输入与输出的随机变量X和Y满足联合概率分布P(X,Y),监督学习问题的模型如下所示:

这个模型可以理解为:将训练集输入到学习系统—->根据决策方法学习一个最优的模型—–>利用这个最优的模型对新来的数据进行预测。

预测任务分类

根据输入、输出变量的不同可以把预测任务分为以下三类:

1.回归问题-----输入变量与输出变量均为连续变量的预测问题;

2.分类问题------输出变量为有限个离散变量的预测问题;

3.标注问题------输入变量与输出变量均为变量序列的预侧问题.

4.他们的问题模型只需要把上图中的“预测系统”改为“分类系统”、“标注系统”即可

三要素

-

模型

在监督模型中,模型就是所要学习的条件概率或者决策函数

非概率模型:

概率模型:

-

策略

-

损失函数

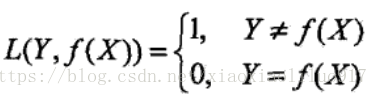

损失函数(loss function)或代价函数(cost function)是用来度量模型的预测能力的。损失函数是 f (X)(预测值)和Y(真实值)之间的非负实值函数(因为两者之间的差值可以理解为两者之间的距离,是非负的。),记作L(Y, f (X)) 。

常用损失函数

(1) 0-1损失函数(0-1 loss function)

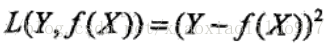

(2) 平方损失函数 (quadratic loss function)

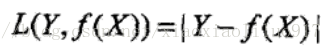

(3) 绝对损失函数 (absolute loss function)

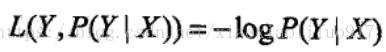

(4) 对数损失函数(logarithmic loss function)或对数似然损失函数 (loglikehood loss function)

当然还存在其他的损失函数比如:指数损失函数或者Hinge Loss等。损失函数值越小,代表模型越好,模型出现的误差越小。

-

经验损失或经验风险

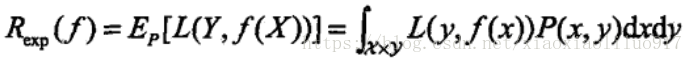

由于模型的输入、输出(X,Y)是随机变量,遵循联合分布P(X,Y),所以损失函数的期望是:

这是理论上模型f (X)关于联合分布P(X,Y)的平均意义下的损失,称为风险函数(risk function)或期望损失(expected loss)。学习的日标就是选择期望风险最小的模型。由于,一方面根据期望风险最小化模型要用到联合概率分布,另一方面联合分布又是未知的,所以监督学习就成为一个病态问题!

在此我们提出另外一个概念:经验风险。(根据我自己的理解,“经验”一般是平均意义下东东,毕竟经验是需要积累的。)

模型f(x)关于训练数据集的平均损失称为经验风险(empirical risk)或经验损失(empirical loss):

期望风险Rexp(f)是模型关于联合分布的期望损失,经验风险Remp(f)是模型关于训练样本集的平均损失。根据大数定律,当样本容量N趋于无穷时,经验风险趋于期望风险。所以一个很自然的想法是用经验风险估计期望风险。但是,由于现实中训练样本数目有限,甚至很小,所以用经验风险估计期望风险常常并不理想,要对经验风险进行一定的矫正.这就关系到监督学习的两个基本策略:经验风险最小化和结构风险最小化.

-

经验风险最小化

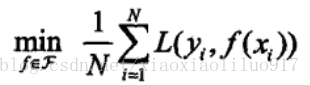

经验风险最小化(empirical risk minimization, ERM),即求解最优化问题:

样本容量足够大时,经验风险最小化能保证有很好的学习效果(比如一个人的经验积累越多,判别力肯定会越好)但是当样本容量很小的时候,经验风险最小化的学习效果未必很好,可能会产生“过拟合(over-fitting)”现象。因此这时需要结构风险最小化。 例子:极大似然估计

-

结构风险最小化

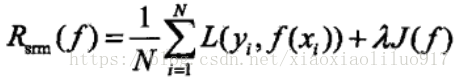

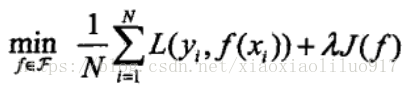

结构风险最小化(structural risk minimization, SRM)(等价于正则化)是为了防止过拟合,在经验风险上加上表示模型复杂度的正则化项(regulatizer)或罚项(penalty term ),定义是:

其中J (f)为模型的复杂度(有的时候可以理解为模型所需要的参数个数?)

其中

>=0是系数,用于权衡经验风险和模型复杂度

结构风险小需要经验风险与模型复杂度同时小。例子:贝叶斯估计中的最大后验概率估计

-

算法

统计学习基于训练数据集,根据学习策略,从假设空间选择最优模型,最好需要考虑用什么计算方法来求解最优模型 学习模型的具体计算方法。统计学习问题归结为最优化问题,统计学习的算法成为求解最优化问题的算法。如何找到全局最优解并使得求解的过程非常高效!