论文:

Inception[V2]: Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift

https://arxiv.org/abs/1502.03167

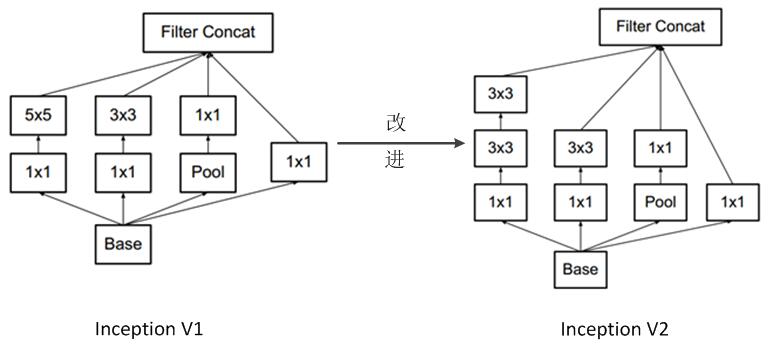

Inception v2的网络,代表作为加入了BN(Batch Normalization)层,并且使用2个3*3替代1个5*5卷积的改进googleNet。

相对一Inception v1改进:

1.加入了BN层,减少了InternalCovariate Shift(内部神经元的数据分布发生变化),使每一层的输出都规范化到一个N(0, 1)的高斯,从而增加了模型的鲁棒性,可以以更大的学习速率训练,收敛更快,初始化操作更加随意,同时作为一种正则化技术,可以减少dropout层的使用。

2.学习VGG用2个3x3的conv替代5x5的conv,在降低参数的同时建立了更多的非线性变换,使得 CNN 对特征的学习能力更强

参考: